L’optique en 2005

De la correction de la vue à la satisfaction des besoins en télécommunications, du télescope traquant le rougissement des galaxies lointaines aux disques compacts de nos baladeurs, l’optique est présente à des endroits tellement divers que son image s’en trouve parfois brouillée. Il faut donc rappeler que son statut premier est d’être une branche mère de la physique, celle qui étudie la nature de la lumière et son interaction avec la matière, celle qui a mis au grand jour la fondamentale dualité entre onde et corpuscule sur laquelle s’est bâtie la physique quantique. Mais de plus, l’optique est particulièrement riche d’applications scientifiques comme économiques, elle intervient en effet, souvent de façon discrète, dans des situations étonnamment nombreuses.

Nous illustrons ici par quelques exemples importants les moteurs de sa diversification au cours de ces dernières décennies.

Qu’est-ce que l’optique ?

Au fil des contacts qu’il peut nouer au fil de ses activités, le spécialiste d’optique constate aisément que l’idée qu’ont de l’optique nos contemporains en reflète la diversité : pour beaucoup, la science des lois de Descartes a trouvé son épanouissement dans l’appareil photographique et le microscope, instruments du xixe siècle, aujourd’hui encore indispensables mais dont l’industrie a pratiquement déserté l’Europe.

Pour l’ancien » taupin » du milieu du xxe siècle, l’optique géométrique, agrémentée des subtilités de l’anisotropie cristalline, a fourni la matière aux casse-têtes les plus fascinants des annales de concours. Pour l’investisseur en Bourse, les valeurs de l’optique sont intimement mêlées à l’éclatement de la bulle économique dont les soubresauts nous atteignent encore : il pourra leur préférer le leader mondial de la correction ophtalmique, Essilor.

Les polytechniciens qui choisissent l’École supérieure d’optique comme école d’application sont souvent attirés par la fascination de l’accès immédiat aux énigmes du monde quantique que proposent les paires de photons intriqués et les atomes refroidis par laser, alors que le directeur des études de cette dernière école, analysant les résultats du concours d’entrée, identifie chaque année dans la tête de promotion plusieurs passionnés d’astronomie.

Tous ces aspects appartiennent à la réalité de l’optique, font ressortir sa diversité et montrent que, de ce fait, ses métamorphoses depuis quelques décennies la rendent difficile à cerner.

Avant d’illustrer par quelques exemples frappants les moteurs de ces évolutions, il n’est donc pas inutile de rappeler que le mot » optique » recouvre bel et bien un concept stable et clair : il s’agit, selon la Commission internationale d’optique et l’Académie nationale des sciences américaine, de » la discipline scientifique et technique qui couvre les phénomènes physiques associés à l’émission, la manipulation, la modulation, la transmission et la détection de la lumière, ainsi que toutes leurs applications ; l’optique s’étend de part et d’autre de la partie visible du spectre électromagnétique aussi loin que les mêmes concepts restent utilisables « . Cette définition large permet d’englober les néologismes qu’ont imposés les innovations à cheval entre l’optique et de l’électronique, tels que » optoélectronique « , » photonique » et » optronique « .

Leur émergence témoigne de la sensation de nouveauté que suscitent la fibre optique, l’hologramme ou le gyromètre laser : il s’agit assurément d’extensions de l’optique par rapport à ce que la technique mettait à notre disposition voici, par exemple, cinquante ans. Une analyse hâtive a même pu donner l’impression que ces termes recouvraient des champs disciplinaires radicalement nouveaux, alors qu’à ce jour l’usage professionnel reste à leur égard aussi indécis que les définitions des dictionnaires. Sans nier l’intérêt de telles nuances, nous insisterons ici sur l’unité du vaste champ de l’optique entendue dans le sens large qui vient d’être énoncé.

L’optique semble par certains aspects très traditionnelle et par d’autres étonnamment moderne : pensons d’un côté aux simples lunettes correctrices de vue, dont on oublie trop les importants progrès, et de l’autre aux télécommunications optiques. La raison de cette situation est qu’en l’espace d’un demi-siècle trois ruptures technologiques majeures, préparées par des décennies de recherche de base en physique et en chimie, en ont décuplé les applications.

La première de ces ruptures n’a rien de spécifique à l’optique : il s’agit de l’irruption de l’outil informatique dans toutes les techniques comme dans la vie professionnelle, qui bien entendu a ouvert de nouvelles possibilités aux techniques optiques.

Les deux autres lui sont propres : il s’agit du laser et de la fibre optique. Nous illustrerons chacune d’elles en faisant ressortir la liaison étroite qui existe en optique entre la recherche sur la nature de la lumière et son interaction avec la matière et les applications actuelles ou potentielles.

Nous soulignerons ainsi sur des exemples le caractère de paradigme que revêt l’optique pour toute la physique : elle dégage, affine, précise, fait évoluer les concepts qui constituent à tout instant l’état le plus évolué de notre vision de la nature, et elle les applique dans des objets qui bouleversent la société.

L’optique et les technologies de l’information

Optique adaptative et résolution ultime

Si les instruments d’optique de jadis atteignaient d’excellentes performances par une maîtrise simultanée de la mécanique, du polissage de verre et du calcul des combinaisons optiques, les systèmes actuels y ajoutent toutes les possibilités de l’électronique et de l’informatique : que serait par exemple sans elles l’optique adaptative, technique désormais universelle dans le domaine astronomique (figure 1) ? Cette expression désigne la capacité d’un système optique à se déformer en permanence pour compenser à chaque instant les défauts introduits par la propagation atmosphérique.

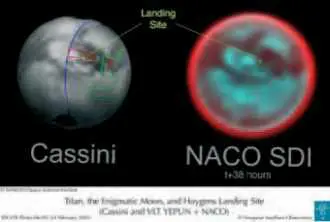

Figure 1

Le satellite de Saturne Titan est vu de la Terre sous un diamètre d’une seconde d’arc, qui est précisément la limite de résolution atteinte par les meilleurs télescopes terrestres perturbés par l’inévitable turbulence atmosphérique : l’image de droite, obtenue par l’Observatoire européen austral (ESO) au Chili illustre l’apport de l’optique adaptative. Il est exceptionnel que, comme ici grâce à la sonde NASA Cassini qui s’est approchée de Titan et s’est posée à sa surface en février 2005, on puisse confronter les résultats de l’optique adaptative astronomique à une “ vérité terrain ” (image de gauche) : l’accord est saisissant.

Plus précisément, on sait que c’est aux turbulences atmosphériques qu’est due la scintillation des étoiles observées à l’œil nu : la lumière d’un corps céleste nous parvient pratiquement non perturbée jusqu’au sommet de l’atmosphère. Mais à la traversée de cette dernière, le jeu des pressions et des vents module l’indice de réfraction de l’air et distord l’onde lumineuse qui le traverse. Il en résulte un phénomène de réfraction à travers les nombreuses couches successives d’un corps transparent mais très épais (l’atmosphère), et l’onde plane arrivée de l’espace au sommet de l’atmosphère terrestre est transformée en arrivant au sol en une onde profondément perturbée tant en phase qu’en amplitude3, avec une échelle d’irrégularité spatiale de l’ordre de 10 cm. L’œil nu ne perçoit qu’une modulation aléatoire de l’intensité perçue des étoiles, et parfois une légère impression de mouvement erratique de l’astre.

Pour le télescope, dont le miroir primaire dépasse largement 10 cm, le phénomène se transforme en une série de grains lumineux bouillonnants, appelés par les astronomes les tavelures et en anglais speckle, qui se substituent à la tache d’Airy que les cours élémentaires assignent à la diffraction par l’ouverture circulaire du miroir. La tache formée par l’ensemble de ces grains est grande devant la tache d’Airy d’un instrument parfait, d’où à la fois une perte de résolution et une perte de luminosité. L’idée de base de l’optique adaptative consiste à mesurer l’état instantané de l’atmosphère, puis avant qu’il se soit modifié, c’est-à-dire en l’intervalle de quelques millisecondes, à déformer l’optique du télescope pour compenser aussi exactement que possible la perturbation atmosphérique. Les miroirs primaires sont en général grands et lourds, il est plus facile de déformer un miroir secondaire, plus léger, ou d’interposer dans la formule optique du télescope un composant spécialisé dans cette tâche de compensation. Les équipes et industriels français (Observatoire de Paris, ONERA, Sagem en particulier) ont joué un rôle essentiel dans le développement de l’optique adaptative jusqu’au niveau qu’il atteint maintenant.

Il va sans dire qu’une telle technique serait impensable sans l’ordinateur tel que nous le connaissons en 2005. Là où Foucault, utilisant la méthode d’analyse des surfaces d’onde aberrantes à laquelle il a laissé son nom, aurait passé des heures, un logiciel convenable dépouillant les données d’une caméra numérique met une milliseconde. Ses données sont transmises à un algorithme d’asservissement, qui à son tour provoque l’application des signaux de commande voulus aux éléments déformables, eux-mêmes d’ailleurs de plus en plus perfectionnés. Actuellement encore, les performances atteintes par l’optique adaptative s’améliorent avec l’accroissement de la qualité de calcul : ainsi, l’effet de la turbulence est d’autant plus fort et d’autant plus rapidement variable que la longueur d’onde est plus petite ; initialement utilisée dans l’infrarouge, l’optique adaptative ne peut atteindre le spectre visible qu’en traitant une masse de données accrue en un temps plus bref : telle est bien la tendance d’évolution que permet la technologie.

L’optique au service de la microélectronique

Le cas de l’optique adaptative montre que l’outil informatique a fait apparaître des résultats étonnants par le développement de techniques optiques inimaginables sans lui. Réciproquement, l’optique joue un rôle crucial dans les progrès incessants de la microélectronique. La photoréduction des masques constitutifs des circuits microélectroniques a donné lieu à des prouesses des techniques optiques, de la conception et construction des objectifs photographiques de loin les plus complexes et les plus perfectionnés jamais imaginés, à l’augmentation de résolution au-delà de la limite de diffraction standard en jouant sur la cohérence partielle, sur l’imagerie d’objets de phase et sur les non-linéarités du milieu photosensible. Ainsi, pour un coût qui reste relativement minime dans le budget de la fabrication des puces électroniques, l’intervention de l’optique est un passage obligé de la chaîne microélectronique.

La nanophotonique

En retour, l’utilisation des microtechnologies et des nanotechnologies donne lieu à l’apparition de composants optiques complètement nouveaux, parfois qualifiés de “nanophotoniques ”. L’importance du recours à des gravures de dimensions inférieures au micromètre est ici claire : tout détail de taille voisine de la longueur d’onde optique influe fortement et de façon peu intuitive sur la propagation de la lumière ; en d’autres termes, la diffraction par de tels détails, décrite par une résolution complète des équations de Maxwell et non pas par les méthodes d’approximation adaptées aux objets plus grands, présente des comportements tout à fait originaux. Deux exemples frappants retiennent l’attention de nombreux physiciens depuis quelques années : les matériaux à bandes interdites photoniques et les tamis à lumière.

On sait qu’en physique du solide la périodicité de l’état cristallin détermine une répartition des niveaux d’énergie présentant des » bandes interdites » séparant des bandes permises habituellement dénommées » bande de valence » et » bande de conduction « , et que cette conséquence de l’équation de Schrödinger en potentiel périodique explique la différence entre isolants, conducteurs et semi-conducteurs. En optique, bien que les équations applicables soient celles de l’électromagnétisme, les équations de Maxwell, et non celle de Schrödinger, des phénomènes semblables se manifestent en présence d’une périodicité du matériau : c’est ce que, prolongeant des travaux précurseurs de Léon Brillouin, E. Yablonovitch, d’ATT Bell Laboratories, a montré en 1987.

Figure 2

Sélecteur-extracteur de longueur d’onde à cristal photonique bidimensionnel en optique guidée. À gauche, schéma de principe : une fois lancées le long du guide, les longueurs d’onde adaptées à la largeur locale du guide subissent une transition vers un mode qui peut s’extraire latéralement “ sur place ” ; au milieu, photographie du dispositif complet ; à droite, photographie de la section du guide du milieu encadrée par le rectangle noir. L’espace entre trous est de 400 nm. Résultat E. Schwoob, H. Benisty, C. Weisbuch, Laboratoire Charles Fabry de l’Institut d’optique et École polytechnique. Réalisation Opto +, Heinrich Hertz Institute.

Il existe donc des matériaux à » bandes interdites photoniques « , qui se distinguent par la spécificité que la lumière d’une région spectrale donnée ne peut s’y propager dans aucune direction, et ce bien qu’ils ne soient pas absorbants. Cette propriété n’est obtenue que par une structuration périodique constituée de motifs de taille voisine de la longueur d’onde. La fabrication de tels » cristaux photoniques » reste un défi aux longueurs d’onde de l’optique visible (0,4 à 0,7 micromètre environ) et même des télécommunications optiques (autour de 1,5 micromètre). Pour de la lumière arrivant de l’extérieur, un milieu à » bande interdite photonique » se comporte comme un miroir parfait et sans perte. Il est facile d’imaginer l’intérêt qu’il y aurait à les réaliser, puis à enfermer une source de lumière au cœur de telles structures, puis enfin à » ouvrir la vanne » par une commande électronique. D’ores et déjà, des réalisations limitées – par exemple, à deux dimensions – permettent d’améliorer le rendement de diodes électroluminescentes ou de séparer les longueurs d’onde dans des signaux de télécommunications optiques (figure 2).

Dans les » tamis à lumière « , une couche métallique opaque est percée d’une matrice périodique de trous de taille sub longueur d’onde et de forme contrôlées. Pour une longueur d’onde donnée, il peut arriver que la fraction de lumière transmise excède sensiblement la fraction d’aire occupée par les trous. Ce phénomène est apparu d’autant plus paradoxal qu’il a été découvert par voie expérimentale et de façon accidentelle : le mérite en revient à une série de travaux menés notamment par Ebbesen depuis 1992. La résolution des équations de Maxwell fournit l’explication en mettant en jeu une résonance des charges dans le métal connue sous le nom de plasmon, mais le phénomène reste néanmoins choquant pour l’intuition et fait partie des différents effets d’optique électromagnétique qui attirent actuellement une recherche intense, en attendant de trouver éventuellement des applications. À ce sujet, il convient de remarquer que c’est bien la disponibilité d’outils technologiques, aussi bien dans le domaine des nanofabrications que dans celui des moyens de calcul, qui a suscité l’intérêt sur des thèmes dont la richesse avait échappé aux recherches pendant plus d’un siècle alors que la théorie sous-jacente était connue.

L’ère du laser

Apparu voici près d’un demi-siècle, le laser est le fruit de travaux fondamentaux qui remontent à la découverte de l’émission stimulée par Einstein en 1916, dans la lignée des recherches sur le rayonnement du corps noir : pour expliquer la loi de Planck en termes d’émission et d’absorption de photons par une assemblée d’atomes, Einstein a introduit la possibilité qu’un photon en interaction avec un atome excité provoque sa désexcitation avec émission d’un second photon de même énergie et de même impulsion. Il fallut encore l’invention, par A. Kastler et J. Brossel en 1950, du pompage optique, qui permet d’amener un grand nombre d’atomes simultanément dans un état excité, puis la réalisation d’un tel pompage dans une cavité résonnante pour que Javan et Maiman obtiennent en 1960 les premiers lasers, sources de rayonnement de très haute cohérence, c’est-à-dire spectralement pures, et très directifs.

À l’étonnement suscité par l’observation du phénomène succéda, en même temps que les types de laser se diversifiaient, une moisson de découvertes, dont la première fut sans doute celle de l’optique non-linéaire : une onde lumineuse suffisamment intense peut provoquer l’émission de fréquences (et donc de longueurs d’onde) différentes de celle d’éclairage, le cas le plus manifeste étant la » génération de second harmonique « . Plus généralement, l’optique non-linéaire est le domaine où un faisceau lumineux modifie l’indice de réfraction et l’absorption des milieux qu’il traverse. Les non-linéarités constituent un outil très puissant d’étude de la matière et de l’interaction entre lumière et matière, mais aussi un outil permettant de » contrôler la lumière par la lumière « .

De nos jours, on n’imagine pas toujours bien la diversité des applications du laser. Si les télécommunications optiques, dont il sera à nouveau question plus bas, et le disque compact font partie des objets quotidiens où le laser joue un rôle central, l’usinage par laser, le traitement des affections rétiniennes, la gravure de cornée comptent également parmi celles qui ont atteint une large notoriété. Le plus petit laser mesure un micromètre cube, le plus grand, destiné à l’étude des plasmas très denses capables d’induire des réactions nucléaires, occupe plusieurs bâtiments hectométriques ; il est construit en deux exemplaires cousins, la National Ignition Facility aux États-Unis et le Laser Mégajoule près de Bordeaux. Plutôt que de continuer d’égrener une longue liste d’applications, nous insisterons ici sur l’intérêt scientifique du laser en évoquant un domaine de recherche physique qui en est directement issu : les atomes froids.

Atomes refroidis par laser

Le refroidissement d’atomes par laser est un vaste champ dont le développement a valu le prix Nobel de physique 1997 à trois de ses pionniers, Cohen-Tannoudji, Phillips et Chu. Le principe bien connu de la conservation d’impulsion lors des collisions mécaniques permet de comprendre comment arrêter des atomes dont la vitesse initiale, à température ambiante, est de plusieurs centaines de mètres par seconde : dans une enceinte où règne un vide poussé, on injecte un jet atomique de faible densité créé, par exemple, en chauffant dans un four un métal tel que le rubidium. Les atomes ainsi évaporés quittent le four par un orifice vers lequel on dirige un faisceau laser. Si la longueur d’onde est convenablement choisie, les photons du laser sont absorbés par les atomes au cours d’un choc frontal qui ralentit un peu l’atome. Au bout de quelques millions de collisions, au cours desquelles on aura pris soin d’ajuster la longueur d’onde du laser pour compenser l’effet Doppler, les atomes peuvent être arrêtés. Des techniques de piégeage par champ magnétique permettent alors de les emprisonner sous la forme de nuages de quelques millimètres cubes de matière diluée comme un gaz mais placée à une température extrêmement basse – on se souvient que la température d’un gaz est une mesure statistique de la vitesse moyenne de ses atomes ou molécules.

La technique, développée à partir des années 1980, a rapidement atteint une certaine maturité et permis d’ouvrir des études spectroscopiques de précision inégalée et surtout un résultat remarquable, la manipulation des fonctions d’onde des atomes. On sait en effet que la longueur d’onde de De Broglie associée à un atome, concept fondateur de la mécanique ondulatoire et de la mécanique quantique, est inversement proportionnelle à sa vitesse. Un atome de rubidium à la température de quelques nanokelvins a ainsi une longueur d’onde d’un micromètre, que des dispositifs bien conçus permettent d’observer. On atteint la possibilité de faire interférer des atomes et plus généralement de faire subir à leurs fonctions d’onde toutes les opérations habituelles des ondes lumineuses : c’est le domaine de l’optique atomique. Son succès le plus spectaculaire et le plus enthousiasmant pour les chercheurs est la » condensation de Bose-Einstein « , véritable nouvel état de la matière atteint aux températures les plus froides, observé pour la première fois en 1995 par Ketterle, Cornell et Wiemann (prix Nobel de physique 2001). L’effet se manifeste lorsque la longueur d’onde des atomes devient de l’ordre de la distance atomique, ce qui se traduit par la création d’un état collectif où les atomes sont tous dans le même état quantique (figure 3).

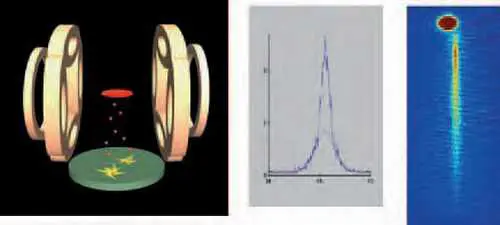

Figure 3

Condensation de Bose-Einstein d’hélium métastable obtenu pour la première fois par l’équipe d’Optique atomique du Laboratoire Charles Fabry de l’Institut d’optique en 2001. L’image de gauche représente le système expérimental, dont l’originalité est d’utiliser un dispositif permettant de détecter un par un les atomes d’hélium métastable (en rouge) relâchés depuis le piège magnétique où ils sont confinés et refroidis à des températures inférieures au microkelvin. On peut ainsi obtenir (image du milieu) l’histogramme de distribution de vitesses des atomes, qui présente une forme gaussienne pour une distribution thermique (Maxwell-Boltzmann). Lorsque la condensation de Bose- Einstein est atteinte, on voit apparaître un pic correspondant aux atomes condensés dans un état quantique unique. Ce phénomène est analogue à l’effet laser dans lequel tous les photons “ condensent ” dans un seul mode du champ électromagnétique, et on commence à voir apparaître des lasers à atomes (image de droite).

Illustrations Groupe d’optique atomique, LCFIO.

Un point mérite d’être souligné ici : alors que les études sur les atomes froids et sur la condensation de Bose-Einstein continuent de se multiplier au niveau le plus fondamental, tant par la théorie que sous forme expérimentale, les premières perspectives d’application commencent déjà d’attirer l’attention d’industriels. Si l’utilisation d’interféromètres atomiques comme senseurs inertiels et gravitationnels est encore dans les laboratoires de recherche » académique « , l’horloge atomique à atomes froids est en train d’en sortir. Depuis longtemps déjà, la définition de la seconde est réalisée par la fréquence d’une transition atomique. Plus le nuage d’atomes servant de référence est froid, moins la raie spectrale de référence est perturbée par l’effet Doppler lié aux vitesses aléatoires des atomes individuels : l’intérêt des atomes froids tels que nous venons de les présenter est donc évident. L’effet Doppler écarté, et toute perturbation par un champ électromagnétique de confinement étant à proscrire, la limite de précision dans la détermination de la fréquence d’une transition atomique vient de l’intervalle de temps disponible pour sa mesure ; c’est alors en pratique la chute de l’atome sous le champ de pesanteur qui devient le phénomène limitant. C’est donc un cas où le recours à l’apesanteur se justifie. Les premiers essais, réalisés dans un avion du CNES en vol parabolique, ont constitué la première phase de l’expérience PHARAO (Projet d’horloge atomique par refroidissement d’atomes en orbite), dont le succès a déterminé l’Agence spatiale européenne à l’embarquer en 2007 sur satellite dans le cadre du projet ACES (Atomic clock ensemble in space). L’industrialisation du projet constitue un défi majeur même si elle peut s’appuyer sur l’expérience du GPS, où déjà des horloges atomiques (mais non des horloges à atomes froids) sont mises en œuvre. L’avancement de PHARAO sur ACES est illustré sur la figure 4. Avec une incertitude ne portant que sur le seizième chiffre significatif, l’horloge la plus précise jamais réalisée servira à des tests de relativité et à des mesures astronomiques.

Fibres et télécommunications optiques

La purification de la silice des fibres optiques a permis, en l’espace de quelques années autour de 1970, de faire passer les pertes en ligne de quelques décibels par mètre à quelques décibels par kilomètre. Le record actuel est de 0,15 décibel par kilomètre. L’idée immédiate d’appliquer ce résultat à la transmission des informations se heurta d’abord à l’absence de source adaptée, et il fallut presque une dizaine d’années pour que des diodes laser fiables émettant dans le rouge puissent permettre avec une fibre et une photodiode les premières liaisons expérimentales.

La croissance du débit installé sur une fibre optique unique connut dès lors pendant une vingtaine d’années, jusqu’à la » bulle » économique des télécommunications autour de 2000, une croissance exponentielle à cadence particulièrement soutenue tirée par une demande considérable. Si les télécommunications optiques ont pu soutenir cette croissance, c’est grâce à quatre révolutions technologiques qui, toutes, sont parties de recherches exploratoires pour arriver à des produits industriels : elles méritent à ce titre d’être brièvement évoquées ici. Elles sont exemplaires de la démarche qui part d’une analyse fondamentale (les hauts débits nécessitent l’accès aux fréquences élevées, donc à l’optique si on veut dépasser 1010 bits/s) pour pousser la recherche technologique aux limites ultimes autorisées par les lois physiques, et enfin stimuler l’apparition de produits industriels compatibles avec les réalités économiques.

La liaison optique de 1980 évoquée ci-dessus et limitée à une diode laser, une fibre et une photodiode utilisait de la fibre multimodale à » gros » cœur d’environ 50 micromètres4. Plusieurs centaines de modes pouvaient s’y propager à faibles pertes, mais pas à la même vitesse, occasionnant une déformation du signal préjudiciable à la transmission à grande distance et imposant donc de fréquentes remises en forme du signal. La maîtrise industrielle de la fabrication de fibres monomodales et des composants nécessaires pour les positionner devant la diode laser avec la précision de l’ordre d’un micromètre nécessaire pour éviter les pertes a été la première évolution technologique majeure.

Sensiblement en même temps arrivait également à maturité la technologie des semi-conducteurs composés ternaires et quaternaires nécessaires pour fabriquer des diodes laser émettant à la longueur d’onde des minima d’absorption de la silice, dans l’infrarouge proche vers 1,3 et 1,55 micromètre, région désormais connue pour être la bande spectrale privilégiée des télécommunications. De ces deux avancées est résulté un premier bond en avant de la longueur de tronçon de liaison optique. L’atténuation et la distorsion de signal étant diminuées sans être annulées, il restait nécessaire de détecter le signal en bout de tronçon, c’est-à-dire après quelques dizaines de kilomètres, pour l’amplifier et le réémettre dans le tronçon suivant.

Vers 1990, les travaux concomitants du Français Desurvire aux États-Unis et de Payne en Grande-Bretagne ont permis d’introduire l’amplificateur à fibre dopée : une espèce chimique bien choisie, un ion de l’erbium peut être pompé optiquement vers un niveau excité pour amplifier le signal optique, évitant l’étape de détection et d’amplification électronique.

Alors que ces évolutions ont permis d’installer des liaisons optiques de qualité croissante à coût décroissant, la satisfaction de la demande croissante ne pouvait être assurée que par l’augmentation du débit du canal transmis par la porteuse optique. Bientôt, la complexité des circuits électroniques de détection devint un facteur pénalisant : alors que la bande passante optique disponible dans la bande spectrale des télécommunications se mesure en térahertz, la dynamique des porteurs limite celle des détecteurs à quelques dizaines de gigahertz. Il est donc logique de juxtaposer, dans une même fibre monomodale, plusieurs canaux de longueurs d’onde. Cela impose le développement de circuits optiques intégrés pour injecter ou extraire sélectivement une longueur d’onde d’un ensemble de faisceaux se propageant ensemble : tel est le défi relevé par le multiplexage en longueurs d’onde, déjà illustré sur la figure 2 et désormais universellement utilisé dans les liaisons à longue portée.

Depuis environ l’an 2000, les télécommunications à longue distance sont très majoritairement assurées par voie optique dans des liaisons d’une complexité considérable qui assurent la superposition de paquets de bits codés à des longueurs d’onde différentes, gèrent les non-linéarités optiques provoquées par leur recouvrement et leur croisement, compensent les dispersions linéaires et non-linéaires par des fibres spécialement conçues à cet effet, amplifient et remettent en forme les bits optiques puis séparent les messages à l’arrivée en fonction de leur longueur d’onde. La prochaine évolution prévisible, avec le passage des liaisons commerciales à 40 gigabits par seconde et par canal de longueur d’onde, est la commutation entièrement assurée par voie optique – pour l’instant, les fonctions de routage vers le destinataire sont en effet encore très majoritairement assurées par voie électronique, quitte à être reconverties sous forme optique pour les étapes suivantes.

La Société Nettest (autrefois Photonetics) a mis au point un laser accordable destiné aux tests et à la maintenance des réseaux optiques multilongueurs d’onde. Par accord d’un réseau en cavité étendue, ce laser, baptisé “ Tunics ”, peut se caler sur toute valeur du “ peigne ” des longueurs d’onde normalisées de l’Union internationale des télécommunications et plus généralement sur toute longueur d’onde du spectre des télécommunications optiques ; on identifie sur la photo, à droite, les éléments présentés sur le schéma, à gauche (documents Nettest).

Guidage d’onde, spectroscopie de la silice et des terres rares, non-linéarités optiques, dispersion, interférences, lasers à semi-conducteurs : les progrès des télécommunications optiques sont des victoires des lois de la physique domestiquées par des technologies de pointe. Ces dernières années, un intermède de caractère non technologique a cependant perturbé cette évolution. La croissance de la demande de télécommunications, pour être considérable en raison notamment de la banalisation de l’Internet, a cependant été surestimée par les acteurs économiques, et ce dans une mesure telle que l’anticipation inadaptée des besoins a créé puis fait exploser la » bulle de l’Internet « . Maintenant que cette phase s’achève, il reste un fait : la demande continue de croître et lorsque la surcapacité des liaisons installées en 2001 aura été consommée par le marché, il conviendra à nouveau d’étendre le réseau des télécommunications optiques. Bien entendu, il n’y a aucune incompatibilité, mais au contraire une parfaite et même systématique complémentarité, entre des liaisons à courte distance mises en œuvre par voie hertzienne vers des téléphones ou ordinateurs portables ou électronique vers des téléphones ou ordinateurs fixes et des liaisons à plus longue distance qui prennent le relais par voie optique.

Conclusion

L’optique est si riche qu’on tomberait dans la litanie rien qu’à évoquer la liste des sujets non abordés ici : le lidar et ses applications en mesure de polluants atmosphériques, les impulsions brèves, qui se mesurent parfois en attosecondes (1 as = 10–18s), l’optique des rayonnements synchrotrons et plus généralement l’optique X, les débouchés en sciences de la vie de l’imagerie de fluorescence, la microscopie de champ proche qui a dépassé la limite de résolution réputée fondamentale des microscopes optiques d’avant 1980, les grands interféromètres de détection d’évènements gravitationnels comme le projet franco-italien Virgo, la cryptographie quantique qui fait déjà son entrée sur le marché en haut de gamme du marché de la transmission sûre et, plus prospective, l’information quantique…

Au moment de la bulle de l’Internet, des déclarations un peu schématiques ont affirmé que le xxie siècle serait celui de l’optique. En fait, le mariage des technologies pour satisfaire les besoins de la société est de plus en plus intriqué. L’optique y joue une part croissante. Elle intervient d’ailleurs dans la panoplie des solutions à déployer pour faire face aux défis identifiés comme majeurs pour les prochaines décennies : la sécurité sous tous ses aspects, la santé, l’environnement, la consommation et la fourniture d’énergie, sans oublier la société de l’information et de la communication dont les besoins en capacité de transmission, de stockage, et de traitement de l’information, sont immensément grands, sans limite clairement identifiable aujourd’hui.

_________________________________________

1. Alain Aspect, membre de l’Académie des sciences et de l’Académie des technologies, est directeur de recherche au CNRS et professeur à l’École polytechnique. Pierre Chavel, directeur du Laboratoire Charles Fabry de l’Institut d’optique, est directeur de recherche au CNRS.

2. Le Laboratoire Charles Fabry de l’Institut d’optique, ainsi nommé en hommage au fondateur et premier directeur de l’Institut d’optique, (X 1885), est une unité mixte de recherche du Centre national de la recherche scientifique, de l’Institut d’optique et de l’université Paris-Sud. Il regroupe les recherches menées à l’Institut d’optique, établissement dont la mission d’enseignement est essentiellement menée au sein de l’École supérieure d’optique, école d’application de l’École polytechnique.

3. Le phénomène est analogue à l’effet de vaguelettes à la surface d’une piscine qui dessinent des ombres et des caustiques au fond du bassin.

4. Rappelons que la partie de la fibre optique qui guide la lumière est un » cœur » d’indice de réfraction plus élevé que celui de la gaine. Le nombre de modes guidés par la fibre varie comme le carré du diamètre du cœur ; en dessous d’une valeur limite de l’ordre de quelques longueurs d’onde, un seul mode est guidé.