RENATER, le réseau national de télécommunications pour l’enseignement et la recherche

Il est exposé la façon dont l’Internet s’est d’abord développé au sein du monde universitaire, l’organisation et le fonctionnement du réseau Renater et les évolutions de Renater, car l’Internet continue à évoluer au sein du monde de la recherche.

L’origine universitaire de l’Internet n’est pas fortuite. Les principes qui ont fait le succès de ce réseau sont en effet liés aux choix adoptés par une communauté internationale qui avait besoin pour ses échanges d’un média réellement universel. Ces choix faits par la communauté de la recherche et les comportements propres à cette communauté gardent encore une grande influence dans le développement de l’Internet qui comme on le sait s’est étendu à des millions d’utilisateurs dans le monde.

Il est exposé par la suite la façon dont l’Internet s’est d’abord développé au sein du monde universitaire, l’organisation et le fonctionnement du réseau Renater et les évolutions de Renater, car l’Internet continue à évoluer au sein du monde de la recherche.

Le développement des réseaux et des services de l’Internet dans le monde universitaire

L’Internet a débuté dans les universités et les centres de recherche, où se sont mis en place au cours des vingt dernières années des réseaux de télécommunications reliant au sein de ces organisations l’ensemble des ordinateurs. Les chercheurs, pour communiquer entre eux, ont relié ces réseaux de campus par des liaisons de télécommunication à longue distance et ont ainsi constitué l’Internet d’origine. D’abord apparu aux États-Unis l’Internet s’est rapidement étendu au reste du monde.

Le développement surprenant qu’a connu depuis ce réseau est d’abord dû à deux choix fondamentaux qui ont bousculé les usages adoptés alors par le monde de l’informatique et des télécommunications.

Le premier choix des chercheurs a été de retenir, pour le financement et le fonctionnement de l’Internet, le modèle coopératif de gestion des projets de recherche et des grands équipements scientifiques. Cette approche a permis de s’entendre sur des règles de fonctionnement très simples et très efficaces qui restent encore d’actualité malgré l’arrivée d’acteurs à vocation commerciale. Les principes de la facturation forfaitaire, de l’échange de trafic non payant entre les réseaux et du cofinancement des liaisons entre organisations différentes ont permis d’éviter les longues discussions commerciales entre des partenaires qui étaient plus soucieux de construire un outil de communication international que de se concurrencer.

Le deuxième choix a été l’adoption par les utilisateurs, c’est-à-dire les chercheurs, d’un protocole de communication fédérateur et particulièrement rustique qui a permis de disposer d’une norme de référence acceptée par tous et indépendante des fournisseurs. Ce protocole connu sous le nom de protocole IP (Interconnexion protocol) a permis de disposer en quelque sorte d’un langage commun permettant à tous les ordinateurs de communiquer entre eux, indépendamment de leur conception technique, micro-ordinateurs de type PC, stations de travail ou super-ordinateurs.

Ces choix de principes simples de financement et d’un protocole unique étant faits, la demande des utilisateurs pour un véritable service international et universel a pu être satisfaite. Les conditions de mise en place et de financement des liaisons internationales ont ainsi été grandement facilitées, donnant très rapidement à l’Internet sa dimension internationale.

D’autres types de réseaux s’appuyant sur d’autres protocoles normalisés ou sur les protocoles des constructeurs de matériel informatique existaient depuis très longtemps au sein des entreprises par exemple. Ils étaient souvent conceptuellement supérieurs au protocole IP et même plus riches en possibilité et répondaient parfaitement aux besoins de l’informatique centralisée.

Paradoxalement c’est parce qu’il était le plus rustique que le protocole IP s’est montré le plus apte à faire communiquer des systèmes différents et s’est donc imposé. Il répondait en effet aux besoins des utilisateurs du monde de la recherche qui demandaient à pouvoir échanger des informations sans être arrêtés par les distances et les incompatibilités techniques des matériels.

D’autres facteurs ont contribué ensuite au développement de l’Internet et à sa généralisation à d’autres secteurs. Dès l’origine ont été adoptées des règles pragmatiques, notamment en matière de normalisation, qui ont permis de doter l’Internet d’une très grande créativité et facilité d’adaptation.

L’arrivée des micro-ordinateurs a contribué à faire de l’Internet le réseau « à tout faire » que nous connaissons. Sans eux l’Internet se serait probablement développé, mais en se limitant à relier les centres informatiques. La diffusion des micro-ordinateurs a permis aux utilisateurs d’accéder directement à l’Internet. Ils se sont mis à utiliser intensivement les outils personnels de communication. Ainsi tout le monde connaît la messagerie électronique ou le World Wide Web qui ne sont plus à présenter. Ce sont eux actuellement les grands moteurs de la croissance de l’Internet en attendant d’autres applications comme la visioconférence et autres téléservices.

Il est à noter que la diffusion dans le monde universitaire des stations de travail fonctionnant sous Unix a permis de mettre en place les serveurs d’information sur l’Internet. Au début ces serveurs étaient des banques de données scientifiques et techniques, mais les chercheurs ont constaté qu’il était facile de leur adjoindre des outils de recherche et de présentation. C’est ainsi qu’est né le Web au CERN.

Le succès des services sur l’Internet a été tel que l’Internet désigne aujourd’hui non seulement le réseau physique mais aussi les services qui se sont développés simultanément. Le grand public assimile d’ailleurs l’Internet aux informations rendues accessibles par le réseau. L’Internet s’est en effet diffusé en dehors du monde de la recherche, notamment dans les entreprises. Il est aussi devenu accessible au grand public par l’intermédiaire d’accès indirects à travers le réseau téléphonique. Ces accès n’offrent pas les performances d’une connexion directe mais ont donné une nouvelle dimension à l’Internet en engendrant une augmentation massive du nombre d’utilisateurs.

Confronté à ce changement profond, l’Internet garde cependant la mémoire de ses origines et conserve encore un esprit coopératif dans la mise en oeuvre de nombreux services, tout en s’adaptant aux nouveaux enjeux commerciaux et financiers. En particulier une segmentation par activité des acteurs semble voir le jour, les réseaux universitaires comme Renater conservant leur spécificité et leur rôle de pionnier.

Le réseau Renater

En France, l’Internet s’est développé depuis près de dix ans, dans les réseaux internes des grands organismes de recherche, CEA, CNRS, universités, grandes écoles…, et aussi grâce aux efforts du Cnam, qui fut pionnier en la matière, puis de l’Inria qui prit le relais. Le ministère de l’Éducation nationale, de l’Enseignement supérieur et de la Recherche, le CEA, le CNES, le CNRS, la direction des études et recherche d’EDF et l’Inria ont créé le réseau Renater pour interconnecter l’ensemble des établissements d’enseignement supérieur et des centres publics ou privés de recherche. Ils ont également décidé d’unir leurs moyens au sein du GIP (Groupement d’intérêt public) Renater créé en 1993.

Comment fonctionne Renater ?

Renater constitue un bon exemple d’un des grands réseaux constituant l’Internet.

On sait que les informations sont stockées dans les ordinateurs sous forme numérique. Tout type d’information (caractères d’un texte, fichier informatique, image fixe ou animée) peut être numérisé. Les réseaux de télécommunications véhiculent désormais les informations sous forme numérique. En conséquence un réseau de transmission est caractérisé par le débit d’informations élémentaires qu’il peut transmettre exprimé en bits par seconde. La transmission de fichiers de texte ou d’images fixes demande quelques kilobits par seconde à quelques dizaines de kilobits par seconde, la transmission du son demande 8 à 64 kbit/s, la transmission d’image animée demande de quelques dizaines de kilobits par seconde à quelques mégabits par seconde suivant la qualité et la définition de l’image souhaitée.

Tout réseau est constitué de liaisons de transmission et de nœuds de commutation. Les liaisons et les noeuds de commutation doivent être capables de transporter et commuter des débits très supérieurs à ceux indiqués précédemment pour pouvoir supporter simultanément le trafic de nombreux utilisateurs.

Tout réseau est constitué de liaisons de transmission et de nœuds de commutation. Les liaisons et les noeuds de commutation doivent être capables de transporter et commuter des débits très supérieurs à ceux indiqués précédemment pour pouvoir supporter simultanément le trafic de nombreux utilisateurs.

Les liaisons peuvent être réalisées à partir de câbles (simple paire de fil de cuivre du réseau téléphonique, de câbles coaxiaux ou de fibres optiques) ou utiliser la propagation hertzienne (radio, faisceaux hertziens, satellites, liaisons laser). La plupart des supports offrent des débits de quelques dizaines de kilobits par seconde à quelques dizaines de mégabits par seconde. La fibre optique est le support de choix pour réaliser des liaisons car elle permet d’offrir des débits supérieurs au gigabit par seconde sur de grandes distances. Les autres supports continuent cependant à se développer du fait de certains avantages techniques intrinsèques (possibilité de communications avec les mobiles ou de multidiffusion pour la transmission hertzienne) ou pour des raisons économiques car les techniques récentes de compression de données permettent de mieux les utiliser.

Un réseau comme Renater est constitué de réseaux locaux internes aux campus et d’un réseau d’interconnexion entre ces campus.

Les réseaux locaux interconnectent les ordinateurs à l’intérieur des sites, campus universitaires, entreprises, laboratoires, bureaux d’étude, services de gestion ou unités de production. Leur dimension est d’au plus quelques centaines de mètres. Ils sont réalisés principalement à partir de liaisons sur paire de fil de cuivre ou sur fibre optique. Les réseaux locaux de première génération comme Ethernet permettaient un débit maximal d’une dizaine de mégabits par seconde. Ces réseaux se sont très largement diffusés et par conséquence sont devenus très bon marché. Des réseaux locaux plus performants offrent désormais des débits de l’ordre de la centaine de mégabits par seconde, en attendant plus. Ils sont donc à même de transporter au sein d’un campus tous les types de trafic engendrés par les utilisateurs.

Les réseaux d’interconnexion entre les campus mettent en oeuvre des liaisons à longue distance pouvant s’étendre sur plusieurs milliers de kilomètres. Ces liaisons sont fournies par des opérateurs de télécommunications, comme France Télécom dans le cas de Renater. L’infrastructure du réseau d’interconnexion de Renater est constituée de liaisons spécialisées à haut débit, généralement sur fibre optique, et de systèmes assurant la commutation des paquets d’information.

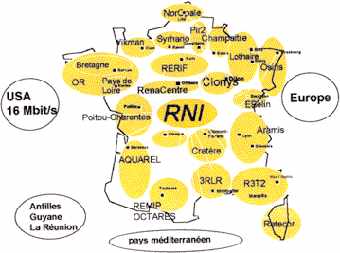

Le réseau Renater a conservé l’approche coopérative de l’Internet. Il fédère plusieurs réseaux, les réseaux de campus ou de site, les réseaux régionaux, et le réseau national d’interconnexion :

- les réseaux de campus sont constitués des réseaux locaux à haut débit qui relient stations de travail et ordinateurs d’un même site ;

– les réseaux régionaux relient les réseaux de campus.Les réseaux régionaux permettent aux campus d’une même région de communiquer entre eux ;

– le réseau national d’interconnexion (RNI) relie les réseaux régionaux. Le réseau national d’interconnexion permet à tous les sites reliés à Renater de communiquer entre eux et d’accéder aux réseaux étrangers à travers une passerelle internationale.

Renater aujourd’hui

Aujourd’hui Renater dispose d’un réseau régional dans chaque région de la métropole et dans tous les départements d’outre-mer. Actuellement 550 grands sites ou campus sont directement raccordés à Renater, à des débits allant de 64 kbit/s à 34 Mbit/s. Ces sites regroupent la quasi-totalité de la recherche publique et de l’enseignement supérieur français, toutes les universités, le CEA, le CNES, le CNRS, la direction des études et recherche d’EDF, l’Inria, l’Onera, l’Inserm, l’Orstom, le Cirad, l’Ifremer, l’Inrets, l’École polytechnique et la majorité des écoles d’ingénieurs et écoles de commerce, les écoles d’architecture, mais aussi des laboratoires privés ou des centres de recherche de l’industrie, des musées ou bibliothèques, les rectorats, certaines administrations ou collectivités locales partenaires de Renater. De nombreuses entités comme les instituts universitaires de technologie ont un accès indirect à Renater par l’intermédiaire de ces sites. Déjà plus de 1 500 lycées et collèges accèdent également au réseau par l’intermédiaire de passerelles disposées au niveau des rectorats. Le ministère de l’Éducation nationale a d’ailleurs décidé d’étendre cet accès à l’ensemble de ces établissements et à une partie des écoles au cours des trois prochaines années.

L’accès au réseau Renater est soumis au respect d’une charte de déontologie interdisant les usages illicites et non professionnels du réseau. Les statistiques de trafic révèlent une croissance exceptionnelle du trafic national mais aussi international. Ce taux de croissance, situé entre 6 et 7 % par mois, en a fait le plus grand réseau français de transmission de données en termes de trafic transporté.

Renater : un des plus grands réseaux de l’Internet mondial

Le réseau français Renater constitue aujourd’hui un des plus importants réseaux de l’Internet mondial ; il est directement relié aux grands réseaux :

- européens via des liaisons sur le réseau Ebone et le réseau européen TEN 34 (Trans European Network à 34 Mbit/s) mis en oeuvre par l’ensemble des réseaux européens pour la recherche,

– et nord-américains, par la première liaison ATM mise en place entre l’Europe et les États-Unis par France Télécom.

Renater est également connecté aux réseaux des opérateurs privés d’Internet par un noeud d’interconnexion mis en place à Paris par le GIP Renater.

Les services disponibles sur Renater

De nombreux services sont disponibles sur Renater. Ce sont la messagerie électronique, le W3, le transfert de fichiers et l’accès aux bases de données multimédia. C’est aussi l’utilisation d’ordinateurs à distance notamment pour la simulation numérique sur les super-calculateurs ou l’exploitation à distance des grands équipements scientifiques. Ces services évoluent rapidement et deviennent de plus en plus faciles à utiliser. Ils traitent l’information sous les formes les plus adaptées à l’homme : son, images fixes, images animées. De nouveaux services apparaissent également sur Renater comme le travail coopératif à distance et la téléconférence.

L’évolution de Renater vers les réseaux à haut débit

Puisque l’information est désormais conservée et transportée sous forme numérique, le son, les documents administratifs (EDI), les documents de la presse et de l’édition, la vidéo (télévision numérique) sont de plus en plus transmis sous forme numérique et relèvent donc des méthodes de traitement de l’informatique. Ils peuvent donc être transportés par l’Internet, sous réserve de disposer de réseaux supports à haut débit.

La numérisation de l’information est étroitement associée à l’évolution actuelle vers une offre d’information de nature multimédia associant et intégrant textes, sons, images, vidéo et faisant appel aux techniques de l’intelligence artificielle.

La généralisation des micro-ordinateurs tant dans le domaine grand public que professionnel joue un rôle fondamental dans cette évolution, comme cela a été le cas lors du démarrage de l’Internet. Ces machines sont parfaitement adaptées au stockage, au traitement et à l’utilisation de l’information multimédia.

Mais contrairement aux premiers réseaux de transmission de données entre ordinateurs ou même au téléphone numérique, le multimédia demande de disposer de réseaux à haut débit. Une image scientifique de haute définition peut exiger 24 millions d’informations élémentaires. Pour transmettre cette image en quelques minutes il faut disposer d’un débit d’au moins quelques centaines de kilobits par seconde, mais si l’on veut consulter de façon quasi instantanée une banque de données contenant de telles images, c’est un débit de plusieurs dizaines de mégabits par seconde qui est nécessaire. Pour transmettre des images animées en haute définition on conçoit qu’il faut disposer de débits encore plus élevés.

La technologie des télécommunications offre désormais cette possibilité soit en utilisant les réseaux en fibre optique, soit en utilisant mieux les réseaux existants avec les technologies récentes de compression de données. Plus généralement les réseaux de transmission de données informatiques deviennent capables de transporter de l’information multimédia, un très bon exemple en est donné par le développement de l’Internet qui a parfaitement su évoluer pour s’adapter à ces nouveaux services.

On a vu plus haut que les réseaux locaux installés au sein des campus deviennent capables de transporter sans difficulté tous les flux d’information créés par les utilisateurs. Les développements actuels portent sur l’interconnexion à haut débit de ces campus dans le cadre du projet Renater 2. Les États-Unis ont récemment lancé une initiative en ce sens connu sous le nom de projet Internet 2.

Les nouveaux services

Compte tenu de la montée en puissance du réseau, de nouveaux services commencent à se développer de façon d’abord expérimentale, puis plus opérationnelle sur Renater. Certains préfigurent les services qui seront offerts à terme au grand public ou aux entreprises.

L’accès à distance aux grandes machines de calcul

L’évolution de l’informatique conduit à l’abandon rapide des grands systèmes informatiques centralisés au profit de micro-ordinateurs de plus en plus puissants complétés par un petit nombre de machines spécialisées pour traiter des problèmes complexes et particuliers comme la simulation numérique appliquée à l’aérodynamique ou à la déformation des structures consécutive à un choc. Les ingénieurs ou les chercheurs disposent désormais de stations individuelles de travail très puissantes et accèdent à partir de ces stations aux grandes machines quant cela est nécessaire. Les résultats des travaux sont souvent uniquement interprétables sous forme d’images fixes ou animées. Bien que par nature limités aux seuls ingénieurs et scientifiques, ces services méritent d’être mentionnés car ils ont représenté la première demande de service nécessitant des hauts débits de transmission.

Les services de visiophonie

Ils couvrent de nombreuses applications, téléconférence depuis son bureau, téléréunion ou bien diffusion de cours ou de séminaires à distance. Suivant les applications envisagées, ils doivent répondre à des critères de qualité très différents et offrir des outils complémentaires adaptés. De nombreux produits sont déjà disponibles sur l’Internet mais il faut reconnaître qu’ils ne sont pas encore pleinement satisfaisants pour l’utilisateur. Ils devraient bénéficier de l’arrivée du haut débit.

Le travail coopératif, l’instrumentation à distance, l’imagerie médicale

La maîtrise d’ouvrage des grands projets techniques internationaux, par exemple l’Airbus européen, a conduit à mettre en place des systèmes d’aide au travail coopératif. Ils intègrent des outils décrits précédemment, téléconférence, banque d’information multimédia contenant les documents de travail, les plans et toutes les informations techniques nécessaires à l’étude puis à la réalisation du projet. Ces techniques peuvent également être étendues à la mise en oeuvre d’appareils à distance (télescopes situés en Amérique du Sud, accélérateurs de particules), à la surveillance d’installations industrielles complexes ou au diagnostic médical à distance. La numérisation des images à la source dans les imageurs médicaux modernes offre en effet de nouvelles possibilités aux chercheurs

Le télé-enseignement

Le contexte de l’enseignement universitaire ou des études doctorales se prête bien au développement du télé-enseignement. De nombreuses universités ou grandes écoles ont déjà mis en place des cours diffusés à distance. Le télé-enseignement reste encore un outil difficile à maîtriser et ne fera probablement pas l’objet d’une généralisation rapide.