Climat : pourquoi les modèles n’ont pas tort.

Autour de la Terre, les mailles du filet numérique se resserrent.

Autour de la Terre, les mailles du filet numérique se resserrent.

L’augmentation anthropique de gaz à effet de serre dans l’atmosphère, susceptible de créer un réchauffement de la planète de plusieurs degrés au siècle prochain, constitue désormais un risque que plus personne n’ignore. Pourtant, la complexité du problème scientifique posé, conjuguée sans doute à l’importance des mesures économiques ou politiques qu’il serait ou sera nécessaire de prendre pour stabiliser la composition chimique de notre atmosphère, conduisent périodiquement à remettre en question la réalité de ce problème.

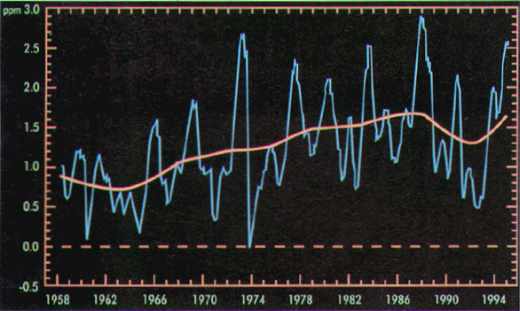

Si l’augmentation atmosphérique des gaz à effet de serre est un fait avéré, indéniable (figure 1), dont tout donne à penser qu’il va se poursuivre, c’est sur l’impact réel de cette augmentation que se focalisent certains doutes.

En effet, malgré le consensus très large au sein de la communauté scientifique et malgré l’action qui commence à être engagée au niveau politique, des voix discordantes se font entendre de manière récurrente, allant de certains scientifiques à des militants écologistes sans doute plus sensibles aux dangers de l’énergie nucléaire qu’à ceux du changement climatique, en passant par des industriels qui se sentent menacés, tels ceux des mines ou du pétrole aux Etats-Unis.

Figure 1. L’augmentation atmosphérique de C02 est indéniable, comme le montre son évolution observée à Mauna Loa, à Hawaï (lieu volontairement éloigné des principales sources d’émission), en données brutes. La courbe orange représente l’évolution désaisonnalisée de ces données

Les modèles numériques, qui constituent les outils principaux sur lesquels s’appuient les scientifiques dans l’évaluation de ces effets, sont alors la cible de critiques visant à montrer que leurs résultats sont incertains, et doivent être considérés avec circonspection, sinon purement ignorés.

La réponse des scientifiques à ces attaques – qui posent des questions on ne peut plus légitimes – apparaît parfois maladroite ou malaisée. De fait, il serait vain de nier qu’il entre dans la réponse des modèles numériques une part d’incertitude qui interdit par exemple jusqu’à présent de préciser l’ampleur ou la localisation des risques à venir.

En dépit de cette incertitude, parfaitement admise, les scientifiques ont pourtant manifesté de manière presque unanime que le problème de l’effet de serre est réel et qu’il requiert l’attention de tous. Pour expliquer cette apparente contradiction, il est d’abord important de rappeler ce que sont ces modèles climatiques, qui conjuguent une grande sophistication et des faiblesses persistantes.

La mise au point des modèles constitue en fait une tentative de créer une petite planète numérique, aussi proche que possible de notre « vraie » planète, mais sur laquelle il est plus facile ou plus rapide de conduire des expérimentations variées.

La composante atmosphérique de ces modèles, par exemple, calcule aux nuds d’un maillage encore lâche (quelques centaines de kilomètres) l’évolution de paramètres tels que le vent, la température, l’humidité, les nuages, les précipitations, l’eau du sol – pour ne citer que les variables principales. La composante océanique opère des calculs semblables sur une grille souvent plus fine. La physique sur laquelle s’appuie ces calculs est une physique classique et éprouvée.

Elle permet de décrire deux grandes catégories de processus : les échanges d’énergie, en particulier sous forme de rayonnement électromagnétique, entre la Terre, l’océan, l’atmosphère et l’espace ; et la dynamique des écoulements atmosphérique et océanique. Dans le premier cas, il s’agit d’abord de décrire comment l’énergie reçue du Soleil est compensée par une énergie émise par le système Terre/océan/atmosphère.

La température de surface du Soleil est de 6.000 °C environ et la longueur d’onde du rayonnement solaire s’étend de l’ultraviolet à l’infrarouge proche, c’est à dire d’environ 0,3 à 5 micromètres. La valeur de l’insolation au sommet de l’atmosphère (aux alentours de 1.310 W/m2) a été estimée dès le siècle dernier à partir des observatoires en altitude ; elle est désormais mesurée par satellite.

Cette énergie solaire n’est pas absorbée dans sa totalité par la Terre :

- 30% environ sont réfléchis vers l’espace,

- 50% traversent l’atmosphère et chauffent le sol ou les océans,

- 20% chauffent directement l’atmosphère.

Pour rendre à l’espace l’énergie qu’elle reçoit du Soleil, la Terre émet elle aussi un rayonnement électromagnétique, dans le domaine infrarouge, c’est-à-dire dans une gamme spectrale allant de 5 à 100 micromètres.

L’émission provient de la surface de la planète, mais aussi de certain gaz minoritaires de l’atmosphère – dits gaz » à effet de serre » – et des nuages.

L’étude du transfert radiatif dans l’atmosphère constitue un problème physique assez bien compris, même s’il subsiste des incertitudes – par exemple en présence de nuages aux géométries complexes. Le calcul des équations de transfert radiatif se fait dans les modèles au moyen de systèmes d’équations simplifiés, qui s’appuient eux-mêmes sur des calculs détaillés prenant en compte toutes les raies spectrales des différents composants de l’atmosphère. Ces équations jouent aussi un rôle central dans l’observation satellitaire de la planète, et sont donc également vérifiées dans ce cadre.

La deuxième classe de processus décrite explicitement par les modèles concerne la circulation à grande échelle de l’atmosphère et de l’océan, qui découle notamment de la rotation de la planète.

Elle s’appuie sur les équations de la dynamique des fluides, et en particulier les équations de Navier-Stokes, qui décrivent l’accélération d’un élément de fluide soumis à des contraintes diverses, internes ou externes. Ces équations sont discrétisées sur les nœuds du maillage qui couvre l’ensemble du Globe, c’est-à-dire qu’elles sont résolues sur chacun des milliers de points du maillage.

Le fait qu’en une décennie les prédictions météorologiques, qui s’appuient sur des modèles très semblables, aient pu doubler la durée des prévisions utiles, passant de deux à quatre jours environ, constitue la meilleure preuve de la pertinence de ces équations pour décrire l’écoulement atmosphérique ou océanique de grande échelle.

La modélisation a plus progressé du fait de l’augmentation de la puissance informatique que de nouvelles connaissances physiques

Ces équations sont connues depuis longtemps mais, comme elles ne sont pas linéaires, elles mélangent les échelles de temps et d’espace et ne peuvent se résoudre de manière analytique. Le recours à l’ordinateur est donc indispensable, et n’a pu être envisagé qu’assez récemment. A cet égard, les progrès considérables de la modélisation du climat au cours des deux dernières décennies sont moins le reflet de connaissances physiques nouvelles que d’une augmentation extraordinaire de la puissance de calcul.

Petite histoire de la modélisation du climat

L’idée d’utiliser les équations de la mécanique des fluides pour prédire l’évolution de l’atmosphère est vieille de plusieurs décennies : en 1920–1922 un chercheur anglais, L. F. Richardson, s’y essayait en vain, et tirait de ses échecs la leçon qu’un tel exercice ne pouvait être réalisé que par des milliers de calculateurs (humains) travaillant en parallèle sous la conduite d’un chef d’orchestre !

Et, de fait, dès qu’apparut l’un des premiers ordinateurs, l’EN IAC, mis au point par le Massachusetts Institute ofTechnology en 1946, des météorologues, Julius Chamey et ses collègues, en furent en 1948 parmi les premiers utilisateurs.

Durant les années 1960, deux équipes commencèrent à aborder réellement l’étude de l’écoulement atmosphérique dans sa dimension climatique : celle de Joseph Smagorinski et Syukuro Manabe au GFDL (Geophysical Fluid Dynamics Laboratory) sur la côte est des États-Unis, et celle de Yale Mintz et Akio Arakawa à UCLA (University of Califomia at Los Angeles).

Mais ce n’est qu’au cours de la dernière décennie que la puissance des ordinateurs a permis de réaliser plus couramment des simu lations de plusieurs décennies – limitées à l’écoulement atmosphérique d’abord, puis associant atmosphère et océan.

Ainsi, notre laboratoire utilisait encore en 1982 une machine CDC (Control Data) du Centre national d’études spatiales avec laquelle une simulation d’un mois d’évolution de la circulation atmosphérique réclamait plus de trente heures de calculs. A résolution égale, la même simulation réclame aujourd’hui environ quinze minutes de temps de calcul sur un Cray 90.

Au bout du compte, nous disposons de modèles qui ont une base physique forte.

Ces modèles concentrent une expertise considérable, qu’il faut cependant savoir utiliser et interpréter, en gardant à l’esprit les limitations et incertitudes que nous allons maintenant détailler. On peut distinguer trois familles de problèmes.

La première est intrinsèque au système climatique lui-même : il n’est tout simplement pas un système entièrement prévisible. Ceci est vrai de la composante atmosphérique elle-même : à échéance de dix jours environ, l’évolution météorologique ne peut plus être prédite, parce que le caractère instable de l’écoulement a répercuté à l’ensemble du Globe une toute petite erreur initiale.

C’est l’effet bien connu, découvert par Edward Lorenz en 1963, popularisé sous le nom d” »effet des ailes de papillon » : il exprime que toute perturbation, aussi minime soit, elle, modifie irréversiblement l’histoire de l’atmosphère. Mais cela ne signifie pas qu’aucune information ne puisse être obtenue sur l’évolution du climat.

Plusieurs processus guident ainsi les mouvements de l’atmosphère, et organisent son comportement. Le plus connu est le rythme des saisons. Mais il en existe d’autres. L’océan, en effet, organise l’évolution lente du climat car son inertie est plus grande que celle de l’atmosphère, et son comportement reste prévisible sur des durées plus longues.

Malgré les incertitudes propres au système climatique, la capacité d’expertise de ce système a considérablement augmenté

L’augmentation des gaz à effet de serre pourrait également constituer un exemple de processus guidant et modifiant les fluctuations de notre environnement.

Cette variabilité intrinsèque du comportement de l’atmosphère affecte la manière dont sont conduites les expérimentations numériques : moins qu’une tentative de prédiction, il s’agit de faire subir à notre petite planète numérique la même augmentation de gaz à effet de serre que commence à subir la planète réelle, et poursuivant ou en répétant l’expérience suffisamment longtemps, de parvenir à établir une statistique des effets induits.

Cette même variabilité doit aussi rendre prudent dans l’interprétation des changements climatiques récents, que l’on cherche à utiliser comme un support au contraire comme un désaveu du rôle des gaz à effet de serre. Il reste ainsi difficile de prouver que ceux-ci ont entraîné le réchauffement d’une fraction de degré observé au cours des dernières décennies.

La possibilité que ce réchauffement observé soit le résultat d’une fluctuation naturelle plutôt que d’une action humaine ne peut statistiquement pas être écartée, tant nous connaissons mal les fluctuations naturelles à l’échelle de quelques décennies. Mais réciproquement il pourrait se révéler désastreux de traduire cette incapacité à prouver les choses par l’affirmation qu” » il ne se passe rien « .

La variabilité interne de notre système climatique a une amplitude telle que le jour où nous serons en mesure de donner une preuve statistique de la réalité du changement climatique, l’ampleur de celui-ci sera déjà considérable.

Une deuxième source d’incertitudes correspond aux simplifications inévitables apportées dans la construction des modèles. La difficulté de la représentation des nuages en est un exemple :

- les nuages sont générés par des mouvements de l’air de petite échelle, allant de quelques centaines de mètres à quelques kilomètres, mouvements qu’il est hors de question de représenter de manière explicite dans les modèles ;

- ils sont le lieu d’un dégagement de chaleur latente intense, qui résulte de la condensation de l’eau,

- et ils perturbent le rayonnement solaire et le rayonnement infrarouge d’une manière qui dépend fortement de la taille des gouttes d’eau ou des cristaux de glace.

Devant tant de complexité – et l’on pourrait donner d’autres exemples, relatifs aux glaces de mer, à la végétation ou à l’hydrologie continentale – la modélisation est nécessairement simplificatrice.

Les concepteurs de modèles assument cette simplification, mais il en résulte une incertitude dont on peut estimer l’importance en comparant la performance de ; modèles qui ont été mis au point de manière indépendante dans différents instituts du monde entier. Les résultats de ces modèles en réponse à un doublement du CO2 atmosphérique, par exemple, se situent dans une fourchette allant de 1,5 à 5 °C de réchauffement global, pour des raisons qui tiennent exclusivement à la construction des modèles.

De même, en dépit de grandes tendances bien établies, tel le fait que le réchauffement de surface soit plus intense aux hautes latitudes et en hiver, ou que les variations du cycle hydrologique sont plus intenses dans les régions tropicales, les modèles ne parviennent pas à fournir une information locale cohérente.

Les difficultés rencontrées dans les modèles traduisent seulement l’incroyable complexité du milieu naturel

Un troisième facteur vient limiter la portée pratique des modèles : en dépit des progrès affichés dans ce domaine, ils ne représentent toujours qu’une partie du système climatique complet. Les fluctuations possibles de la circulation océanique profonde, par exemple, commencent seulement à être étudiées et leur étude est aussi rendue très difficile par le petit nombre de données observées à ces profondeurs.

Par ailleurs les modèles sont encore le plus souvent des modèles physiques, qui négligent les composantes biologiques ou chimiques du système, dont le rôle essentiel apparaît pourtant de plus en plus clairement. Au cours des dernières années, par exemple, les aérosols soufrés ont été reconnus comme l’un des facteurs importants susceptibles de masquer, dans l’hémisphère nord tout au moins, les manifestations initiales de l’effet de serre.

Cette découverte a permis de proposer une explication à la dissymétrie de l’évolution climatique dans les deux hémisphères au cours des dernières décennies. L’hémisphère sud s’est réchauffé de manière plus continue, alors que l’hémisphère nord a d’abord subi un épisode de refroidissement. De fait, si l’on combine l’augmentation des gaz à effet de serre, la diminution de l’ozone stratosphérique et l’effet des aérosols soufrés, on peut reproduire de manière assez plausible l’évolution en cours des températures aux différents niveaux de l’atmosphère.

Mais de nombreux autres processus sont encore nécessaires à une bonne compréhension de l’environnement global : puits et sources du carbone océanique et continental, cycle du méthane, augmentation de l’ozone troposphérique, rôle des aérosols organiques ou minéraux, etc.

L’accumulation de ces facteurs d’incertitude rend sans doute illusoire, pour le moment, la prédiction détaillée d’une évolution du climat futur. On pourrait même dire, en forçant le trait, que plus la recherche progresse, plus se révèle l’énorme complexité des processus qui participent à l’évolution de notre environnement, et plus s’éloigne la possibilité de prévoir en détail l’évolution future du climat.

Mais il ne faudrait pas s’arrêter à cette conclusion négative, et en déduire que les modèles sont inutiles. Car en même temps, et de manière apparemment contradictoire, la capacité d’expertise face à ce système a considérablement augmenté, et le niveau de certitude quant à la réalité du réchauffement futur est certainement devenu plus grand.

Ceci tient d’abord à ce que la variété des processus dont le rôle a été étudié qualitativement est désormais beaucoup plus grande. Mais aussi au fait que des modèles toujours plus nombreux et sophistiqués indiquent sans exception un accroissement de température non négligeable dans le futur.

En effet, en dépit de la complexité du système étudié, de la diversité des pays et instituts engagés dans la recherche sur le climat, de la diversité des modèles, de l’effet de publicité énorme qui serait attaché à un tel travail, personne n’est parvenu à mettre au point une expérience numérique crédible conduisant le système climatique à ne pas se réchauffer en réponse à l’augmentation des gaz à effet de serre.

Ceci n’a pas valeur de preuve, mais constitue malgré tout une indication extrêmement forte qui ne peut être ignorée. Et, dans l’état actuel de nos connaissances, c’est désormais à ceux qui prétendraient que les modifications de la composition chimique de la planète seront sans effet d’en apporter la preuve.

Dans le futur, la modélisation du système climatique devrait voir évoluer son rôle. D’abord, dans l’éventualité où le climat commencerait à changer de manière significative, il deviendrait possible d’utiliser ce début de modification pour augmenter la capacité des modèles à prédire les évolutions postérieures.

Dans ces circonstances aussi, les questions qui seront posées – et qui commencent à l’être – prendront une nature différente : quels sont les » coupables » ? Comment peut-on peser, par exemple, le rôle des émissions d’oxydes nitreux par les avions ou par les voitures ? L’impact climatique est-il le même lorsque les gaz polluants sont déposés dans des centres urbains, ou dans la stratosphère ? Ces problèmes sont et seront posés en dépit des incertitudes qui affectent encore, indéniablement, la modélisation de notre environnement global, et qui subsisteront encore longtemps, voire indéfiniment.

Il sera très important dans ce contexte de préserver une diversité suffisante de modèles construits et gérés de manière indépendante, car la dispersion des résultats obtenus constituera l’une des seules mesures de l’incertitude des résultats.

En conclusion, l’unanimité des résultats obtenus par les modèles relativement au réchauffement futur s’accompagne de difficultés à dresser un tableau précis des changements à venir. Mais ces difficultés ne doivent pas conduire à en écarter les résultats de manière trop rapide.

Les modèles numériques constituent l’un des seuls outils de réflexion sur le futur qui soit disponible. Les difficultés rencontrées traduisent seulement l’incroyable complexité du milieu naturel.

Et on peut en retirer une certitude forte : laisser se modifier librement la composition chimique de la planète, avec l’idée que l’on pourrait s’adapter ensuite aux changements à venir, constitue un scénario incontrôlable.