Doit-on modéliser les effets toxiques des substances chimiques dans l’environnement avec des outils mathématiques ?

Il paraît assez évident au commun des mortels, et l’actualité le rappelle régulièrement aux étourdis, que toute action dangereuse doit s’accompagner d’une évaluation des risques qui lui sont associés.

Par exemple, avant d’introduire un composé chimique toxique dans l’environnement, il convient d’inférer sur son comportement, de s’inquiéter de sa persistance, de deviner où il va aller se nicher et surtout de savoir quel effet il va produire sur les humains et les espèces sauvages qui seront exposés.

Tous ceux, que j’espère nombreux, qui acceptent cette évidence comme telle seront probablement surpris, et peut-être attristés, d’apprendre qu’une étude de l’Agence de protection de l’environnement des États-Unis identifie parmi les 3 000 composés les plus répandus aux USA seulement 7 % d’entre eux dont le dossier toxicologique est suffisamment renseigné pour procéder à cette évaluation des risques1. La simple application du principe de précaution réduirait drastiquement le nombre de molécules en circulation et aurait des conséquences économiques considérables.

La notion même d’évaluation des risques apparaît pour le grand public comme peu explicite. Il est certes difficile de communiquer sur les probabilités. Dites à l’homme de la rue que le risque de cancer jugé acceptable est de 10-6 (prononcez dix moins six) et vous passez pour un technocrate froid et obscur. Rappelez-lui qu’il a une chance sur un million de gagner à une tombola il se précipitera sur un billet si le gain espéré lui paraît proportionné à l’enjeu. Ceux-là mêmes qui refusent de comprendre les mots » danger » et » risque » dès qu’il s’agit de la santé environnementale semblent suivre sans difficulté notable les reportages sportifs télévisés où des activités dangereuses, mais de sportifs qui calculent les risques, leur sont présentées.

Au sein du monde scientifique lui-même, le résultat d’une modélisation est pris comme une indication, un pis- aller, tandis qu’un résultat de mesure, même sans son incertitude et sans garantie sur la qualité et la pertinence du prélèvement, est considéré comme un élément beaucoup plus sûr.

Les raisons de ces contradictions sont multiples et nous ne nous y attacherons pas. Il est cependant facile de deviner que pour la première des raisons économiques s’opposent au travail considérable qui devrait être fait pour mieux appréhender les risques toxiques environnementaux et pour la deuxième la culture mathématique et probabiliste reste une grande lacune y compris chez les scientifiques.

Cependant, ce problème, en apparence banal, de rapport de forces entre la puissance économique et la protection de l’environnement et aussi de culture mathématique cache un redoutable problème en termes d’expertise scientifique. Problème dont je proposerai deux formulations au choix :

1. Les outils de modélisation utilisables en toxicologie de l’environnement sont-ils trop complexes pour les biologistes et les décideurs ?

2. Peut-on se contenter d’une approche de précaution afin d’économiser les coûts expérimentaux et de se passer de la modélisation ?

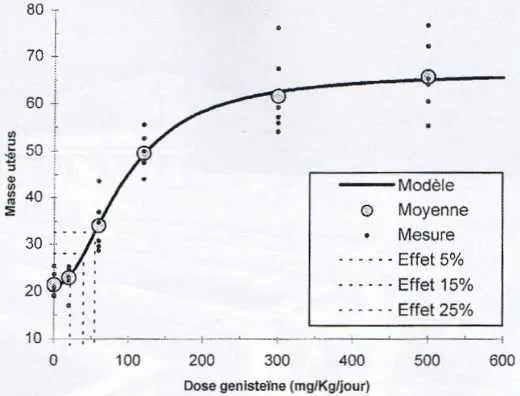

Exemple d’une relation dose-réponse, ici l’effet d’une substance hormonomimétique sur la masse de l’utérus d’une rate.

Modéliser la relation dose-réponse

Commençons par examiner une des étapes clés de l’évaluation des risques toxicologiques qui est l’établissement d’une relation dose-réponse. Dans un premier temps, l’expérimentateur va regrouper un certain nombre d’individus d’une espèce de laboratoire que nous appellerons rat dans quelques groupes d’effectif identique, disons six groupes de six rats. Un des groupes aura le privilège de faire semblant d’être exposé au toxique : le groupe témoin. Les autres groupes seront exposés à des doses de la substance en progression géométrique.

À la fin de l’essai, des paramètres biologiques sont enregistrés sur chaque animal. L’interprétation des données se fait en comparant les groupes exposés avec le témoin au moyen d’un test d’hypothèses afin de déterminer qu’elle est la dose la plus faible à partir de laquelle un des paramètres biologiques est significativement différent du témoin. La dose d’essai immédiatement inférieure est considérée comme sans effet et devient un seuil de toxicité.

Il n’échappera pas à l’œil critique du lecteur de cette revue bicolore que ce seuil dépend de la gamme de concentrations choisie par l’expérimentateur, que la dispersion au sein de chaque groupe a un impact fort sur la capacité du test statistique à détecter l’effet significatif et qu’à la limite le laboratoire un peu souillon qui se caractérise par une forte variabilité trouvera des seuils plus élevés et donc aura plus de contrats.

Par ailleurs, valider l’idée de seuil de la sorte conduit tout droit à imaginer des doses sans risque, idée bien entendu fausse mais répandue. Le seuil biologique, s’il existe, est forcément distribué dans la population et c’est la probabilité d’effet dans la population qui seule permet une évaluation sérieuse du risque.

Néanmoins, malgré de nombreuses attaques de scientifiques et les recommandations d’un groupe de travail de l’OCDE2, la perspective de modifier cette approche au profit d’une modélisation de la courbe dose-réponse ouvrant la voie au calcul de la probabilité d’effet en fonction de la dose et à l’estimation des incertitudes sur les valeurs seuil n’est toujours pas d’actualité.

Modéliser les effets toxiques sur les écosystèmes

Lorsque l’on cherche à protéger les écosystèmes des effets délétères des substances chimiques toxiques, il est couramment procédé à des essais de toxicité sur quelques espèces vivantes que l’on voudrait bien considérer comme représentatives du milieu. En réalité, les espèces utilisées sont surtout choisies du fait de leur facilité de manipulation au laboratoire et leur universalité d’utilisation dans le monde.

On peut comprendre que, face aux coûts engendrés par de tels essais, l’accent ait été mis sur la standardisation. Cependant cette convergence vers un petit nombre d’espèces conduit à appauvrir l’information sur les réels dangers des toxiques dans l’environnement.

Afin de pallier cette faiblesse de l’information, les gestionnaires des risques ont imaginé des facteurs de sécurité, parfois appelés facteurs d’incertitude car ils sont censés majorer l’incertitude sur le danger3. Ainsi, en fonction du nombre et du type des essais réalisés, on utilise des facteurs de 10, 100 ou 1 000, par lesquels on divise les concentrations seuil d’effet. On reconnaîtra ici une approche typique de type précaution. Bien entendu un effet vertueux est recherché et ces facteurs sont d’autant plus faibles que des essais sophistiqués ont été mis en œuvre. Il reste que cela ne règle pas le problème des substances existantes dont la toxicologie n’est pas renseignée.

Tout cela prêterait à sourire s’il ne s’agissait pas de protéger une nature déjà fortement soumise à la pression humaine, dont les substances toxiques ne sont qu’un des aspects. De fait, face à la pauvreté générale des données, une telle politique de gestion précautionneuse est raisonnable : elle permet de prendre en compte des résultats rares et encourage à la production de données.

Mésocosmes à l’Ineris. © INERIS

Cependant on ne saurait s’en contenter ; les éléments les plus récents de la politique de protection de l’environnement dans le domaine des produits chimiques vont vers un renforcement de la connaissance du danger4. Dans ce contexte il faut se poser le problème d’un accroissement de la précision des outils d’aide à la gestion des substances chimiques et du remplacement des facteurs de sécurité par des modèles d’extrapolation plus sophistiqués.

Avant de modéliser, posons le problème de la connaissance du phénomène que l’on souhaite résoudre. Les écosystèmes sont des assemblages complexes d’espèces interagissant entre elles et avec leur milieu, appelé biotope. Toute modification du biotope, et l’intrusion d’un toxique en est une, peut produire une perturbation de ces communautés vivantes. Il s’agira pour le modélisateur de trouver les lois qui gouvernent (ou plus simplement de décrire) la relation entre la concentration d’un toxique dans le biotope et la structure de la communauté.

Un premier pas peut être franchi en tentant une modélisation de la distribution de sensibilité des espèces composant la communauté en présence d’un toxique. Nous serons cependant loin de l’explication de l’évolution d’une communauté sous stress toxique. En effet celle-ci ne dépendra pas seulement de la disparition de certaines espèces sensibles mais également de l’évolution du réseau de relations trophiques5 entre les espèces résistantes, voire de l’effet de remplacement d’espèces disparues par d’autres espèces plus tolérantes. Cependant, en faisant appel, une fois de plus au principe de précaution, il suffira de limiter la présence du toxique à une teneur telle que toutes les espèces résistent pour protéger en principe l’écosystème étudié.

Les outils actuels de modélisation des distributions de sensibilité reposent sur le fait que la probabilité de survie des espèces en fonction du logarithme de la concentration du toxique suit en première approximation une loi normale. Ce modèle simple est utilisé actuellement pour définir la concentration protégeant 95 % des espèces, seuil que les gestionnaires de risque environnemental ont jugé acceptable.

Au-delà de cette distribution empirique, qui nécessite un nombre important de résultats de laboratoire, il serait intéressant de prédire par la modélisation la toxicité de substances chimiques sur diverses espèces à partir d’un nombre limité de données de toxicité. La modélisation viendrait ainsi au secours du manque de données habituellement constaté. Lacune dont on peut douter qu’elle soit palliée, les acteurs économiques et les défenseurs des droits des animaux convergeant pour demander une limitation des expérimentations animales avec des substances toxiques6. C’est le sens de travaux de thèse que l’Ineris et la Société de Calcul Mathématique ont initié en collaboration. Il s’agit de trouver une description des relations entre la sensibilité d’un ensemble d’espèces vivantes et différents toxiques à partir des données disponibles sur ces espèces et ces toxiques. Les premiers résultats ont montré que cette modélisation passait par une expression homogène de la notion de toxicité pour les différentes espèces en la débarrassant de l’influence de la variable temps.

Une autre piste pour cette modélisation passe par la modélisation des relations trophiques entre les espèces. Le groupe de Michel Loreau à l’École normale supérieure7 a publié récemment une approche intéressante appliquée à l’impact de nutriments sur les phénomènes d’eutrophisation8. Leur modèle est basé sur la prise en compte de la diversité fonctionnelle de chaque niveau trophique. Des groupes fonctionnels sont ainsi définis, comportant les espèces partageant les mêmes proies et prédateurs. La modélisation de l’ensemble des relations trophiques entre ces groupes permet de décrire le comportement de la communauté lorsqu’une contrainte modifie certaines de ses composantes. Ces modèles sont validés par des expérimentations en mésocosmes9.

Une telle approche, si elle était appliquée aux impacts toxiques, constituerait une voie de recherche prometteuse dans le domaine de l’écotoxicologie. Elle s’inscrit en complément des études sur la répartition de la sensibilité des espèces. Il devrait en résulter une meilleure prédiction des effets des substances chimiques sur les communautés vivantes et à terme une amélioration de l’établissement des chaînes causales au sein des études de surveillance des écosystèmes et de l’environnement, études qui se développent actuellement sous l’influence notamment de la nouvelle directive cadre de l’Union européenne sur l’eau.

Modéliser l’impact sur la santé humaine

Le domaine des effets sanitaires des substances toxiques dans l’environnement est également un champ de développement de la modélisation. L’évaluation des risques liés au rejet éventuel de substances toxiques procède d’un schéma proche de celui utilisé pour les risques sur les écosystèmes. Ce schéma est identique en ce qui concerne le devenir des substances dans l’environnement, même s’il s’y ajoute un volet » exposition humaine » qui permet de transformer les concentrations prédites dans l’environnement en doses reçues par l’homme.

Les dangers liés aux substances chimiques sont le plus souvent évalués à partir d’expérimentations animales, qui fournissent des valeurs seuil de toxicité auxquelles sont appliqués des facteurs de sécurité. Pour quelques substances seulement, on possède des données d’effet sur l’homme lié à des expositions passées ou des intoxications documentées. La rareté des données est également la règle, l’obligation de fournir des informations minimales sérieuses sur les effets toxiques des produits chimiques n’a été rendue obligatoire que depuis une vingtaine d’années pour les substances nouvellement mises sur le marché. La pression des associations contre l’expérimentation animale et le coût des essais de toxicologie sont également au centre de cet enjeu.

Le problème de l’évaluation de l’impact sur un ensemble d’espèces, qui nous défiait pour l’étude des dangers pour les écosystèmes, est ici remplacé par celui de la transposition animal-homme. Il s’y ajoute la connaissance de l’effet à long terme des faibles doses que l’on cherche à extrapoler à partir de résultats expérimentaux obtenus à court ou moyen terme avec des doses plus élevées. En effet le niveau d’acceptation sociale des risques pour la santé humaine est incomparable avec celui des risques pour les écosystèmes. Il s’agit ici de protéger non seulement la population mais également chaque individu.

Le déclenchement d’un effet retardé, comme un cancer, après une période d’exposition comparable à la durée de la vie doit être pris en compte dans les études de risque. D’autre part, des effets sur la reproduction, pouvant être de nature complexe, doivent être pris en compte. C’est ainsi, par exemple, que l’on cherche à prévoir l’impact sur le développement génital de l’enfant après une exposition de la mère au toxique pendant la grossesse.

Un grand nombre des réponses à un défi de cette envergure se situent dans l’étude fine des mécanismes d’intoxication au niveau moléculaire, cellulaire et physiologique, sujet qui déborde le cadre de cet article.

Les modèles toxico-cinétiques physiologiques sont en développement rapide dans le but de fournir certaines réponses aux questions posées par la complexité des phénomènes de transposition animal-homme. Leur principe est simple et repose sur des modèles compartimentaux. Un animal peut être considéré comme une série de compartiments mis en relations entre eux via la circulation sanguine.

Certains organes importants comme le foie sont considérés en eux-mêmes comme un compartiment unique, d’autres se regroupent en compartiments fortement perfusés et faiblement perfusés. Les tissus adipeux sont également considérés, car ils peuvent constituer un réservoir pour des substances peu solubles dans l’eau. Par ailleurs, les voies d’entrée par ingestion, inhalation, transfert cutané, etc., sont également prises en considération ainsi que le rejet du toxique en dehors du corps. Une fois ce schéma déterminé, une fois les équations de transfert entre compartiments écrites, le métabolisme de la substance peut également être intégré, par exemple lorsque l’on sait qu’elle est biotransformée dans le foie.

Le résultat de la modélisation toxico-cinétique est de fournir, en fonction des données physiologiques de l’animal, la dose toxique au sein de l’organe cible. Le calage peut se faire sur des résultats expérimentaux chez l’animal ; des données physiologiques obtenues in vitro (sur cellules, organes isolés, etc.) peuvent également être intégrées aux modèles en fonction du niveau de complexité souhaité ou possible.

L’intérêt est ensuite de transposer à l’homme le résultat en intégrant dans un modèle équivalent les paramètres physiologiques propres à cette espèce qui nous est chère. Il est ainsi possible de déterminer une dose externe toxique chez l’homme à partir de son équivalent chez l’animal de laboratoire. Il est également possible de déterminer des propriétés toxicologiques d’une substance, via une voie particulière d’exposition, en utilisant des résultats expérimentaux obtenus avec une autre voie d’intoxication.

La durée d’exposition peut être prise en compte du fait même de la nature cinétique de la modélisation, cela avec d’autant plus de précision que les expérimentations ont intégré une dimension temporelle dans les protocoles de mesure. Enfin grâce à de nouvelles approches statistiques bayésiennes il est possible de déterminer des paramètres toxicologiques au niveau de la population10.

Les recherches actuelles sur ces outils sont multiples. La détermination des incertitudes fait l’objet d’un travail intensif des statisticiens. Des modèles sophistiqués sont développés qui intègrent le fœtus dans un compartiment qui lui est propre, séparé de sa mère par la barrière placentaire.

On pourra ainsi à l’avenir mieux comprendre les phénomènes complexes d’anomalies du développement liés à l’intoxication parentale. Ces problèmes font l’objet d’inquiétudes grandissantes de la communauté scientifique, qui doit pour l’instant se contenter d’un certain nombre d’alertes concernant le développement des anomalies de la reproduction dans la population des pays industrialisés, et parallèlement de la mise en évidence d’effets perturbateurs du système hormonal par certaines substances chimiques.

Enfin ces modèles peuvent être utilisés pour déterminer, par exemple, la concentration urinaire de métabolites de substances toxiques et ainsi autoriser la surveillance de l’exposition humaine par les biais de biomarqueurs, véritables signatures toxicologiques de l’exposition aux polluants toxiques dans l’environnement dont ce type de modélisation permet de » remonter » à la dose d’exposition.

La modélisation doit s’intégrer à l’expertise

À travers ces quelques exemples j’ai souhaité éclairer l’importance de la modélisation dans l’évaluation environnementale des risques. Il ne s’agit que d’un éclairage très partiel. Il aurait fallu y ajouter des modèles de relations entre la structure des molécules et leur toxicité, de transfert des contaminants dans l’environnement, de dispersion et de chimie atmosphérique. La modélisation de la pollution transfrontière, l’analyse du cycle de vie des produits, la modélisation économique des coûts de la pollution ou bien des régulations fiscales des émissions de polluants ou de la consommation d’énergie mériteraient également notre attention.

Face à la complexité des phénomènes mis en jeu, il n’est plus possible de se contenter de facteurs de sécurité arbitraires et de dire d’expert. Le cloisonnement des disciplines engendre une tendance au repli sur des méthodes traditionnelles et les résultats qualitatifs pour les uns, tandis que d’autres sont tentés d’élaborer des théories comprises seulement par leur propre communauté.

L’évaluation des risques environnementaux est un métier d’ingénieur ; cela lui donne peu de poids académique propre, mais ouvre un champ extrêmement vaste d’assemblages de diverses disciplines à l’aide d’outils mathématiques. Pour que cette activité progresse, il me semble qu’un minimum de langage commun doit se développer, que les frontières entre les sciences exactes et expérimentales doivent continuer de s’effacer.

Il est bon de savoir que, n’étant pas une spécialité académique, cette » activité scientifique » d’aide à la décision n’est pas un domaine réservé et qu’elle fait son lit d’équipes pluridisciplinaires où matheux, chimistes, biologistes, médecins et pharmaciens contribuent ensemble à fournir une expertise de qualité à condition de partager une » monnaie commune « .

___________________________________________________________

1. EPA Office of Pollution Prevention and Toxics (April 1998)CHEMICAL HAZARD DATA AVAILABILITY STUDY : What Do We Really Know About the Safety of High Production Volume Chemicals ?

2. OECD 1996. Report of the OECD workshop on statistical analysis of aquatic toxicity data. Braunschweig, Germany, 15–17 october 1996. Organization for Economic Cooperation and Development, Paris, France.

3. L’Union européenne a proposé récemment le terme de facteurs d’évaluation afin de réconcilier les défenseurs de la sécurité et les promoteurs de l’incertitude. Je laisse le lecteur se faire sa propre opinion.

4. Commission des communautés européennes, Bruxelles, le 27.2.2001 COM (2001) 88 final, Livre blanc. Stratégie pour la future politique dans le domaine des substances chimiques.

5. Relations trophiques : relations proies prédateurs dans les écosystèmes.

6. Ce que l’auteur considère à titre personnel comme le choix implicite de privilégier l’expérimentation non contrôlée in situ à l’investigation raisonnée dans un cadre scientifique, donc immanquablement de faire face à des problèmes dans le futur dont le coût en vies animales et en espèces sonnantes et trébuchantes sera bien plus élevé.

7. Florence D. Hulot, Gérard Lacroix, Françoise Lescher-Moutoue & Michel Loreau, 2000. Functional diversity governs ecosystem response to nutrient enrichment, Nature, 405, 340–344.

8. Eutrophisation : enrichissement excessif d’un écosystème aquatique se traduisant par un excès d’algues et une perte de diversité.

9. Mésocosmes : écosystèmes artificiels construits aux fins d’expérimentation en condition contrôlée et de modélisation.

10. Bois F., 2001, Applications of population approaches in toxicology, Toxicology Letters, 120 : 385–394.