Ingénierie de la construction : la science des matériaux change la donne

Une des retombées majeures de la science des matériaux, celle qui pourrait avoir, dans les décennies à venir, le plus grand impact économique et social, se situe dans le domaine de la construction : il s’agit de la technologie de formulation des bétons qui permet, aujourd’hui, de répondre à n’importe quel cahier des charges » matériau » (l’ensemble des spécifications qu’on peut fixer à la commande) dans un très large espace de comportements mécaniques et de propriétés physiques.

Pour l’ingénieur qui conçoit des ouvrages, c’est une véritable révolution qui s’avance et, en même temps, un véritable défi. C’est d’abord une révolution, car il va passer d’une situation de catalogue, où il avait à choisir entre deux ou trois matériaux, présentant chacun une combinaison unique et bien connue de propriétés, à une situation ouverte, à un continuum où pratiquement toutes les combinaisons de propriétés seront possibles, et disponibles avec des différences de coût qui vont s’atténuer et devenir minimes par rapport au coût global de l’ouvrage.

Pour l’architecte qui veut créer des formes nouvelles comme pour l’ingénieur qui doit répondre à des contraintes toujours plus nombreuses, cependant, cet élargissement du champ des possibles constitue un défi majeur car, là où le problème se réduisait à calculer les seuls paramètres géométriques et à vérifier le comportement de l’ouvrage à partir des données du catalogue des deux ou trois matériaux possibles, la flexibilité des propriétés du matériau va ajouter autant de degrés de liberté à la complexité du problème.

Le défi de ce siècle, pour les concepteurs du BTP, pour les ingénieurs qui conçoivent des ponts comme pour les architectes qui dessinent des bâtiments, sera donc de considérer les caractéristiques du matériau comme des variables contrôlables, d’arriver à ne plus les gérer comme des constantes imposées, mais à les utiliser comme des leviers pour créer des formes nouvelles, pour trouver de nouvelles solutions techniques, pour innover.

Une étendue et une liberté étonnantes dans la gamme et les combinaisons de propriétés

Dans les dix dernières années, le béton est devenu, grâce à des avancées scientifiques qui ont mobilisé toutes les disciplines qui constituent la science des matériaux, d’une extraordinaire diversité. S’il est toujours le matériau le plus utilisé sur la planète (plus que tous les autres matériaux confondus) et le plus simple à fabriquer et à mettre en forme, avec des matières premières aujourd’hui encore banales et un matériel rudimentaire, il est aussi en train de s’approcher, grâce à une technologie de formulation fondée sur des concepts scientifiques puissants, de certaines performances des métaux, il peut atteindre une résistance exceptionnelle aux attaques physiques et chimiques, il peut offrir aux architectes une qualité de surface et des possibilités architectoniques de plus en plus étendues.

Jusqu’au début des années quatre-vingt, la formulation du béton était présentée comme un compromis entre la résistance en compression (d’autant plus élevée qu’on mettait moins d’eau dans le mélange initial) et sa capacité à se mettre en place dans les coffrages, propriété qui variait en sens inverse. Les techniques de vibration permettaient alors de décliner une gamme de bétons allant, en termes de résistance en compression (seule propriété spécifiée à cette époque dans les contrats), de 10 à 45 MPa.

À la fin des années quatre-vingt sont apparus les bétons dits de hautes performances (BHP), dont les résistances mécaniques vont jusqu’à 80 ou 90 MPa, mais qui se sont plutôt développés autour de deux atouts : d’une part, leur meilleur comportement dans le temps, leur résistance aux différents types de dégradation qu’on peut observer sur les ouvrages de qualité médiocre [Malier, 1996] et, d’autre part, leur capacité à développer des résistances élevées au jeune âge, permettant d’accélérer les cycles de production. Sans les BHP, on n’aurait pas pu construire le tunnel sous la Manche, l’Arche de la Défense, le pont de Normandie ; ou en tout cas, pas de la même façon.

Pourtant, il y a bien eu, auparavant, des ouvrages en béton performants et durables : il existe des ouvrages construits au xixe siècle1 qui sont en très bon état et qui le resteront (voir l’immeuble construit en 1900 par Hennebique à Paris, 1, rue Danton, ou l’aqueduc de la Vanne, construit entre 1850 et 1860 entre Sens et Paris).

Mais ces performances ne pouvaient pas être exploitées industriellement parce qu’on ne savait pas les reproduire, on ne savait pas prédire la tenue dans le temps d’une formule donnée. C’est pourquoi ces performances ne pouvaient pas être exigées par le client, ne pouvaient pas être prescrites par le maître d’œuvre. Dans la culture constructive de l’époque, cependant, la notion de durée de vie était associée à des exigences de qualité. D’un ouvrage à l’autre, le niveau d’exigence était plus ou moins élevé (et plus ou moins efficace !), ce qui fait que, statistiquement, quelques ouvrages nous sont restés. Certains de ces ouvrages ont pu être utilisés récemment pour valider et calibrer les codes qu’on utilise aujourd’hui pour calculer la durée de vie du matériau.

Pour le tunnel sous la Manche, par exemple, le contrat demandait que le béton ne présente aucune altération pendant cent vingt ans, et en 1988 les experts du maître d’ouvrage (un consortium de banques) ont exigé que le constructeur (un groupement d’entreprises) le prouve. Les experts du groupement ont pu les satisfaire en établissant, d’abord, la liste de tous les mécanismes de dégradation possibles, puis en déterminant, pour chacun de ces mécanismes élémentaires, à partir de la mesure d’une grandeur simple (essentiellement des coefficients de diffusion et des perméabilités), une borne inférieure à la durée d’atteinte d’un critère d’état limite (plus précisément la durée correspondant à un fractile de probabilité 90 %, selon une approche probabiliste, aujourd’hui classique dans le monde de la construction).

C’est la convergence des progrès réalisés à partir de 1980 en matière de connaissances scientifiques (théorie des mélanges granulaires, modèles d’homogénéisation des matériaux composites, etc.) et du développement de toute une génération de nouveaux produits minéraux (fines et ultrafines) et organiques (surfactants) qui a permis d’élargir considérablement la gamme des performances possibles. Les progrès les plus spectaculaires sont dans les deux domaines suivants :

• celui de la mise en œuvre, avec les bétons autoplaçants (BAP), qui se mettent en place sans vibration (un chantier de bâtiment, aujourd’hui, peut être totalement silencieux), avec souvent de très beaux parements ; si ces bétons se répandent rapidement, cependant, c’est d’abord à cause d’une réduction de la pénibilité et d’une mise en œuvre plus rapide, avec une réduction significative de la durée des chantiers ;

• celui des bétons fibrés ultraperformants (BFUP), qui permettent d’atteindre des résistances en compression de 200 à 240 MPa, avec des fibres qui permettent d’éliminer tout risque de rupture fragile ; ces bétons sont aussi extrêmement durables, avec des résultats exceptionnels (souvent en dessous des seuils de détection) dans tous les essais de durabilité ; enfin, grâce à une distribution granulaire optimisée, la rhéologie du béton frais (la facilité de mise en œuvre) peut être contrôlée sur une gamme qui peut aller d’un comportement parfaitement autoplaçant à celui d’un béton sans écoulement, ce qui permet de fabriquer des pièces par extrusion.

Le nouveau paradigme : un matériau dont on peut choisir les propriétés

Le fait qu’un béton résistant à 200 MPa puisse être formulé de sorte qu’il soit autoplaçant, qu’il soit ferme, ou qu’il ait une rhéologie fixée entre ces deux états extrêmes, a fait voler en éclats le postulat d’une corrélation entre résistance et rhéologie et, en même temps, les anciennes méthodes (empiriques) de formulation qui étaient fondées sur cette corrélation.

Il faut dire que ces méthodes étaient parfaitement adaptées à une époque où un béton comprenait 4 constituants, exceptionnellement 5 (alors que, aujourd’hui, il peut en contenir jusqu’à 10 ou 12) et où on n’avait qu’une connaissance empirique des relations entre les paramètres de formulation et les propriétés finales du matériau.

Aujourd’hui, l’ingénieur peut s’appuyer sur des outils, des méthodes, des logiciels, construits sur des bases de plus en plus scientifiques, pour déterminer la composition du matériau qui est optimale pour une application donnée, ou pour un cahier des charges fixé par le maître d’ouvrage en termes de propriétés d’usage. Et dans ce cahier des charges, les propriétés mécaniques (résistance en compression, en traction, module élastique, mode de fissuration), rhéologiques (viscosité, seuil d’écoulement), physiques (perméabilités à l’eau, aux gaz), thermiques (coefficient de dilatation, conductivité et inertie thermique), esthétiques (forme, aspects de surface, couleur) peuvent être choisies avec une étendue de plus en plus large des valeurs possibles et de plus en plus une liberté dans la combinaison de ces valeurs.

Cette liberté de combinaison, de contrôle indépendant des différentes propriétés, est d’ailleurs frappante, dès lors que l’on prend en compte les concepts de l’empilement granulaire (par exemple, si on veut imposer une couleur, on l’obtient par des pigments minéraux colorés, mais il faut ensuite corriger la composition pour rétablir la distribution des tailles de grains). On peut donc parler d’une véritable ingénierie du matériau.

Durée de vie du matériau (dans un environnement donné) et propriétés de surface (la qualité esthétique des façades) figurent parmi les propriétés qui peuvent être contrôlées, en termes de formulation et de mise en œuvre, par le producteur de béton, et donc spécifiées dans un contrat (des indicateurs de durabilité ont été définis récemment par les partenaires, publics et privés, de la construction, et pourraient conduire, si leur contrôle était généralisé, à une amélioration significative et rapidement visible de l’état du patrimoine bâti). En fait, si l’on prend en compte les coûts d’exploitation, de nettoyage des façades, de réhabilitation de l’habitat, le choix d’un béton de performances optimisées peut conduire à une réduction significative du coût global d’un ouvrage.

La science des matériaux : couplage des sciences et science des couplages

Comprendre un matériau comme le béton, comment il se forme, se structure, comment il réagit aux sollicitations mécaniques, thermiques, chimiques, ne peut se faire sans l’association organique de plusieurs disciplines scientifiques.

Le béton, tout d’abord, a une propriété magique qui est que, quelques heures après avoir mélangé les matières premières, on voit le mélange durcir tout seul : le ciment fait prise. Ce changement s’opère selon un cortège de réactions chimiques, dont on connaît bien les équations. On est là dans la chimie minérale.

Il y a aussi cette propriété quasi miraculeuse qui est que la prise ne se fait pas instantanément, mais seulement au bout de deux ou trois heures. C’est la chimie physique qui permet de comprendre et de prédire les processus de dissolution à la surface des grains de ciment et de diffusion.

Passerelle de Séoul en Corée.

Le formidable développement des adjuvants, et notamment des plastifiants et des superplastifiants qui ont révolutionné la mise en œuvre et la vie sur les chantiers, relève de la chimie organique.

La durée de vie potentielle du matériau peut être estimée parce que les mécanismes de dégradation sont tous identifiés et liés à des processus de diffusion qui peuvent être simulés (et couplés avec le comportement mécanique) à partir de la physique et la thermodynamique des milieux poreux.

D’un autre côté, l’ingénieur qui calcule la structure, qui détermine les dimensions des poutres, la section des poteaux, les détails du ferraillage, etc., fait essentiellement des calculs mécaniques, des calculs de structure qui se fondent sur la mécanique des solides et la résistance des matériaux.

Au niveau de la microstructure du matériau, tous ces mécanismes sont en interaction, sont couplés, et l’analyse de ces couplages n’a pu être accessible que lorsqu’on a disposé d’un cadre thermodynamique rigoureux et complet [Coussy, 1999].

Une étape importante a été franchie dans les années quatre-vingt, quand on a commencé à construire une théorie des mélanges granulaires [de Larrard, 1987]. Cette théorie est basée sur l’idée suivante : quand on n’a que des grains de même taille, comme dans un sac de billes, on a toujours un volume relatif de vides important, de l’ordre de 40 % du volume total, et on dira que la compacité C est de 0,60. La compacité d’un mélange monodisperse ne dépend pas de la taille des grains, c’est un invariant car, dans notre espace, l’homothétie conserve les rapports volumiques.

La propriété centrale des mélanges granulaires est que, si l’on mélange deux classes de grains de tailles qui diffèrent d’au moins un ordre de grandeur, alors la compacité est significativement supérieure et peut atteindre, pour un certain rapport optimal qui est calculable (celui qui correspond au remplissage des vides, dont le volume est P = 1 – C, du gros grain par une poudre de compacité C), une valeur théorique de C + P.C = 1 – P2, formule simple qui se généralise facilement aux mélanges de n classes par : 1 – Pn et qui converge très vite vers 1, c’est-à-dire vers l’absence totale de vides. À noter que le volume (théorique) de la classe i + 1 décroît comme Pi (0.4, 0.16, 0.064, 0.0256…) ce qui est économiquement intéressant car les poudres sont d’autant plus chères qu’elles sont plus fines.

De nombreux autres effets, aujourd’hui connus et documentés, doivent être pris en compte, mais cette idée a permis de construire des modèles mathématiques puissants, et surtout robustes, au sens où ils se prêtent facilement aux extensions (sans doute parce que leur fondement mathématique est très solide).

On peut dire qu’on a franchi une première frontière conceptuelle et technologique quand on a ajouté au béton un constituant granulaire de taille inférieure à celle des grains de ciment, et cela a produit la génération des bétons HP, et qu’on a franchi une seconde frontière quand on a complété la gamme des tailles en continu jusqu’à celle de la molécule d’eau, ce qui a ouvert la voie à la génération des BFUP, les bétons fibrés ultraperformants.

Les premiers n’ont pas constitué un véritable saut technologique, car ils restent dans le concept du béton armé, avec les problématiques usuelles de ferraillage et le gain de performance n’a pas pu être valorisé, car ils restent fragiles. Ils sont beaucoup utilisés, cependant, en préfabrication, pour leur capacité à réduire les cycles de production, et dans les ouvrages d’art, soit pour assurer une certaine durée de vie (exemple du Transmanche), soit pour augmenter une performance mécanique (une réduction significative du fluage, par exemple, comme pour les pylônes du pont de Normandie).

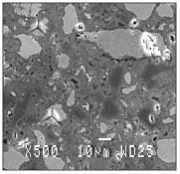

Les seconds, par contre, comme Ductal®, qui ont, grâce à une matrice très performante (plus de 200 MPa en compression) et des fibres, un comportement non fragile, permettent souvent de supprimer les armatures passives, ce qui ouvre un champ tout neuf pour le génie civil et l’architecture, en termes de légèreté, de durabilité, de forme et d’esthétique : passerelle de Séoul, en Corée (photo), pont de Saint-Pierre La Cour, marquises de Shawnessy, etc.

Avec un matériau comme Ductal®, par exemple, on a fait des progrès très significatifs dans la compréhension du matériau au niveau de la nanostructure, dont le plus spectaculaire, sans doute, a été apporté par une méthode d’analyse très puissante issue de la micromécanique : la nano-indentation [Sorrentino, 1999, Ulm, 2002].

Cet essai consiste à enfoncer, sur une surface polie, une fine pointe tétraédrique, avec une entaille de dimension significativement inférieure à celle des grains des différentes espèces chimiques qu’on trouve dans le ciment. On applique une force croissante et on mesure le déplacement vertical de l’aiguille. Avec quelques cycles de charge et de décharge, et des paliers sous charge, on peut accéder aux trois composantes qui caractérisent le comportement mécanique de chaque espèce qui entre dans la microstructure du matériau :

• la composante élastique, avec la pente au premier déchargement,

• une caractéristique plastique, avec la part non linéaire au premier chargement,

• une caractéristique visqueuse, avec la vitesse de déformation au cours d’un palier.

L’examen au microscope permet ensuite d’associer une courbe enregistrée à chaque espèce minérale.

Cette méthode a permis de montrer que seuls les hydrates, les produits formés par la réaction chimique entre l’eau et les silicates du clinker, fluent de manière significative, et que dans les matériaux de haute performance, et tout particulièrement dans un matériau comme Ductal®, seule la périphérie des grains était hydratée, l’hydratation s’arrête par épuisement de l’eau des capillaires, et le cœur des grains de ciment reste intact, avec un module élastique élevé (supérieur à 100 MPa). Ils se comportent donc comme des inclusions élastiques, et non viscoélastiques.

Ces résultats ont ainsi permis de comprendre l’origine du fluage des bétons (qui est significativement plus faible avec les BHP et, avec Ductal®, presque nul) et de construire une description complète du comportement mécanique.

Nanomesures et calcul moléculaire : la dernière frontière est tombée

La science des matériaux a toujours progressé en s’appuyant, simultanément, sur deux démarches parallèles et complémentaires : l’expérience et la modélisation. Micromécanique des matériaux composites et calculs aux éléments finis ont permis de comprendre et de résoudre des problèmes de formulation des matériaux composites à deux phases (matrice et inclusions).

Les avancées récentes en matière de nanomesures, de nanocapteurs ont, en termes de simulation numérique, leur pendant avec le calcul moléculaire, qui progresse aujourd’hui de manière tout aussi spectaculaire, et vient de montrer sa pertinence et son potentiel dans le domaine de la nanostructure (la structure de la pâte de ciment durcie) du béton [Jouanna, Kirkpatrick, Pellencq]. Avec cet outil, on va pouvoir traiter, enfin, de manière scientifique (c’est-à-dire en confrontant théorie et expérience) les questions liées aux interfaces (qui sont multiples dans nos matériaux) et à la cohabitation entre l’organique et le minéral (qui a déjà prouvé, dans la pratique, son potentiel).

En termes d’échelles d’observation et d’analyse, on peut dire que les nanomesures et le calcul moléculaire viennent d’abattre la dernière frontière dans la progression de la science des matériaux à traiter l’ensemble des questions scientifiques que pose, à toutes les échelles (macro, micro, nano) de leur structure, l’ingénierie des matériaux de construction.

Conclusions

Formuler un béton de haute résistance qui ne soit pas fragile, qui soit fluide au point de se mettre en place sans vibration, ou au contraire ferme au point de pouvoir être extrudé, formuler un béton drainant ou un béton imperméable de résistance donnée, un béton qui assure une durée de vie spécifiée (y compris du point de vue de la protection des armatures contre la corrosion), fait aujourd’hui partie de la » boîte à outils » du producteur de béton. Contrôler et assurer le maintien dans le temps d’une teinte, d’une couleur, d’un aspect de surface sont des enjeux majeurs de la recherche appliquée pour les années qui viennent.

De nouvelles associations de propriétés apparaissent sur le marché et la pénétration de nouveaux produits, comme les bétons autoplaçants, prouve la faisabilité et la pertinence économique de ces nouvelles classes de béton.

En deux décennies, on est passé d’un matériau unique, standard, à petit nombre de variantes, à un matériau de plus en plus versatile, au point qu’aujourd’hui on peut ajuster de manière continue, sur des étendues de plus en plus larges, avec une grande liberté, une grande indépendance entre les différentes propriétés mécaniques, physiques, thermiques, esthétiques. Les logiciels de formulation sont de plus en plus performants parce qu’ils ne sont pas fondés seulement sur des relations empiriques, ou statistiques, mais sur des lois physiques et des modèles mathématiques rationnels.

Quand on connaît la diversité des situations (climatiques, industrielles, environnementales, sociales, etc.) des ouvrages de génie civil, particulièrement dans le domaine des infrastructures, il est clair que cette capacité nouvelle offre des perspectives intéressantes à l’ingénieur constructeur. Son passage sur le terrain cependant sera long et progressif, car il demande une profonde modification de la démarche de conception, un changement culturel certain.

La révision des normes (et du statut même des normes), la refonte en profondeur de l’enseignement des matériaux de construction (et de sa position dans la formation des ingénieurs) sont, certes, une nécessité, mais c’est le développement de partenariats entre producteurs de matériaux, constructeurs et concepteurs qui est aujourd’hui la voie de progrès la plus prometteuse.

__________________________________

1. On pourrait aussi citer le Panthéon à Rome et Sainte-Sophie à Istanbul, qui sont deux des ouvrages de l’Antiquité qui ont le mieux résisté, les seuls dont les coupoles sont encore en place ; le premier est entièrement en béton, il y a même des fondations au dôme, quatre formules différentes, avec des granulats différents et, comme ciment, une association de chaux et de silicates qui sont fournis soit par de la brique pilée soit par des sables d’origine volcanique, association qui leur donne une composition chimique très proche de celle de nos ciments modernes (voir les écrits de Vitruve).