La modélisation mécanique en cardiologie : vers le patient virtuel

Les maladies cardiovasculaires sont un problème de santé publique majeur dans le monde. Le diagnostic précoce de ces affections constitue un enjeu crucial pour assurer leur recul. La simulation numérique devient petit à petit un outil potentiel d’aide clinique, sur lequel on fonde de grands espoirs.

Le diagnostic précoce des maladies cardio-vasculaires a permis, depuis deux décennies, de limiter statistiquement le développement des maladies cardiovasculaires face aux maladies cancéreuses. Cependant, ce sont principalement les AVC qui ont chuté grâce à une meilleure prise en charge de l’hypertension artérielle, et diminuer la mortalité des autres maladies cardiaques reste un défi considérable malgré la dissémination d’appareils d’imagerie de plus en plus sophistiqués (notamment l’IRM) dans les pays industrialisés.

REPÈRES

Première cause de mortalité aux États-Unis, seconde en Europe, les maladies cardiovasculaires sont aussi en forte croissance en Chine, au Brésil, comme dans de nombreux pays émergents. Après les accidents vasculaires cérébraux (AVC), les pathologies les plus fréquentes sont les maladies coronariennes conduisant à l’infarctus du myocarde et à l’insuffisance cardiaque, ainsi que les troubles du rythme ou arythmies cardiaques, mais il existe aussi un très grand nombre de pathologies moins répandues, notamment des malformations congénitales. Rien qu’en Europe, ces maladies ont un impact économique d’environ 170 milliards d’euros par an.

Le cœur, mécanique modélisable

Le cœur, organe vital par excellence, est le siège de phénomènes physiques extrêmement divers. À l’origine de la contraction de l’organe, on trouve une activité électrique régulière, révélée à l’électrocardiogramme, correspondant à la propagation d’une onde de dépolarisation dans le cœur. En réponse à cette activation, le cœur se contracte et assure ainsi sa fonction motrice : celle de pomper le sang dans les poumons pour qu’il soit oxygéné, et vers le reste des organes pour les alimenter. Nous ressentons cette activité mécanique au quotidien et on la mesure lors de l’auscultation, de la prise de tension ou des examens par imagerie médicale, notamment par échographie ou IRM.

Cette richesse des phénomènes physiques éveille depuis plus d’un siècle la curiosité de ceux qui, comme

A. F. Huxley (prix Nobel de médecine 1963), souhaitent modéliser le fonctionnement de l’organe au travers de descriptions physiques et mathématiques adaptées, en vue d’en dégager des interprétations ou applications précises. Il y eut d’abord la recherche d’une compréhension en profondeur des mécanismes temporels régulant le comportement de la cellule ou de la fibre cardiaque, décrites par les mathématiciens au moyen d’équations différentielles. Mais on souhaita aussi comprendre, dès 1937 avec Kolmogorov, l’évolution à la fois temporelle et spatiale de la propagation de l’activité électrique dans l’organe ou, dans les années 50, de la contraction mécanique. Ces phénomènes distribués dans l’espace sont typiquement représentés par des équations aux dérivées partielles (EDP) reliant l’évolution en temps du phénomène aux variations spatiales locales.

Des modèles arrivant à maturité

En parallèle avec le développement des outils de calcul scientifique, la communauté mécanique s’est emparée, dès les années 70, du sujet de la modélisation des phénomènes physiques à l’échelle du tissu et de l’organe à l’aide du formalisme des milieux continus. Les modèles et les méthodes computationnelles ont progressivement permis d’appréhender des phénomènes de plus en plus complexes et de plus en plus couplés, de la contraction du tissu cardiaque à son interaction avec l’activité électrique ou avec le fluide sanguin présent dans les cavités cardiaques.

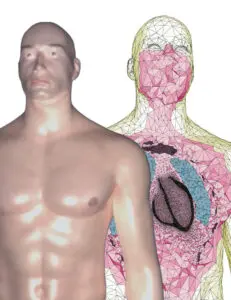

On peut considérer que certains de ces modèles sont arrivés à maturité au début de la présente décennie, en termes de capacité prédictive du battement cardiaque et de certaines pathologies associées. Cela ouvrit la voie à l’utilisation de modèles dans le cadre du pronostic et du diagnostic clinique. Ainsi, la simulation numérique devient petit à petit un outil potentiel d’aide clinique, validé et encouragé par les instances de régulation médicale européennes ou américaines par exemple, et porté par de nouveaux acteurs industriels tels que Dassault Systèmes, qui voient ici de nouvelles applications de leurs outils de modélisation numérique en ingénierie biomédicale.

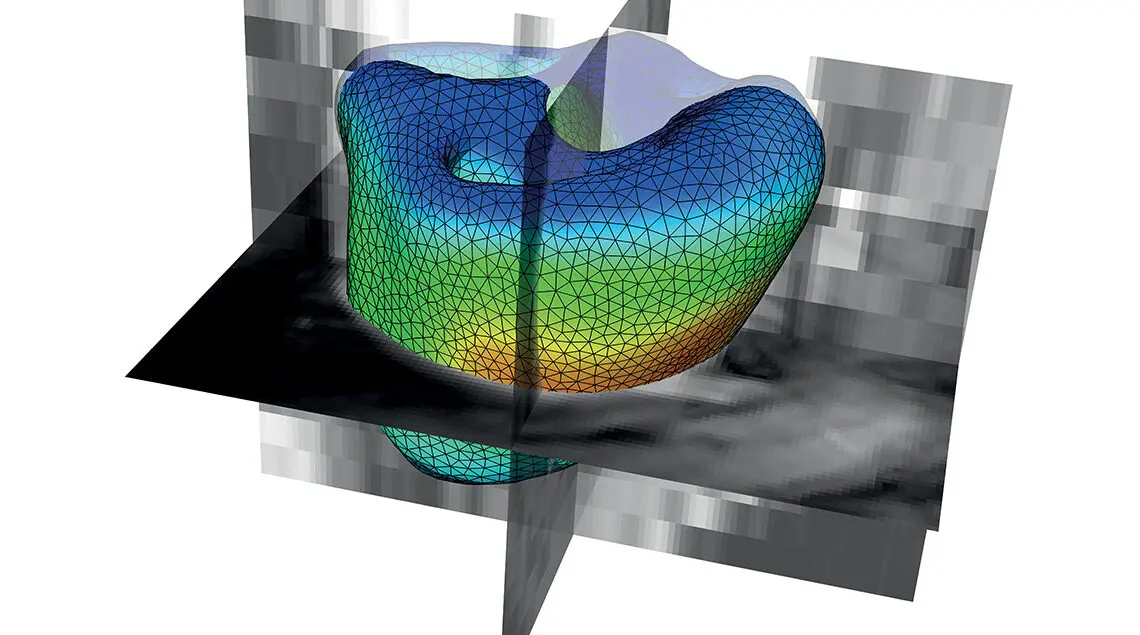

Quand on parle de pronostic et de diagnostic assistés par l’outil numérique, il faut non seulement développer des modèles mathématiques précis et rigoureux, des méthodes numériques robustes et efficaces pour les simuler, mais il faut aussi les personnaliser pour chaque patient à partir de données biomédicales (notamment les images issues de scanners, IRM, échographies, etc.). Les données interviennent de deux façons dans la personnalisation des modèles : on peut, classiquement, adapter les paramètres des modèles pour que leurs prédictions soient au plus proche des données ; on peut également ajouter des termes d’écart aux données directement dans le modèle.

C’est l’objectif que se donne l’assimilation de données, initialement introduite sur les grands systèmes de météorologie et climatologie, qui permet de fusionner modèles et mesures pour produire une représentation numérique prenant en compte toutes les informations disponibles, c’est-à-dire les connaissances a priori et les mesures physiques. Il est à noter que l’assimilation de données représente aussi une méthode de traitement de données (notamment d’images) efficace, où le modèle correspond aux connaissances a priori utilisées pour régulariser le problème de l’extraction d’informations à partir des données. Cette approche est d’ailleurs en légère opposition avec le paradigme actuel du « tout données », où des modèles purement statistiques sont construits uniquement à partir de données, sans s’appuyer sur les grands principes physiques.

“Il faut développer

des modèles mathématiques personnalisés

pour chaque patient.”

Une aide au diagnostic et au pronostic

Dans notre cas particulier de la cardiologie, en partant d’un battement cardiaque virtuel pour un cœur générique supposé sain, nous pouvons créer des mesures virtuelles comparables à celles recueillies lors des examens du patient. L’écart entre ces mesures virtuelles et les mesures réelles traduit la spécificité du cas étudié, et les méthodes d’assimilation de données sont alors capables de modifier le battement cardiaque simulé en interprétant et réduisant autant que possible cette différence constatée. Une fois la spécificité du patient déterminée, autrement dit le diagnostic, on peut alors laisser évoluer la simulation pour réaliser une prédiction du comportement futur, à savoir le pronostic. Pour ce qui est du diagnostic, on peut par exemple, dans le cas d’un infarctus du myocarde, estimer de façon objective et quantitative la localisation et l’intensité du dommage induit dans le tissu.

En termes d’aide au pronostic, le modèle personnalisé peut être utilisé pour tester in silico l’impact de diverses stratégies thérapeutiques (pharmacologie, chirurgie, dispositifs…) afin de réaliser une analyse risque / bénéfice, comparer quantitativement les stratégies et déterminer la plus adaptée au patient concerné. L’entreprise américaine HeartFlow, issue de l’université Stanford, réalise ainsi des prédictions par simulation numérique sur modèles personnalisés des effets de rétrécissements coronariens, permettant alors de déterminer si une intervention serait bénéfique.

Dans le même registre, des équipes Inria (dont MΞDISIM) associées à l’hôpital Saint-Thomas de Londres ont réalisé une preuve de concept de l’utilité des modèles numériques personnalisés pour anticiper l’impact de la thérapie de resynchronisation cardiaque (CRT), largement pratiquée (150 interventions par an et par million d’habitants en Europe de l’Ouest), alors qu’on estime qu’elle ne présente aucun bénéfice, au résultat, pour plus d’un patient sur deux. Dans un tel exemple, la simulation numérique permettra non seulement de limiter les coûts et les risques associés aux interventions sans bénéfice, mais aussi d’adapter et d’optimiser la procédure pour chaque patient, et ainsi d’en améliorer significativement le succès.

Un riche champ restant à explorer

Reste que la compréhension profonde des mécanismes complexes intervenant dans le battement de notre cœur est une source intarissable de problèmes nouveaux pour la modélisation mécanique et le calcul. L’équipe MΞDISIM travaille aujourd’hui sur la formulation de modèles multiéchelles et multiphysiques permettant par exemple la prise en compte de la perfusion (alimentation en sang) du tissu cardiaque et des pathologies associées (ischémie, infarctus), les phénomènes de propagation d’ondes que de nouvelles techniques d’élastographie commencent à révéler, ou encore les effets fins des grandes déformations mécaniques sur l’activité électrique.

Aux plus grandes échelles de temps, les phénomènes de croissance et de remodelage, qui en majeure partie trouvent leurs sources aux plus petites échelles spatiales, sont des enjeux importants, tout autant que les mécanismes de régulation et de couplage entre les différents compartiments du système cardiovasculaire. À titre d’exemple, en collaboration avec l’université Stanford, l’équipe a proposé un modèle de croissance (évolution de la quantité de matière) du myocarde qui permet de reproduire le remodelage des ventricules au fil des mois et des années, notamment du fait de l’hypertension artérielle ou pulmonaire.

Ces avancées théoriques doivent être accompagnées de développements expérimentaux, eux aussi novateurs et adaptés à la complexité des tissus vivants, car bien souvent les mécanismes physiques eux-mêmes sont mal identifiés. Tous ces éléments constituent autant de défis scientifiques qui se conjuguent aux enjeux cliniques, industriels et sociétaux.

Retrouvez l’ensemble du dossier : La mécanique