La mutation des réseaux

Une mutation d’une ampleur et d’une rapidité sans précédent

Les grands réseaux de télécommunications ont de tout temps été le siège d’évolutions majeures dont une partie importante tient à leur aptitude à capter l’innovation technologique, qu’elles proviennent des techniques de codage, des techniques de transmission de l’information ou de l’informatique.

L’histoire montre que cette prise en compte de l’innovation s’est rarement déroulée sans controverse et que bien souvent l’arrivée des nouvelles technologies a donné lieu à des affrontements passionnés. On se souvient encore de l’irruption du numérique au cœur des réseaux avec l’arrivée de la commande par programme enregistré, puis de la commutation temporelle avec la numérisation des signaux de parole qui a supplanté la commutation crossbar, de la transmission SDH puis de la transmission optique, de la signalisation par paquet CCITT n° 7 qui remplaça la signalisation analogique par codes multifréquences…, etc.

L’ampleur et la vitesse des bouleversements technologiques d’aujourd’hui autorisent à parler de véritable mutation (au sens génétique du terme) des réseaux, même si certains pourraient à juste titre faire remarquer que ce qui se produit n’est que l’achèvement du processus de généralisation du numérique sur toute la chaîne, du client jusqu’aux applications et aux contenus et l’arrivée de l’abondance en termes de débit, au moins pour ce qui concerne les parties fixes du réseau.

La ligne d’abonné, dernier goulot d’étranglement (le transport et la signalisation au cœur des réseaux ont commencé leur mutation avant), est aujourd’hui l’objet d’une véritable révolution en ce qui concerne les débits, y compris sur la partie cuivre. La barrière des débits étant franchie, le réseau étend ses fonctions jusque chez le client donnant sens à la conception d’un opérateur de services intégrés fixes, mobiles et Internet.

D’autres transformations aussi profondes sont à l’œuvre au cœur des réseaux puisque le remplacement programmé du réseau téléphonique commuté par une infrastructure réseau multimédia et haut-débit est à portée de vue. Tout bouge, des réseaux de collecte à technologie Giga Éthernet et ATM jusqu’aux réseaux dorsaux IP, des plates-formes de services jusqu’aux protocoles de commande convergents fixe et mobile…

Toutes ces transformations affectent fortement les « Business Model » des réseaux de télécommunications. Le transport de la voix en paquets IP, par exemple, qui provoque une chute de valeur sans précédent du transport brut de la voix sur les réseaux fixes.

La demande fondamentale des clients est d’avoir un accès global, homogène et simple à leurs moyens de communication. France Télécom s’organise en conséquence, en opérateur intégré capable de fournir de façon homogène les services fixes, mobiles et Internet. Réseau haut-débit et système d’information évoluent de concert afin de rendre tangible cette nouvelle vision de l’opérateur.

Un goulot d’étranglement qui disparaît : le haut-débit sur la ligne d’abonné

La ligne d’abonné

Goulot d’étranglement traditionnel en termes de débit et de richesse des informations de commande réseau que l’on pouvait y véhiculer, la ligne d’abonné, qu’elle soit fixe ou mobile, vit une véritable révolution.

Dans un premier temps, avec les améliorations des techniques de transmission de données (avec un modem situé dans le PC du client et un autre situé dans le réseau que l’on atteint en établissant une communication circuit), il a été possible par des techniques analogiques d’obtenir des débits de l’ordre de quelques dizaines de kbit/s. Ensuite, le RNIS (Réseau numérique à intégration de services) avait réalisé la première numérisation de la ligne d’abonné à des débits de 2 fois 64 kbit/s symétriques (canaux de transport d’informations appelés canaux B) voire 30 fois 64 kbit/s pour les entreprises. À ces canaux B s’ajoutait le canal D utilisé pour la signalisation entre le client et le réseau ou entre clients à un débit de 16 kbit/s ou de 64 kbit/s.

| ADSL | Débit max sur le canal descendant 6,5 à 10 Mbit/s Débit max sur le canal remontant 1 Mbit/s Portée : 2 km à 6,5 Mbit/s |

| ADSL2+ | Débit max sur le canal descendant 16 à 20 Mbit/s Débit sur le canal remontant 1 Mbit/s max Portée : 1,3 km à 13 Mbit/s et près de 2 km à 8 Mbit/s |

| SDSL | Débit de 2 à 8 Mbit/s symétriques sur mono et multipaire cuivre |

| VDSL | Débit jusqu’à 30 Mbit/s sur le canal descendant |

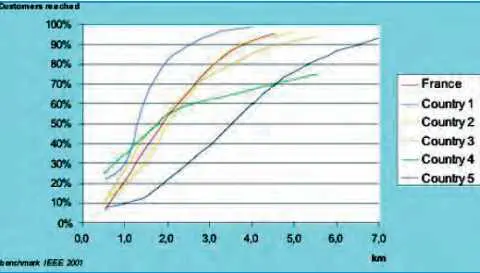

| Figure 1 Comparaison des lignes d’abonnés dans différents pays |

|

|

|

Ces débits à l’accès se sont révélés rapidement insuffisants et les techniques de multiplexage de circuits qui étaient utilisées ont rapidement fait apparaître leur manque de souplesse : toute offre de débit devait être construite avec des débits multiples de 64 kbit/s et les besoins de transmission sporadique de données étaient assez mal satisfaits par la commutation de circuits qui alloue des débits permanents aux sessions de communication. C’est en ayant pour cible les services de vidéo à la demande, qu’au début des années quatre-vingt-dix aux États-Unis, quelques opérateurs se sont lancés dans l’industrialisation de la technique mise au point (dans les années 1988) par Bellcore de transmission haut-débit sur la ligne de cuivre. Il s’agissait pour Bellcore d’offrir aux opérateurs de télécommunications une technologie asymétrique (c’est-à-dire la transmission descendante vers le client est à un débit beaucoup plus important que le sens remontant) capable de rivaliser avec celle des câblo-opérateurs. C’est ainsi que l’ADSL (Asymetric Digital Subscriber Line) est née.

Finalement l’usage de l’ADSL ne sera pas déclenché par les services de vidéo mais par les services d’accès à Internet à la fin des années 1990.

L’ADSL est une technique de transmission qui consiste à réutiliser les câbles de cuivre qui relient les centraux téléphoniques jusqu’au domicile des clients. Chacun d’entre eux est relié au central téléphonique par une paire de cuivre ; celles-ci sont assemblées dans plusieurs équipements de distribution sous forme de câbles de plus grosse capacité. C’est ce que l’on appelle la boucle locale. Traditionnellement, les signaux de voix téléphonique analogique n’utilisent que la bande 300–3 400 Hz. Le principe de l’ADSL est d’utiliser la bande de fréquences laissée libre par les signaux de voix analogique pour fournir un service à haut-débit qui permet, pour les techniques ADSL1, d’avoir un débit qui peut atteindre jusqu’à 8 Mbit/s IP dans le sens descendant et 640 kbit/s dans le sens remontant. À titre de référence, un débit de 8 Mbit/s correspond à la transmission de 120 conversations téléphoniques simultanées.

La technique utilisée par l’ADSL consiste à découper la bande des fréquences transmissibles (de 30 kHz à 1 mégahertz) sur la paire de cuivre en sous-bandes dans lesquelles on essaie de transmettre le plus d’informations possibles, sachant que plus la fréquence est élevée, plus l’affaiblissement du signal est important. Plus la ligne de cuivre est longue et moins la partie haute de la bande de fréquences peut être utilisée efficacement et donc moins les débits fournis par ADSL sont élevés. Par ailleurs, les perturbateurs qu’on trouve sur les lignes (résultant des phénomènes de diaphonie : les signaux émis sur une paire dans un câble créant du bruit sur les autres paires) limitent la transmission d’information. La modulation mise en place dans le cas de l’ADSL est auto-adaptative, c’est-à-dire qu’elle s’adapte aux caractéristiques de la ligne, notamment à sa longueur et aux perturbateurs dont elle est le siège.

Comme l’indique la figure 1, la longueur des lignes qui ont été construites en France, et qui sont en permanente évolution, place notre pays en très bonne position en potentiel de couverture à haut-débit sur ligne de cuivre. Ce potentiel correspond au pourcentage de lignes d’abonnés capables d’atteindre un débit donné. Par exemple, plus de 95 % des lignes en France sont susceptibles de transporter un débit supérieur à 512 kbit/s (du central vers l’installation du client) en technologie ADSL1 et plus de 98 % en employant la nouvelle technologie dite Reach Extended ADSL (RE ADSL).

On assiste, sur la ligne de cuivre, à une montée en débit impensable il y a encore quelques années. Les techniques, mises au point dans les années 90, ont fait l’objet de progrès continus avec l’ADSL2 + et le VDSL qui offrent des débits supérieurs à l’ADSL.

On constate également le développement de techniques de transmission symétrique sur cuivre avec le SDSL. Toutes ces techniques sont désignées globalement par le nom de « xDSL ».

Les montées en débit, que permettent les technologies au-delà d’ADSL1, s’accompagnent d’un élargissement de la bande de fréquences utilisée. Les performances maximales de ces technologies ne peuvent être atteintes que par une partie des lignes. Pour généraliser des offres à très haut débit (20 Mbit/s par exemple) de façon significative, il faut envisager de raccourcir la longueur des lignes. Pour ce faire, il convient de rapprocher les équipements DSL des clients et de les relier aux centraux au moyen de fibres optiques.

Les investissements nécessaires sont à comparer avec ceux qu’induirait un raccordement des clients au moyen de techniques toutes optiques (FTTP) : Fiber To The Premises. Celles-ci présentent l’avantage d’offrir aux clients des débits plus importants que le cuivre, même dans le cas où l’on recourt à des techniques de partage des fibres, du type réseaux passifs optiques (PON Passive Optical Network) et de permettre des débits remontants plus élevés.

La croissance des débits de raccordement des clients, rendue possible par le déploiement des techniques xDSL, permet de faire très fortement évoluer les offres de service. D’abord dédié à l’accès à Internet, l’accès à haut-débit devient multiservices. Les débits disponibles permettent très souvent de faire coexister sur le même accès cuivre une offre d’accès à Internet, une offre de voix portée par le canal xDSL en complément ou en substitution du service téléphonique analogique et une offre de télévision du type diffusé ou à la demande. Ces possibilités nouvelles bouleversent les modèles économiques traditionnels des opérateurs fondés sur les services de voix et font apparaître des perspectives nouvelles.

Les accès sans fil au réseau fixe

De nouvelles techniques radio autorisant le haut-débit apparaissent et sont déployées. Elles viennent compléter le panorama des technologies possibles pour la portion terminale du réseau fixe. Elles viendront s’ajouter aux techniques xDSL, pour offrir une couverture à haut débit pour 100 % des lignes avant la fin de 2006.

Les techniques Wi-Fi (Local Area Network radio) permettent d’atteindre des débits de l’ordre de la dizaine de Mbit/s sur des distances inférieures à 100 m. Elles sont d’ores et déjà utilisées pour des raccordements haut-débit dans des zones très peu denses.

Beaucoup d’espoirs reposent sur la technologie WIMAX. Elle permettrait de partager un débit de plusieurs dizaines de Mbit/s entre plusieurs utilisateurs sur des distances de quelques kilomètres. La portée et le débit de cette technologie doivent permettre d’offrir des services à haut-débit dans les zones très peu denses plus économiquement que le Wi-Fi.

Les accès mobiles

La seconde génération d’accès mobile (GSM Global System Mobile), normalisé en Europe, est un remarquable succès mondial.

Il a introduit le numérique dans les communications radio-mobiles. Il a généralisé les techniques de « Hand Over » entre cellules jointives qui autorisent le maintien des communications établies lorsque l’on se déplace de cellule en cellule.

Il a permis également, avec le succès que l’on sait, le développement des techniques de « Roaming » (ou itinérance) grâce auxquelles un mobile peut être utilisé depuis le réseau d’un opérateur étranger. On peut noter également le succès commercial fantastique remporté par la transmission de données entre clients plus connue sous le nom de » SMS » (« Short Message Service »).

Afin d’améliorer les performances du GSM en matière de transmission de données, une nouvelle technique a été étudiée qui permet des échanges à des débits de 30 à 40 kbit/s. Cette nouvelle technique appelée GPRS s’appuie sur les infrastructures radio des réseaux GSM et nécessite le déploiement d’un cœur de réseau » paquets » qui permet d’aiguiller les données émises par les mobiles vers des réseaux IP tout en conservant la mobilité du terminal.

Les nouveaux services multimédias mobiles (visiophonie, images, TV mobile) nécessitent des débits plus importants. Cela a conduit à étudier, dès le milieu des années 1980, et à normaliser à partir de 1999 une nouvelle norme radio appelée UMTS (Universal Mobile Telecommunication System) ou norme radio mobile de 3e génération.

Cette dernière autorise des débits dix fois plus élevés que le GSM/GPRS. L’UMTS permet des débits de 64 kbit/s en mode circuit, avec garantie de débit utilisable pour la visiophonie. Un débit de 384 kbit/s en mode paquet est disponible pour des services comme le « streaming ».

IP et Giga Éthernet : des technologies mutagènes qui bousculent les réseaux

Deux technologies transforment profondément le paysage des réseaux. Il s’agit des technologies IP et Giga Éthernet.

L’une des principales mutations du cœur des réseaux est le basculement accéléré des techniques de commutation de circuits vers la commutation de paquets plus économique et plus flexible, notamment lorsqu’il s’agit de fournir des services de données. Toutefois, les réseaux téléphoniques commutés resteront certainement encore présents pendant des années au niveau mondial.

L’autre mutation qui s’est produite est interne aux technologies de transport de paquets elles-mêmes, avec le déferlement des protocoles sans connexion. Leur particularité est que chacun des paquets d’un même flux de données est transporté indépendamment des autres muni d’une adresse d’acheminement. C’est le cas du protocole IP (Internet Protocol) qui a pris le pas sur les techniques de transport de paquets orientés connexion comme celles des réseaux X.25 pour lesquelles les différents paquets d’une même communication sont liés entre eux par un identifiant de circuit virtuel. La querelle qui a opposé les partisans de l’ATM orientée connexion et ceux de l’IP prend fin avec l’adoption du protocole IP adopté de façon généralisée comme technique fédérative, depuis les applications jusqu’au transport et au routage au sein des nouveaux réseaux dorsaux.

Les réseaux IP sont constitués d’équipements appelés routeurs, chargés d’acheminer les paquets d’information munis d’étiquette de routage vers leur destination finale. Tous les paquets d’une même communication sont traités indépendamment des autres. Ils ne suivent, en principe, pas le même chemin et le réseau ne peut garantir le respect de l’ordre de transmission. C’est aux deux extrémités de mettre en œuvre les protocoles permettant de réordonner les paquets et de demander la retransmission de ceux qui auraient pu être perdus. La simplicité et la flexibilité du protocole IP ont donc favorisé son adoption dans bon nombre d’applications et de réseaux. Il est devenu, de fait, le protocole structurant des nouveaux réseaux aptes à transporter à très grande échelle les flux de données. Plus généralement, moyennant quelques précautions, (concernant la perte de paquets, le temps de transfert, la disponibilité, le temps de convergence après panne…), il permet le transport de la voix et l’ensemble des flux médias y compris les flux conversationnels.

Contrairement aux réseaux traditionnels, les réseaux IP transportent les flux de commande et de signalisation comme des flux de données ordinaires. La construction de nouvelles offres de services s’en trouve très fortement simplifiée, car tout élément raccordé au réseau peut être acteur de la commande du réseau. Évidemment, cette possibilité est aussi source de risques pour le réseau et pour ses utilisateurs. Des mesures de sécurité spécifiques doivent donc être mises en œuvre. Certaines applications nécessitant d’isoler des flux de données ou de garantir leur délai de transfert, on a été conduit à construire au-dessus du protocole IP des mécanismes additionnels permettant de contrôler le routage des flux de paquets. L’identification des flux, leur séparation, voire l’affectation de ressources spécifiques ont nécessité la mise au point de techniques comme le « tunnelling » (conduit logique qui permet de forcer le passage des paquets dans certains nœuds) ou le protocole MPLS (Multi Protocol Label Switching). Ces techniques apportent les avantages du mode connecté au « monde sans connexion »…

Un point délicat des réseaux IP est l’absence de gestion native de la qualité de service. Les phénomènes de perte de paquets dus à des surcharges momentanées des liens qui interconnectent deux routeurs, ou bien à des reconfigurations des tables de routage consécutives à des pannes de liens de transmission ou de routeurs, ont des effets différents sur la qualité de service vue du client selon la nature des paquets transportés : paquets de données ou paquets contenant des signaux de téléphonie ou télévisuels en temps réel. Dans le premier cas, les protocoles appliqués de bout en bout par l’émetteur et le récepteur permettent de mettre en œuvre des mécanismes de reprise ou de retransmission qui permettent d’assurer la transmission des données après un certain retard. Dans les autres cas, le caractère isochrone des signaux à transporter ne permet pas d’utiliser les mêmes moyens pour se protéger contre les pertes de paquets. C’est, donc, au réseau d’assurer lui-même la qualité de service requise. Des mécanismes spécifiques ont donc été développés pour introduire des priorités de traitement de certains paquets lors de surcharges du réseau, ce sont les classes de service. Le marquage prioritaire des paquets de voix permet, par exemple, d’éviter une longue attente ou une perte de données devant une ligne de transmission momentanément surchargée. De même, d’importants progrès ont été faits sur les durées de reconfiguration des tables de routage en cas de panne d’un élément du réseau.

Jusqu’à une date très récente, l’architecture des routeurs du marché ne permettait pas d’obtenir le niveau de fiabilité requis pour le service sans une forte redondance du réseau. C’est pourquoi le réseau IP de France Télécom est complètement dupliqué tant au niveau des routeurs, qu’au niveau des liens de transmission. En régime nominal, il peut transporter jusqu’au double du débit pour lequel il est dimensionné. Un effet secondaire de cette redondance est que les situations de surcharge sont très rares et les mécanismes de classe de service peu utiles à l’heure actuelle.

Un autre aspect très important concernant les réseaux IP est celui de leur sécurité face à des attaques. Comme on l’a vu plus haut, l’ouverture des réseaux IP les rend vulnérables aux attaques d’utilisateurs malveillants. La sécurité est donc une préoccupation constante des opérateurs exploitant des réseaux de ce type. Ce souci pousse les opérateurs à développer des mécanismes de protection du trafic des clients comme le filtrage en périphérie, des mécanismes dits « d’antispoofing » (contre l’usurpation d’adresses), de protection des flux client ou des flux de commande par la technique de Réseau privé virtuel (VPN). En outre, des protections renforcées contre le déni de service1 ainsi que des mécanismes de contrôle d’accès aux équipements IP, jusqu’à rendre certains équipements non adressables par Internet, sont également mis en place.

Aujourd’hui, la version du protocole IP est la version dite « IPv4 ». Craignant une pénurie d’adresses à court terme, une version plus évoluée a été spécifiée appelée IPv6. Cette crainte est aujourd’hui beaucoup moins pressante qu’il y a quelques années grâce par exemple à la mise en œuvre de mécanismes de séparation entre plan d’adressage privé et plan d’adressage public, et au mécanisme dit de « Traduction d’adresse ». Néanmoins, le développement d’objets communicants à travers le monde, et les flexibilités qu’offrent les nouvelles fonctions de la version IPv6 (au niveau adressage et mobilité) permettent d’augurer une transition du monde IP vers IPv6 à plus ou moins courte échéance. France Télécom se prépare à cette transition en mettant en œuvre IPv6 dans une partie de son réseau IP.

Les réseaux IP s’appuient sur une infrastructure de transmission numérique à très haut-débit construite sur des câbles à fibres optiques. La période de très forte croissance des réseaux IP a coïncidé avec le déploiement de systèmes de multiplexage en longueur d’ondes (DWDM) qui permettent, à ce jour, de multiplier par plus de 40 la capacité de transmission d’une fibre. La même fibre véhicule plusieurs longueurs d’onde, offrant un débit de 2,5 ou 10 gigabit/s. Aujourd’hui la croissance du réseau de transmission reste conduite par la croissance de la demande en trafic IP. Mais le « tout optique » dans les cœurs de réseaux qui devrait aboutir à une couche de transmission optique reconfigurable sur commande des routeurs IP n’est pas envisageable avant plusieurs années. La rupture technologique se produira lors de l’introduction du brassage tout optique, avec l’utilisation de multiplexeurs à insertion/extraction optiques et reconfigurables.

Les réseaux de collecte

D’une façon schématique les réseaux raccordent les utilisateurs, collectent leur trafic, l’acheminent et le livrent. Les réseaux en charge de la collecte du trafic étaient au démarrage des réseaux d’accès haut-débit à l’Internet, basés sur la technologie ATM (Asynchronous Transfer Mode). Ils relient les nœuds de raccordement des lignes ADSL haut-débit, appelés DSLAMs, aux nœuds d’entrée des réseaux dorsaux IP, appelés BAS (Broadband Access Server).

Un nouveau protocole, le Giga Éthernet, offre une meilleure équation économique notamment lorsque les débits de collecte croissent. Cette technologie, en provenance du monde informatique et des réseaux d’entreprises est utilisable pour les réseaux de collecte et dans la desserte des entreprises. Elle consiste schématiquement à transporter des trames Éthernet sur une longueur d’onde. Bénéficiant d’une base installée considérable, elle trouve des applications dans le transport des signaux à très haut-débit comme les bouquets de télévision. Les réseaux de collecte ATM continueront néanmoins à être utilisés car plus à même de transporter les flux d’information synchrones.

Point d’entrée du réseau de collecte haut-débit, le DSLAM devient progressivement un nœud d’accès universel en intégrant les fonctions que les commutateurs d’abonnés jouaient au sein du réseau téléphonique commuté. Cet équipement chargé de regrouper les différents flux de service (Internet, VoIP, vidéo…) émis par plusieurs clients va aussi évoluer pour passer d’une architecture fondée sur du brassage ATM vers une architecture fondée sur la commutation Éthernet. Il constitue le premier nœud d’un futur réseau de communication multimédia.

1. Manœuvre malveillante consistant à empêcher un utilisateur ou un nœud de remplir son rôle en le submergeant par exemple de trafic inefficace.