La physique des particules

La physique de l’élémentaire

Si l’appellation « Physique des particules » est traditionnelle pour désigner l’étude des constituants de la matière, je lui préfère de beaucoup celle de « Physique de l’élémentaire ». À la question : « De quoi la matière est-elle faite et quelle est son origine ? », une longue tradition occidentale tente en effet de répondre par une hiérarchie de structures, convaincue que la variété de la nature est obtenue par l’assemblage de corpuscules élémentaires d’un petit nombre de types. L’idée est simple et forte, et encore de nos jours, la découverte d’une nouvelle « particule » est un événement aussi bien pour le public que pour les chercheurs. Pourtant, la physique moderne a élargi considérablement les concepts de constituants et d’interactions : la mécanique quantique nous indique en effet qu’une particule est aussi une onde, cependant que dans la relativité générale, matière et espace-temps eux-mêmes apparaissent comme des champs. Dans les théories récentes des supercordes, les particules perdent même leur caractère ponctuel et sont décrites comme des cordes ou membranes en interaction dans un espace à dix (ou peut-être onze…) dimensions.

L’image familière du monde des particules est donc initialement celle des poupées russes : dans la matière, des atomes, dans un atome un noyau (et des électrons), dans un noyau, des protons et des neutrons, dans un proton des quarks… Selon cette image, tout progrès de la discipline serait lié à la découverte d’un nouveau composant, plus petit. En fait, ce que les physiciens recherchent avant tout, ce sont des structures élégantes, et la description de la matière par un modèle simple et cohérent.

Il est vrai que, parfois, l’explication de ces structures, la simplification du modèle viennent de l’introduction d’une nouvelle échelle de composants. Le premier exemple fut d’expliquer la variété des éléments chimiques et la composition du tableau de Mendeleïev par la structure des atomes, et leur description en protons, neutrons et électrons. Le second permit d’expliquer la nature des nombreuses particules découvertes dans les années 1960 auprès des accélérateurs, comme des assemblages variés d’un petit nombre de composants : les quarks.

Pour autant, cette image simple est trop limitée. L’ambition est en effet bien plus vaste : le modèle recherché doit en effet rendre compte de toutes les propriétés de la matière, naturelle ou artificielle, à toutes les échelles de taille ou d’énergie, et à toutes les époques, du big bang à nos jours. Le cœur de cette compréhension est le Modèle standard, qui décrit avec rigueur et précision les constituants de la matière et leurs interactions. Toute nouvelle mesure, qu’elle provienne d’un accélérateur de particules ou d’une observation par satellite, est immédiatement confrontée au Modèle standard. Aujourd’hui, des mesures très précises, effectuées sur des objets et dans des gammes d’énergies très variés, confirment toutes le Modèle standard.

Malgré ses succès, le Modèle standard ne manque pas d’imperfections : un grand nombre de paramètres libres, certaines structures totalement inexpliquées, et surtout une insuffisance ontologique. On sait bien décrire les particules et leur comportement, on sait mal ce qui fait qu’une particule est une particule. Pourquoi, à tel endroit, à tel instant, une concentration d’énergie nous apparaît-elle comme une particule dotée d’une masse, d’une charge, ou d’un tout petit nombre d’autres caractéristiques ?

Ces insuffisances de principe donnaient lieu depuis longtemps à d’intenses spéculations sur de nouveaux modèles théoriques, associés à de nombreuses recherches de signes expérimentaux. Mais la surprise des dernières années est venue des mesures cosmologiques : 95 % de la densité d’énergie de l’univers est de nature inconnue, différente de la matière « ordinaire » que décrit le Modèle standard ! Un tiers environ est sans doute d’une nature « proche », et pourrait être décrite par certaines extensions du Modèle déjà envisagées. Mais le reste, soit plus des deux tiers du contenu énergétique de l’univers, échappe encore aujourd’hui à toute description microscopique.

Entre ces questions, anciennes et nouvelles, on distingue aujourd’hui un réseau de liens qui touchent aux aspects les plus fondamentaux de notre perception du monde : gravitation, symétries, nature de l’espace-temps…

L’élaboration du Modèle standard

La notion d’un Modèle standard, décrivant toutes les particules et les interactions de façon cohérente, n’apparaît qu’à la fin des années 1970. Mais les fondements du modèle remontent directement à la période magique de l’aube du vingtième siècle qui, en moins de dix ans, voit l’apparition des théories de la mécanique quantique et de la relativité, et les découvertes de l’électron, du noyau atomique et de la radioactivité. À ce moment, la théorie quantique décrit l’étonnant comportement microscopique des particules, et la relativité (restreinte) admet le temps comme 4e dimension, contraignant la forme des interactions (interdisant par exemple l’interaction instantanée à distance, comme celle de Newton), et montrant l’équivalence entre masse et énergie.

Il reste à marier ces deux concepts : c’est Dirac, en 1928, qui écrit la première théorie quantique relativiste de l’électron. Ce pas est essentiel pour comprendre la puissance de description des modèles actuels. Grâce aux effets quantiques et aux relations d’incertitudes, il est possible d’échapper à la conservation de l’énergie pour une quantité ΔE, à condition que ce soit pour un temps Δt d’autant plus court que ΔE est grand : le produit ΔE x Δt doit rester inférieur à h/4π, où h est la constante de Planck. La petitesse de h assure que le monde à l’échelle humaine est « classique », avec une énergie conservée et un comportement raisonnable. À l’échelle des particules, cette fenêtre quantique ouvre des horizons immenses : avec la relativité, la masse au repos d’une particule, m, est équivalente à une énergie mc2. Il devient donc possible d’envisager que, pendant un temps Δt, on ait une fluctuation d’énergie ΔE, qui s’exprime sous la forme d’une particule de masse m = ΔE/c2. On parle alors de particule virtuelle. Quelle particule ? N’importe laquelle, à choisir dans toutes les particules « existantes », connues ou inconnues !

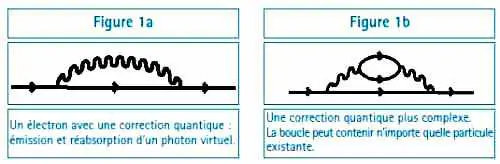

La figure 1 montre, dans la description en diagrammes introduite bien plus tard par Feynman (vers 1960), la représentation d’un électron « habillé » par des corrections quantiques relativistes. La première prédiction de la théorie de Dirac est l’existence d’une antiparticule pour l’électron, le positon ; il sera découvert en 1933 par Anderson. Le vide lui-même prend un statut de premier plan : le vide classique est… vide. Le vide quantique relativiste contient virtuellement toute la physique existante à toutes les échelles d’énergie ou de distance ! La théorie quantique relativiste des électrons et des photons, l’électrodynamique quantique, s’élabore depuis les années 1930 jusqu’aux années 1970. La symbolisation des calculs en diagrammes, par Feynman, en rend la pratique aisée et accessible à (presque) tous.

Il y a cependant un écueil de taille : la multiplication des possibilités virtuelles conduit le plus souvent à des résultats de calculs… infinis ! Dans l’exemple de la figure 1a, la sommation (l’intégration) sur toutes les énergies possibles du photon virtuel donnerait ainsi une masse infinie à l’électron de départ.

Le problème n’est pas vraiment nouveau : il était déjà présent en électrodynamique classique, lorsqu’on se posait la question par exemple de la cohérence de l’électron : si on décrit un électron comme une boule uniformément chargée, pourquoi les parties de cette boule ne se repoussent-elles pas ? De façon assez surprenante, la théorie quantique, bien qu’elle autorise des effets virtuels infinis et complexes, apporte la solution, car elle permet de hiérarchiser l’importance des corrections virtuelles, et d’en préciser les effets. Ces calculs sont au début un artifice mathématique quelque peu hésitant, mais se trouvent confirmés de façon éclatante par les mesures de déplacement des niveaux atomiques dus à la polarisation du vide (effet Lamb). Dans les années 1950–1970, cette approche devient un processus étayé et central dans le modèle : la « renormalisation ». Aujourd’hui la mesure la plus précise dans ce domaine (le moment magnétique anormal du muon) montre un accord avec la théorie avec une précision impressionnante de 11 décimales.

Forte de ses succès, l’électrodynamique quantique est de ce fait devenue le modèle à suivre pour toute théorie : quantique, relativiste et « renormalisable ».

Au cours du XXe siècle sont mises en évidence, puis étudiées, deux autres interactions entre particules : les interactions faibles, responsables d’une forme de radioactivité (et primordiales dans le processus de combustion du Soleil !), et les interactions fortes, qui assurent la cohésion des noyaux (s’ils n’étaient soumis qu’à la seule interaction électromagnétique, les protons de même charge tendraient à se séparer, et les neutrons ne joueraient aucun rôle). En 1965, on en est là : l’interaction électromagnétique a sa théorie puissante, cohérente et prédictive. L’interaction faible a été étudiée en détail par de nombreuses mesures de précision, soit dans les désintégrations radioactives, ou auprès d’accélérateurs, et elle est décrite par un modèle assez élégant, prédictif, mais dont on sait la validité limitée aux basses énergies. L’interaction forte, quant à elle, connaît une foule de résultats expérimentaux, les réactions obtenues en envoyant un faisceau d’accélérateur sur une cible produisant quantités de « nouvelles particules » de masses et de propriétés diverses ; les modèles qui tentent de décrire cette variété sont phénoménologiques, peu prédictifs, parfois même un peu étonnants sur le plan logique (l’un d’entre eux s’appelle le boot-strap, faisant référence à l’idée qu’on pourrait s’élever en se tirant par les lacets de ses propres bottes !).

Le progrès décisif est alors de rechercher l’ingrédient qui permet le fonctionnement de la théorie électromagnétique, et de l’appliquer aux deux autres, malgré les apparentes différences. Cet ingrédient, c’est la « symétrie de jauge ». Depuis le début, le rôle des symétries est essentiel dans notre compréhension théorique. Par exemple, il est clair que les lois de la physique doivent être invariantes par un changement de repère dans l’espace ou le temps : cette invariance conduit à la relativité restreinte. De nombreuses autres symétries sont utilisées pour contraindre les lois physiques : invariance par rotation, invariance (ou pas !) par renversement du sens du temps, par échange de constituants, etc.

L’invariance de jauge est une invariance par rapport à l’identité des particules : si un électron accompagné d’un photon se manifeste dans mon détecteur exactement comme un électron seul, pourquoi ne l’appellerais-je pas un électron ? On voit le lien avec la renormalisabilité : les photons virtuels qui accompagnaient mon électron risquaient de devenir trop nombreux et rendre mes calculs infinis. Mais si c’est « tout cela » un électron, plus de problème !

Appliquer l’invariance de jauge à la théorie faible, et l’unifier avec l’interaction électromagnétique, ne peut pas se faire si facilement : la portée de l’interaction électromagnétique est infinie (c’est le potentiel de Coulomb, en 1/r), celle de l’interaction faible est courte (très inférieure à la taille d’un proton). Dans la théorie, ceci s’exprime par le fait que la particule médiatrice de l’interaction électromagnétique (le photon) possède une masse nulle, alors que celles médiatrices des interactions faibles (les W+, W- et Z0) ont une masse très élevée.

En 1967, Weinberg et Salam, utilisant un résultat de Higgs, réalisent pourtant cette unification. Le modèle part d’une théorie commune où toutes les masses des particules sont nulles. On introduit alors une particule très spéciale, le « boson de Higgs », dont la simple présence donne une masse à toutes les particules du modèle… sauf au photon.

La fameuse symétrie « de jauge » est donc brisée, mais d’une façon assez « douce » pour que ses propriétés soient conservées. En 1974, t’Hooft montre en effet que ce type de théorie est renormalisable.

À peu près en même temps, les expériences tendent à montrer que les protons et neutrons seraient constitués d’objets plus petits. Rapidement, on explique toutes les particules produites par interaction forte à l’aide d’un petit nombre de constituants, les quarks. Mais là aussi, le pas décisif est de comprendre que les quarks et leur interaction forte peuvent être décrits par une théorie « de jauge », la chromodynamique quantique (QCD).

Vers la fin des années soixante-dix, le Modèle standard est enfin constitué, et sa conception ne changera pas jusqu’à nos jours, malgré des mises à l’épreuve expérimentales et théoriques aussi variées que précises. Seule la gravitation échappe à cette description, car si nous en avons une excellente description classique (la relativité générale d’Einstein), nous n’en connaissons pas de théorie quantique.

Les progrès expérimentaux et le Modèle standard aujourd’hui

Pendant la première moitié du XXe siècle, les phénomènes corpusculaires sont d’abord observés à partir de sources naturelles, radioactivité et rayons cosmiques, et des minuscules accélérateurs d’électrons que sont les tubes cathodiques. À partir de la Deuxième Guerre mondiale se développent les véritables accélérateurs de particules, de dimensions et d’énergie toujours croissantes. En effet, la mécanique quantique nous indique que l’impulsion transférée par une particule sonde est inversement proportionnelle à la précision spatiale qu’elle permet d’atteindre.

FIGURE 2

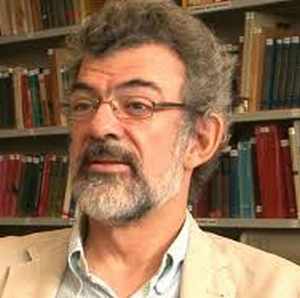

L’empreinte au sol du tunnel du LEP au Cern (on aperçoit au second plan le lac Léman et, en arrière-plan, le Mont-Blanc). Le tunnel lui-même est situé 100 m sous terre.

Des laboratoires sont créés pour abriter spécifiquement ces grands instruments, comme le CERN, fondé en 1954 près de Genève par l’ensemble des pays européens, DESY à Hambourg, Fermilab et SLAC aux USA, etc. À titre d’exemple, le premier « gros » accélérateur construit au Cern en 1960 avait un diamètre de 72 m. Plusieurs générations de machines plus tard, le LEP a fonctionné de 1989 à 2000 dans un tunnel de 9 km de diamètre situé à 100 m sous la campagne genevoise. Ce tunnel s’apprête maintenant à recevoir le futur fleuron du Cern, le LHC, dont le démarrage est prévu en 2007.

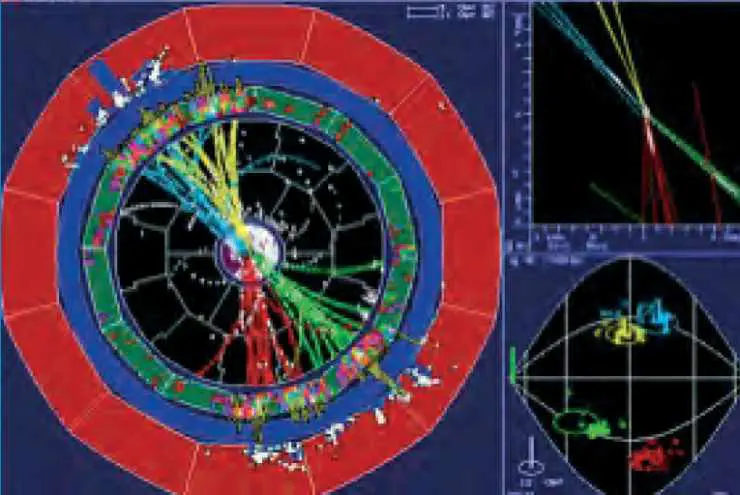

Les expériences ont aussi énormément augmenté en taille, en complexité, et en durée : une expérience auprès du LHC sera un complexe de 40 m de long, 30 m de diamètre, comprenant des millions de canaux électroniques, mis au point par une collaboration de plus d’un millier de physiciens et d’ingénieurs provenant de tous les pays développés de la planète. Les expériences (il y en aura 4) seront probablement exploitées durant plus de quinze ans.

En parallèle, d’autres méthodes de recherche ont été poursuivies, comme l’observation des rayons cosmiques, en plein renouveau actuellement, ou certaines observations astronomiques.

Durant les trente dernières années, le Modèle standard a acquis une étonnante solidité par un va-et-vient incessant entre prédictions théoriques et résultats expérimentaux, impossibles à détailler ici, mais que le lecteur peut apprécier de façon concise (et très réductrice !) par ce chiffre : 12 prix Nobel pour la discipline depuis 1976 !

| Tableau 1 | |||

| Nom et Type d’interaction | 3 familles | ||

| Quarks (interactions Forte et Electro-faible) |

u | c | t |

| d | s | b | |

| Leptons (interactions Electro-faible |

e | μ | τ |

| νe | νμ | ντ | |

Le tableau 1 rassemble les particules élémentaires de matière connues. Il comporte trois colonnes, couramment appelées « familles » : la première famille comprend les particules qu’on trouve autour de nous : deux quarks (u et d), qui constituent les protons et les neutrons dans le noyau des atomes, un électron, et un neutrino dit « électronique », pour exprimer sa parenté avec l’électron. Les deuxième et troisième familles sont des répliques de la première, contenant des particules observées dans des réactions de plus haute énergie, naturelles (rayons cosmiques) ou artificielles (accélérateurs), dont les propriétés sont identiques à leurs sœurs de la première colonne, si ce n’est leur masse plus élevée.

Toute particule possède son antiparticule, de même masse, mais avec toutes les « charges » opposées ; par exemple le positon, antiparticule de l’électron, de charge électrique + e.

Les différentes « lignes » du tableau décrivent simplement quelles particules sont soumises à quelle(s) interaction(s) fondamentales : les neutrinos ne connaissent que l’interaction faible, l’électron (et ses partenaires μ, τ ) est soumis aux interactions faible et électromagnétique, cependant que les quarks ressentent les trois interactions faible, électromagnétique et forte. Comme on l’a vu, les interactions électromagnétiques et faibles sont considérées aujourd’hui comme deux aspects d’une même interaction électrofaible.

Toutes les particules de ce tableau ont maintenant été observées expérimentalement. Mais la cohérence du modèle est telle que plusieurs d’entre elles avaient été prédites à partir de la théorie et de mesures indirectes, bien avant leur observation directe.

Pour compléter le paysage, il faut ajouter deux remarques :

- la présence de trois « familles » est absolument inexpliquée. Mais on sait qu’elle est à l’origine d’un phénomène très important d’asymétrie entre matière et antimatière ;

- les neutrinos ont une masse très faible, si faible qu’on la supposait nulle. Des mesures récentes, hors accélérateur, ont démontré que ces masses sont certes faibles, mais différentes de zéro. Cela ouvre de nouvelles possibilités d’étude et de mise en cause du modèle, ainsi qu’un nouvel éclairage sur l’asymétrie matière antimatière.

Comme je l’ai dit plus haut, le fameux « boson de Higgs » n’entre pas dans la liste des particules de matière, ni dans la liste des messagers des interactions fondamentales. C’est aussi à ce jour la seule particule du Modèle standard non observée, malgré les efforts des expérimentateurs. Le lecteur attentif de La Jaune et la Rouge se souvient peut-être de la polémique suscitée par l’arrêt de l’accélérateur LEP du Cern, en 2000, alors qu’une des quatre grandes expériences annonçait avoir vu les premières indications de l’existence d’un Higgs (figure 3). Depuis, la probabilité que ce « signal » soit en fait dû à du « bruit de fond » a été réévaluée à une valeur de 8 %, bien trop élevée pour prétendre une découverte (on exige en général une probabilité inférieure à 1 pour 10 000 pour prendre en considération une revendication de découverte).

La recherche du Higgs reste donc le tout premier but des physiciens, et c’est essentiellement ce qui a justifié la construction du LHC. En effet ces calculs, et les simulations effectuées pour la conception des expériences au LHC, laissent penser que ces dernières pourront découvrir cette clé de voûte du modèle quelle que soit sa masse. Le LHC, installé au Cern dans le tunnel de 27 km, produira des collisions entre deux faisceaux de protons de chacun 7 000 GeV d’énergie, soit 7 fois plus que l’accélérateur actuel du même type (Fermilab, USA), et avec des intensités de faisceau 100 fois supérieures. La conception de l’accélérateur et des expériences a nécessité des développements technologiques très importants : aimants supraconducteurs, détecteurs ultrarapides, électroniques rapides, puissantes et bon marché, traitement de quantités colossales de données. Tout le programme est actuellement en pleine construction, pour une mise en service prévue en 2007.

Au-delà du Modèle standard

Malgré son incroyable puissance prédictive pour le monde des particules, le Modèle standard est loin d’être satisfaisant. En premier lieu, parce qu’il contient encore beaucoup de paramètres inexpliqués. Les trois familles de chacune 4 particules, associées à 27 paramètres libres (dont toutes les masses des particules de matière), font quelque peu ressembler le Modèle standard à la table de Mendeleïev avant la découverte de la structure atomique. Par ailleurs, certains aspects techniques manquent de cohérence, en particulier en ce qui concerne la nature spéciale du Higgs.

FIGURE 3

Un des événements enregistrés par une expérience à LEP, et reconstruit par informatique.

Les faisceaux d’électrons et de positons sont perpendiculaires à la figure et se croisent au centre du détecteur. Les traces colorées représentent les particules issues de la collision e+ – e-.

Enfin et surtout, nous commençons à aborder le domaine qui relie les particules élémentaires à l’univers dans son ensemble. Les mystères sont alors nombreux car nous n’avons pas encore aujourd’hui de théorie quantique de la gravitation. Les mesures cosmologiques nous indiquent qu’environ 70 % de la densité d’énergie de l’univers (son contenu, au sens le plus général du terme) sont sous une forme inconnue et incomprise, qui s’apparente à une constante cosmologique, énergie répulsive du vide qu’avait introduite Einstein pour tenter de rendre l’univers statique. Les tentatives d’explication de cette forme à partir de la physique du Modèle standard se heurtent à une incompatibilité numérique de plus de 100 ordres de grandeur, une indication très claire qu’un élément essentiel nous manque. Pour le reste, 26 % seraient constitués d’une matière de type encore inconnu, mais que l’on peut modéliser et comprendre dans des extensions assez naturelles du Modèle standard.

De fait la confrontation microscopique/univers entier est rude : le Modèle standard dont nous sommes si fiers ne s’applique qu’à 4 % du contenu de l’univers !

Pour dépasser le Modèle standard, et résoudre tout ou partie de ces problèmes, plusieurs théories sont envisagées, basées sur des changements de principes physiques hardis, voire radicaux. La théorie la plus populaire chez les chercheurs, la supersymétrie, postule l’existence d’un monde de particules entièrement nouveau, reflet de nos particules connues. La plus légère d’entre elles pourrait constituer les 26 % de matière « non conventionnelle ».

Des expériences hors accélérateurs sont actuellement en cours pour rechercher directement cette « matière noire », et pourraient dès les prochaines années tester l’hypothèse de la supersymétrie. Les accélérateurs de haute énergie actuels et futurs recherchent tout aussi activement des signes de cette nouvelle physique.

Une autre possibilité, apparue récemment, évoque l’existence de dimensions supplémentaires de l’espace-temps (en plus des 4 habituelles), accessibles dès l’énergie du LHC. On verrait ainsi des particules produites dans les collisions, disparaître dans une 5e ou 6è dimension !

Conclusion

La recherche de « l’élémentaire » est un sujet en pleine forme. L’approche du démarrage de LHC, les rapprochements avec la cosmologie, les nouvelles perspectives dans le domaine des neutrinos nous promettent une décennie riche de découvertes expérimentales et d’avancées intellectuelles. Si le but de cette recherche est avant tout l’accroissement des connaissances, les développements technologiques qui l’accompagnent (dont le plus retentissant est l’invention du Web au Cern) sont aussi un apport immédiat à la société.