La police judiciaire à l’épreuve de la donnée massive

Moore a rendez-vous avec Locard

Avec la révolution numérique, la quantité de preuves potentielles disponibles dans les enquêtes judiciaires a connu une croissance vertigineuse. Les délinquants ont investi le cyberespace et les besoins des enquêteurs ont changé. Data scientists et enquêteurs collaborent pour traiter au mieux cette masse de données au potentiel inédit, dans un cadre juridique particulièrement sensible.

Le contenu de l’article n’exprime que le point de vue de l’auteur et n’engage pas la gendarmerie.

Les forces de sécurité ont maintenant bien pris la mesure de la menace que représente la cybercriminalité (atteintes aux systèmes de traitement automatisé de données ou STAD, piratages, etc.) avec pour la gendarmerie la création à l’été 2021 du ComCyberGend, regroupant sous une même bannière toutes les activités de l’institution dans ce domaine, de la prévention à l’identification des auteurs en passant par la recherche de la preuve numérique. Elles continuent leur adaptation à l’irruption du numérique dans la délinquance de tous les jours, alors même que la croissance vertigineuse du volume des preuves numériques potentielles exige une modification profonde de la manière d’appréhender, de trier et d’exploiter cette donnée massive.

Déjà trente ans d’analyse criminelle

La problématique du traitement de la donnée judiciaire de masse n’est pas tout à fait nouvelle. En 2017, le logiciel Analyst Notebook a connu une renommée éphémère en permettant une avancée significative dans le cold case peut-être le plus célèbre de France, l’affaire Grégory. Ce logiciel, fourni par IBM, est utilisé depuis les années 1990 par des gendarmes spécialement formés, appelés analystes criminels ou « Anacrim », pour le traitement des affaires les plus complexes. Ces spécialistes transforment notamment le contenu des procédures en base de données puis en graphe, ce qui permet d’avoir une vision d’ensemble de dossiers qui représentent des milliers de pièces de procédure et de mettre en évidence incohérences et connexions.

Aujourd’hui la donnée massive est partout. Le problème de son traitement n’est donc plus limité aux dossiers les plus graves, mais est devenu un problème quotidien des enquêteurs, même pour des faits de faible intensité, auxquels la gendarmerie ne peut pas se permettre de consacrer autant de temps. Il y a encore vingt ans, analyser le contenu d’un Nokia 3310 pouvait se faire à la main en quelques minutes. Aujourd’hui, le dernier iPhone offre un téraoctet de stockage. Le problème n’est pas tout à fait le même non plus : dans un dossier complexe, les Anacrim intègrent toute la donnée disponible, dans le but de mettre en évidence des preuves qui résident dans l’assemblage des pièces de procédure plutôt que dans ces pièces prises individuellement.

Dans un dossier classique, la logique qui prévaut est celle de l’efficacité : il s’agit de trouver l’aiguille qui intéresse le dossier dans la botte de foin que représente la donnée disponible, sans pouvoir y consacrer trop de temps.

Edmond Locard, fondateur du premier laboratoire de police scientifique

Il y a tout juste un siècle, le Français Edmond Locard déclarait que « nul ne peut agir avec l’intensité que suppose l’action criminelle sans laisser des marques multiples de son passage ». Partant de ce principe, il crée le premier laboratoire de criminalistique pour formaliser l’étude des traces et indices retrouvés sur les scènes de crime. Si Locard n’a sans doute pas pu imaginer l’avènement exceptionnel du numérique, son principe en devient encore plus vrai aujourd’hui. À l’heure où l’évolution exponentielle des capacités des ordinateurs valide le postulat de Moore, où la création mondiale de données se mesure en zettaoctets et où le délinquant a dans sa poche le dernier iPhone, la trace numérique est partout. Mais, et heureusement, la durée légale de la garde à vue n’a pas suivi la même courbe et les enquêteurs se retrouvent à devoir analyser des volumes de données toujours plus importants dans des délais toujours aussi restreints.

De la donnée à la preuve

Techniquement, il est relativement aisé de fournir aux gendarmes un outil permettant de rechercher des données qui constituent en elles-mêmes la preuve d’une infraction. Par exemple, les forces de police disposent depuis de nombreuses années d’outils permettant la recherche d’images à caractère pédopornographique, dont la détention est à elle seule une infraction. Il est beaucoup plus complexe de rechercher des indices qui ne deviennent des preuves qu’une fois mis en relation avec d’autres éléments du dossier : une position géographique incriminante, un historique Internet suspect, une photo contredisant le contenu d’une audition…

Ces recherches nécessitent donc à la fois des compétences techniques, permettant d’automatiser les recherches, et une connaissance aussi poussée que possible du dossier, pour savoir quoi rechercher et estimer la force probante des résultats. Les agents disposant de cette double compétence, technique et judiciaire, sont aujourd’hui trop rares, pour un cas d’usage qui est déjà quotidien et qui sera de plus en plus fréquent.

Des marges d’amélioration

De plus, bien que la spécialité Anacrim existe depuis longtemps, celle-ci ne fait encore qu’un usage limité des possibilités offertes par la technologie. En effet, si ces enquêteurs sont indissociables du logiciel Analyst Notebook, ce dernier sert principalement sinon exclusivement à la transformation d’une base de données relationnelle en graphe permettant d’avoir une représentation visuelle d’un dossier.

La base en elle-même est aujourd’hui encore très largement renseignée manuellement à partir des pièces du dossier, tâche chronophage s’il en est. Une fois le graphe constitué, son analyse relève là aussi purement de l’intelligence humaine, l’analyste manipulant visuellement le graphe pour faire ressortir les éléments d’intérêt. Les Anacrim d’aujourd’hui sont donc davantage des enquêteurs que des data scientists.

“Il est complexe de rechercher des indices qui ne deviennent des preuves qu’une fois mis en relation avec d’autres éléments.”

Mais leur travail consiste principalement à faire parler de la donnée massive et pourrait bénéficier des avancées en ce domaine. Des recherches sont par exemple en cours pour automatiser autant que possible la phase de constitution de la base de données, en appliquant des méthodes d’extraction automatique d’éléments et de relations. La partie analyse peut elle aussi bénéficier aujourd’hui des algorithmes d’analyse de graphe, en particulier sur les dossiers s’attaquant à des réseaux criminels importants et organisés.

Prendre un peu de recul

La révolution numérique n’a pas fait que multiplier les données à analyser, elle a aussi fait exploser le nombre de délits, d’auteurs et de victimes. Depuis 2018, l’infraction de harcèlement peut être retenue pour chaque personne ayant posté même un seul commentaire haineux sous une publication Facebook, ce qui implique des faits avec des centaines voire des milliers d’auteurs. Aujourd’hui, un escroc peut acheter pour quelques euros sur le darknet une base contenant des millions d’adresses e‑mail et commettre ensuite en un clic autant de tentatives d’escroquerie.

Face à ce raz-de-marée d’infractions et de victimes potentielles, la façon de faire historique – chaque victime dépose plainte dans le commissariat ou la brigade de gendarmerie, qui mènera ensuite l’enquête sur ce fait individuel – ne tient plus la charge. Les pouvoirs publics commencent ainsi à déployer depuis quelques années différentes plateformes pour permettre le signalement de ces faits commis en masse sur Internet, comme Perceval pour les utilisations frauduleuses de données bancaires ou Thésée pour les escroqueries.

Au-delà du gain de temps pour l’usager – plus besoin de se rendre physiquement en brigade ou en commissariat – l’utilité de ces plateformes réside surtout dans la constitution de bases de données au niveau national, sur lesquelles il est ensuite établi automatiquement des recoupements entre infractions similaires, afin d’orienter ensuite les procédures de façon groupée vers un unique service d’enquête.

Lire aussi : La transformation numérique de l’innovation de la Gendarmerie nationale

L’angle de la donnée massive

Si ces plateformes ne traitent aujourd’hui que des infractions relevant du numérique, tout le spectre des infractions de basse intensité commises de façon sérielle – vols à l’étalage, détournements de chèque… – pourrait bénéficier d’une approche sous l’angle de la donnée massive. Il est difficile aujourd’hui de lutter contre ce type de faits, car imputer un fait unique à un auteur ne suffit pas pour obtenir une réponse pénale dissuasive.

Le travail de l’enquêteur réside alors principalement dans la science du « recoupement », qui consiste à identifier dans d’autres unités des procédures d’intérêt et à démontrer que celles-ci sont relatives à des faits ayant vraisemblablement été commis par le même auteur. Déjà difficile en soi, la tâche se complique encore si l’on veut s’attaquer non pas à un individu, mais à un réseau, avec des équipes à la composition variable. Ici aussi, des algorithmes pourraient contribuer à effectuer ce recoupement, sous réserve que la donnée relative aux enquêtes soit disponible de façon centralisée.

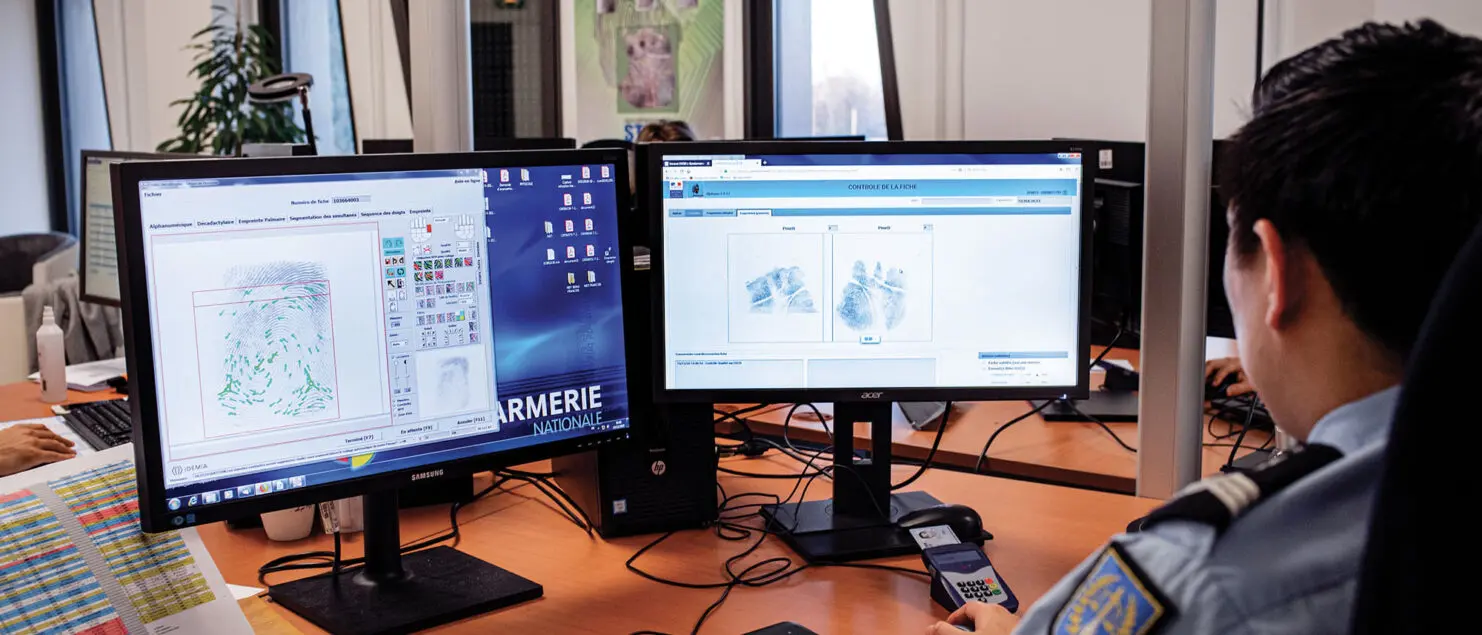

du pôle judiciaire de la Gendarmerie nationale (PJGN), à Pontoise.

Le retour d’un arbitrage historique

Aujourd’hui en effet, la technologie est mûre, mais le principal blocage est juridique. L’utilisation des données judiciaires est légitimement très encadrée par le législateur, qui limite par exemple fortement les croisements de données entre procédures. Le principal enjeu est celui de l’éthique des algorithmes. Sans aller jusqu’aux dystopies hollywoodiennes, les problématiques de discrimination liées à l’IA sont bien réelles et revêtent une importance toute particulière dans le domaine du judiciaire. Utiliser des algorithmes dans ce domaine nécessitera de s’assurer de leur valeur éthique, et surtout de pouvoir en apporter la preuve, sans doute via des audits externes.

La notion d’explicabilité des algorithmes est également fondamentale. Dans un procès pénal, la procédure rédigée par l’enquêteur s’apparente à une démonstration, qui doit être comprise et vérifiée par les juges ou le jury. Dans ce contexte, faire appel à un algorithme pour franchir une étape de la démonstration pose question et nécessiterait vraisemblablement au moins de rendre public son code – ce qui entraîne de nouvelles questions : dans le cadre d’un algorithme de machine learning, les données d’entraînement sont au moins aussi importantes que le code en lui-même et devraient donc logiquement être également publiées, avec les difficultés que cela implique au vu de la sensibilité des données en question…

Ne pas prendre de retard

Ces questions juridiques seront au cœur des discussions des prochaines années, car le secteur public a pris conscience du potentiel de la donnée dont il dispose et poussera pour faire évoluer la législation afin de permettre la valorisation de cette donnée. L’éternelle question de l’arbitrage entre les moyens donnés aux forces de l’ordre et la préservation des libertés fondamentales est transposée aujourd’hui sur le terrain de l’IA. Mais, au rythme des évolutions technologiques, les forces de l’ordre auront toujours un temps de retard sur des délinquants qui, par définition, ne s’embarrassent pas de telles précautions.