Le radar : la théorie, la technique et la technologie

Dimanche matin. La veille de 4 à 7 heures est terminée. Les opérateurs de 5 des 6 radars de la base les ont éteints. Le camion qui doit ramener ceux du sixième aux baraquements est en retard. » L’ancien » n’éteint pas le radar et entreprend de parfaire l’instruction de son camarade novice. Sans doute prend-il du plaisir à jouer encore un peu avec cet appareil fascinant. À 7 h 02, les premiers échos apparaissent sur l’écran à 250 km. Au centre d’information bientôt alerté, tout le personnel a dégagé à 7 heures, mis à part un lieutenant en instruction. Des bombardiers amis sont attendus : il n’y a pas lieu de s’inquiéter. Trois quarts d’heure plus tard, les premières bombes pleuvent sur Pearl Harbor. C’est le 7 décembre 1941.

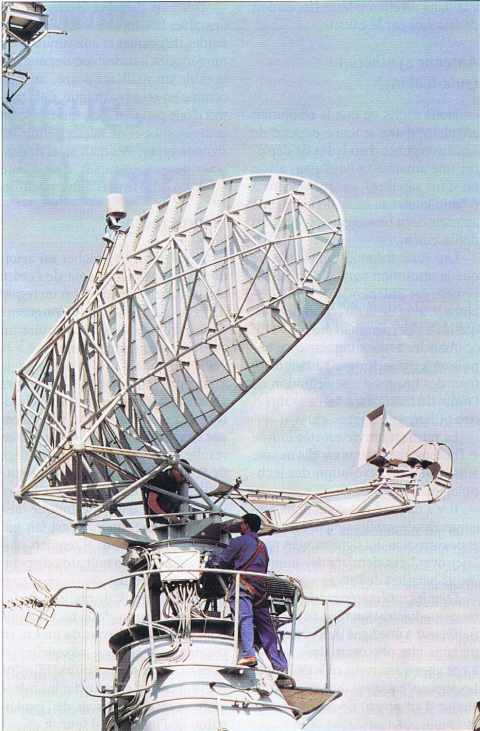

© DCN/MARINE NATIONALE

Radar : RAdio Detection And Ranging. Le nom nous dit l’essentiel. C’est une technique de détection et de mesure (à l’origine Ranging : mesure de distance) par ondes électromagnétiques ou » Radio « . Il est entendu implicitement que c’est une technique » active » : les ondes sont volontairement produites et non spontanément émises par la cible, ce qui relèverait de la radiométrie (technique » passive »).

Les ondes radio ont des applications multiples et bien connues. Toutes ont un point commun : elles servent à transporter sans fil de l’information. Celle-ci est caractérisée par son spectre de fréquences du téléphone (300 à 3 000 Hz) à la musique » Hi-Fi » (15 à 20 000 Hz), la télévision (quelques MHz) jusqu’au radar (quelques dizaines de kHz à quelques centaines de MHz). Cette information modifie (on dit : module) l’onde qui la transporte, qu’on appelle justement onde porteuse, et dont la fréquence est beaucoup plus élevée.

Les débuts

On sait qui a inventé la vaccination ou découvert la pénicilline. Il n’y a pas d’inventeur du radar : dès ses débuts, il est le fruit de la convergence de travaux épars et ses premiers pas furent hésitants. Aujourd’hui, il y a autant de radars que d’applications possibles ; la liste n’est pas close.

Par exemple, un avion entre dans l’espace aérien. Il est détecté, localisé et identifié par un radar de veille lointaine. La chasse décolle : nouvelle détection par le radar situé dans le nez de l’avion et tir d’un missile dont l’autodirecteur (ou » tête chercheuse « , un radar) assure le guidage. L’impact n’aura pas forcément lieu mais, déclenchée par la fusée de proximité (encore un radar), la charge militaire explosera à quelques mètres de l’intrus. Quatre radars, hautement spécialisés, donc très différents, pour mener à sa fin ce scénario somme toute assez simple.

Il n’est donc pas possible de décrire ici toutes les réalisations ni même de faire une histoire du radar. Nous allons plutôt ouvrir ensemble un album de famille, une famille extraordinairement métissée, avec des instantanés classés dans un ordre à peu près chronologique, touchant à des sujets multiples et que nous commenterons à mesure. Nous verrons ainsi comment ont grandi les trois branches : la théorie, la technique et la technologie.

Les premières expérimentations sur les ondes électromagnétiques furent menées par Hertz (1886) vérifiant ainsi les théories de Maxwell (1868). Ses expériences mettaient en œuvre des ondes assez courtes (λ = 66 cm, soit f = c/λ = 3.108/0.66 = 150 MHz).

Dans un discours célèbre et prémonitoire, s’appuyant sur ses propres travaux, Marconi annonça en 1922 une application potentielle des ondes électromagnétiques qu’il faut bien appeler un radar (le nom, lui, date de 1940). Il ne reçut malheureusement aucun soutien.

Rappelons la technique de base : un émetteur produit une onde électromagnétique qui est rayonnée à l’extérieur par une antenne. Frappant un obstacle, elle est renvoyée par un phénomène assimilé à un écho et recueillie dans une antenne qui alimente un récepteur dans lequel on extrait l’information.

Les premières expériences, fortuites ou systématiques, furent conduites avec des ondes continues, l’émetteur et le récepteur étant séparés ainsi, bien entendu, que leurs antennes. On constatait, dans le récepteur, les interférences entre l’onde directe issue de l’émetteur et celle que renvoie une cible frappée par l’émission. Si la cible est mobile, la variation de ces interférences est une manifestation de l’effet Doppler. Un premier brevet fut déposé en 1904 ; il n’eut pas de suite : la portée (sur navire) dépassait à peine celle de l’observation visuelle !

Les États-Unis partirent les premiers : en 1922 le NRL (Naval Research Laboratory) détecta un navire (l = 5 m) ; les travaux ne furent pas poursuivis. La première détection d’avion eut lieu en 1930 : elle se produisit fortuitement quand un avion traversa le champ d’un goniomètre en cours d’essais. L’étude fut poursuivie sous de faibles encouragements : on atteignit cependant une portée de 90 km en 1932.

On a très vite compris qu’une modulation par impulsions était nécessaire pour mesurer la distance. On l’utilisait dès 1925 dans un but scientifique, l’étude de l’ionosphère. Cependant, dans le domaine du radar, les travaux ne commencèrent qu’en 1934, et encore mollement. Les premiers essais en janvier 1935 se soldèrent par un échec. Aujourd’hui, l’explication nous fait sourire : le récepteur, adapté aux télécommunications de l’époque, était trop sélectif pour recevoir des impulsions dont le spectre de fréquences est large. Autant prétendre observer un arc-en-ciel à travers un filtre monochrome. Correction faite, on obtint en avril 1936 les premiers échos d’avion à 45 km (impulsions de 5 microsecondes modulant un émetteur à 28 MHz soit λ ~ 11 m).

On comprit très vite également l’intérêt d’antennes directives qui permettent à la fois de concentrer l’énergie dans une direction déterminée et d’augmenter la précision et le pouvoir séparateur angulaires. Pour une envergure donnée, il fallait augmenter la fréquence émise : telles sont les lois de la diffraction. Dès juillet 1936 les premières détections eurent lieu avec un radar à 200 MHz (λ = 1,5 m) avec pour la première fois une antenne unique dont un » duplexeur » assurait la commutation entre émission et réception.

De son côté, l’US Army Signal Corps travaillait sur le sujet dans les années trente. Des contacts furent pris avec le NRL en 1936. En 1938, le premier radar opérationnel était disponible (SCR 268, opérationnel jusqu’en 1944). C’est une version longue portée, le SCR 270, que Pearl Harbor a rendu célèbre.

Malgré quelques travaux, particulièrement en France, dans les années trente, l’Europe démarra plus tard. Sans doute aiguillonnés par l’imminence de la guerre, les Anglais firent les progrès les plus rapides et les plus décisifs.

Dès 1935, un an avant l’échec américain, ils avaient expérimenté le radar à impulsion. En quelques années, la fréquence était passée de 6 MHz (1935) à 25 MHz (1936−1937) puis 200 MHz (1939) pour un radar aéroporté. On remarqua à cette occasion qu’il était possible de détecter un navire à partir d’un avion puis, plus tard, de faire de la cartographie dans un but de navigation (pénétration de bombardiers dans de mauvaises conditions).

Des échanges US-GB eurent lieu en 1940. Les Anglais apportaient un formidable cadeau : les plans du magnétron. Jusque-là, les émetteurs fonctionnaient avec des triodes : leur grille de commande module le flux d’un faisceau d’électrons. Recueilli sur la plaque, celui-ci donne lieu à un courant qui, à son tour, excite un circuit résonant ; 200 MHz constituaient un plafond.

Le magnétron, lui, assure un couplage direct entre le faisceau électronique d’une diode et le résonateur (au début un circuit oscillant, puis des cavités creusées à même l’anode). Le tout est placé dans un champ magnétique qui courbe les trajectoires électroniques (1921). Les premières oscillations ont lieu en 1924.

En 1934–1935 l’étude théorique du couplage entre le faisceau et un champ électromagnétique établit la condition de synchronisation nécessaire à l’entretien des oscillations. On améliore les cathodes vers 1937 et en 1939–1941 on aboutit au magnétron à cavités dont on établit simultanément une théorie poussée. Résultat : 1 kW à 3 000 MHz (λ =10 cm) ! Seuls les Anglais et les Américains ont dépassé 600 MHz pendant la guerre.

Le magnétron a depuis fait l’objet de progrès purement technologiques. En termes de rapport puissance/volume (ou poids) on n’a jamais fait mieux ; on l’utilise toujours.

En dehors des échos utiles, un récepteur radar est le siège de nombreux signaux indésirables :

- les échos non souhaités qui ne sont pas toujours les mêmes ; par exemple ceux que l’on reçoit du sol sont nuisibles si l’on cherche un avion à basse altitude et sont intéressants en cartographie ;

- le bruit thermique interne au récepteur (que vous pouvez entendre sur votre poste de radio entre deux stations).

Premières théories du signal radar

Commença alors l’ère des études théoriques propres au radar. En 1943, Norton dégagea la notion de récepteur adapté cruellement mise en défaut en janvier 1935. Pour une forme de signal donné, le récepteur adapté est celui qui assure le meilleur contraste par rapport au bruit thermique. Mais le grand théoricien du radar, c’est Woodward qui, en 1953, aboutit au même résultat avec des considérations très différentes (maximum de probabilité a posteriori).

On montre que le récepteur adapté est rigoureusement équivalent à un corrélateur. Résultat très important car généralement l’une des deux réalisations est quasiment impraticable ou au moins beaucoup plus onéreuse que l’autre. Ce choix technologique dépend du signal émis.

Toute détection est affaire de contraste, et pas seulement dans le domaine du radar. Une panthère noire est tachetée de noir sur fond noir, mais il faut le bon éclairage pour s’en rendre compte.

Précisément, il s’agit toujours d’un contraste énergétique en fonction d’un paramètre donné (la couleur, la hauteur d’un son, etc.) selon lequel un certain pouvoir discriminateur est donc nécessaire.

Les paramètres disponibles pour le radar sont :

- la direction (2 angles) grâce à l’antenne,

- la distance et la vitesse radiale grâce à la forme du signal,

- la polarisation de l’onde.

Tout cela dépend également des caractéristiques de la cible.

Dès que les cibles intéressantes sont mobiles, on essaie de faire appel à l’effet Doppler, qui est un décalage de la fréquence émise. Un avion, indiscernable sur le fond des échos ambiants, pourra être détecté si on élimine les échos dépourvus d’effet Doppler dont on sait qu’ils sont fixes.

À la fin de la guerre, donc, on ne savait facilement émettre qu’une onde continue ou des impulsions périodiques. Évidemment, plus la durée de l’impulsion est courte et meilleure est la résolution en distance.

Eh bien non ! dit Woodward. Ce qui compte, c’est un spectre de fréquences large, certes obtenu par des impulsions fines, mais on peut aussi, par exemple, moduler en fréquence des impulsions larges. On touche ainsi à la notion de compression d’impulsion. Symétriquement, il n’est pas besoin d’une onde continue pour mesurer l’effet Doppler 2V/λ dû à une cible de vitesse radiale V. On peut moduler en impulsions une onde cohérente, c’est-à-dire provenant d’une même onde continue, que l’on découpe en tranches, alors qu’un magnétron démarre n’importe comment chaque fois qu’on le lance. La phase initiale est aléatoire : on dit qu’il n’est pas cohérent.

On peut ainsi alternativement émettre un signal et en guetter les échos. La fréquence à laquelle on effectue cette commutation (à ne pas confondre avec la porteuse) a une importance considérable :

- trop élevée, on ne sait plus si l’écho qu’on vient de recevoir est dû à l’impulsion que l’on vient d’émettre ou à l’une des précédentes,

- trop basse, elle effectue une véritable stroboscopie des fréquences Doppler élevées.

Dans les cas pratiques on rencontre toujours au moins un de ces deux écueils.

Au milieu des années cinquante, Woodward avait à peu près tout dit. Il a fallu une bonne vingtaine d’années pour que la technologie et l’astuce technique permettent d’obtenir des réalisations abouties et relativement bon marché.

Les progrès technologiques

Et d’abord l’exploitation de l’effet Doppler demandait des générateurs d’une bonne pureté spectrale. Les tubes à interaction directe entre une onde et un faisceau électronique firent de gros progrès, toujours en parallèle avec leur étude théorique (Klystron, tubes à onde progressive…).

Le magnétron, lui, n’est pas naturellement cohérent, mais dans les années cinquante on apprit à synchroniser le récepteur sur l’émission, ce qui permet un traitement artificiellement cohérent ; il est alors nécessaire d’attendre tous les échos des cibles possibles (et lointaines) avant de recommencer. D’où une fréquence de récurrence (de répétition) basse. À chaque impulsion émise, les obstacles fixes sont des échos toujours identiques : il suffit (!) d’en soustraire ceux de l’impulsion émise précédente exactement retardés pour les éliminer.

C’est le principe du très célèbre et très efficace MTI (Moving Target Indicator). Avec un gros problème technologique : il n’y a pas de ligne à retard électrique de la durée d’une récurrence (entre deux émissions). On utilise alors un transducteur électroacoustique : le signal acoustique se propage dans un milieu élastique, au début de l’eau, du mercure, puis au milieu des années cinquante, du quartz, siège de réflexions multiples. Après quoi il excite un second transducteur. Vers 1970, tout cela sera remplacé par un échantillonnage à cadence très élevée et un traitement numérique.

Problème théorique aussi. Nous avons mentionné la stroboscopie des signaux affectés de Doppler : en éliminant les échos fixes, on rejette également toutes les fréquences multiples de la fréquence de récurrence. Il a fallu inventer (empiriquement) des solutions, faire les calculs correspondants pour en tirer le maximum et passer à la réalisation.

De même, la compression d’impulsion qui permet d’obtenir un très grand pouvoir séparateur en distance a été mise en œuvre dès 1955.

La technique la plus courante consiste à » étaler » dans le temps une impulsion très fine à l’aide d’une ligne dispersive, un peu comme une fente étroite éclairée par une lumière blanche et parallèle à l’arête d’un prisme donne lieu à une image élargie et dont les couleurs sont séparées dans l’espace.

Les lignes en question ont fait appel à des technologies variées : circuits électriques (bobines et condensateurs), propagation entre deux transducteurs d’une onde acoustique de volume ou de surface, etc. À la réception, la ligne est utilisée en sens inverse.

Une autre technique de compression fait appel au codage numérique de séquences d’impulsions. La théorie des » bons » codes fait appel à l’algèbre dans les corps finis.

Une fois la cible détectée et reconnue, le radar peut être mis » en poursuite » : il entretient lui-même les paramètres de la cible en distance, vitesse, angles et reste automatiquement pointé dessus, ce qui fait appel à la théorie et à la technique des asservissements. Les mesures sont utilisées pour assurer la conduite de tir d’un canon ou le guidage d’un missile par exemple.

Les antennes

© DCN/MARINE NATIONALE

En particulier, la poursuite angulaire a fait appel à des techniques qui ont évolué : au début on effectuait un balayage conique autour de l’axe de visée, puis on imagina les antennes dites » monopulse » qui sont en fait la combinaison compacte de quatre antennes permettant sur un signal unique de mesurer l’erreur de visée (haut-bas, droite-gauche).

Appliquée aux radars de veille, la théorie des antennes permet de modeler efficacement la couverture en site de l’espace à surveiller.

On connaît de longue date les antennes réseaux constituées d’éléments que l’on combine entre eux à l’émission ou à la réception.

À la réception, par exemple, on a commencé par combiner de façon variable tous les signaux élémentaires avant d’alimenter un récepteur unique (balayage électronique).

Les moyens disponibles aujourd’hui permettent de disposer d’un récepteur par antenne élémentaire, puis d’effectuer simultanément de nombreuses combinaisons (autant qu’il y a d’éléments d’antenne) ce qui permet d’obtenir une bonne directivité dans un champ large (formation de faisceau par le calcul).

Antenne synthétique (side-looking)

Nous avons vu que la résolution angulaire d’une antenne dépend de son envergure : d’où l’idée de déplacer une antenne (à bord d’un avion ou d’un satellite), ce qui revient à échantillonner au cours du temps une antenne dont l’envergure est égale au déplacement.

Une étude théorique simple montre que la résolution parallèle au déplacement est indépendante de la distance le long de la direction de visée qui lui est perpendiculaire.

Associée à une compression d’impulsion, cette technique permet d’obtenir des images d’une définition de l’ordre du mètre dans les deux directions (mouvement et visée).

La mise en œuvre est très lourde et l’histoire intéressante car elle montre ainsi l’effet de l’évolution des technologies.

Il y a d’abord des conditions draconiennes de stabilisation de l’antenne et de correction des signaux reçus pour » nettoyer » ces derniers des mouvements parasites de l’avion.

Dans les années soixante, les signaux reçus modulaient un tube cathodique (téléviseur à une ligne !) devant lequel un large film photographique défilait à une vitesse asservie à celle de l’avion. Les signaux passaient du noir au blanc autour d’un niveau de gris lui-même asservi.

Après développement du film selon un processus rigoureux, le traitement du signal était effectué par voie optique dans un corrélateur, véritable banc d’optique comportant des lentilles tronconiques, cylindriques, etc. À la sortie, l’image était enregistrée sur film. Puis on est passé au traitement numérique et transmission des données de l’avion vers le sol. Aujourd’hui, tout le traitement peut être effectué à bord si nécessaire : on obtient une » qualité photo » qui peut permettre un recalage de navigation par exemple, ce qui relève des techniques de traitement d’image. Aujourd’hui, on met à profit le mouvement des satellites.

Touchant de près au radar, l’étude des cibles fait appel aux mesures, aux études théoriques et aux simulations numériques lourdes : on dessine sur la cible un maillage serré, un peu comme en aérodynamique. Cela permet d’une part d’en avoir une meilleure connaissance et de mieux définir les signaux appropriés mais aussi de dessiner des avions furtifs, c’est-à-dire ayant un écho le plus faible possible.

Progrès récents

On ne peut pas cacher un avion dont les dimensions sont de l’ordre de la longueur d’onde. D’où un regain d’intérêt pour les grandes longueurs d’onde qui obligent à construire un radar très encombrant destiné à la veille lointaine. Dans ce domaine, le » monstre » est constitué d’antennes verticales organisées en réseau circulaire de grand diamètre et alimentées par des émissions décorrélées. Il en résulte ce qu’on appelle un » codage de l’espace » dont la totalité est surveillée en permanence, c’est-à-dire sans balayage d’un quelconque faisceau. Tout le traitement est fait par calcul à la réception : il requiert plusieurs dizaines de milliards d’opérations par seconde.

Restent deux domaines où les énormes progrès de la technologie numérique ont permis de mettre en œuvre des techniques auxquelles on pensait depuis longtemps. Elles ne relèvent pas du signal radar lui-même et de sa réception, mais de l’exploitation de l’image qu’il fournit.

Il s’agit d’abord de distinguer la cible dans cette image sur un fond gênant et plus ou moins aléatoire qu’on appelle fouillis (ou » clutter »).

L’autre domaine est celui de la poursuite d’une cible susceptible de manœuvrer. Nous sommes dans les deux cas (bien différents) au royaume du traitement statistique qui suppose la mise à disposition d’un modèle. Il y a donc là encore matière à exploitation systématique de mesures, mise au point de modèles, puis d’algorithmes incluant ces modèles.

Là encore, la puissance du calcul numérique permet en permanence des progrès inespérés dix ans plus tôt, ne fût-ce qu’en employant des algorithmes auxquels on avait renoncé tant ils sont lourds en calcul.

Cependant, les détections ou poursuites les plus archaïques comprenaient déjà des modèles implicites du fouillis et de la manœuvrabilité de la cible.

Pour conclure, on peut dire que le concepteur de radar ressemble un peu à un architecte. Chaque fois qu’un problème lui est posé (une cabane, une cathédrale) il en considère les données, y compris celles du terrain, les désirs du client (qui ne correspondent pas toujours à ses besoins), juge de la meilleure technique, des matériaux les plus adaptés : le choix en est énorme et il ne faut pas se tromper. Il sait pourtant que le jour où ce dont il rêve aujourd’hui sera enfin devenu raisonnable, ses rêves à lui seront encore plus fous.

À propos, on ne sait pas non plus qui a inventé l’architecture !