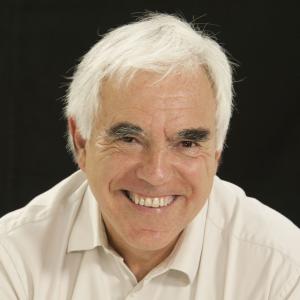

Les algorithmes composent-ils de la musique ?

Les domaines d’application de l’intelligence artificielle sont multiples ; l’image en est un cas frappant, qui rencontre un succès énorme dans le cinéma ; qu’en est-il du son ?

Musique et algorithmes, n’est-ce pas une vieille histoire ?

Il y a eu beaucoup de machines et d’algorithmes dans la musique bien avant l’arrivée de l’informatique, puis de l’intelligence artificielle. Depuis les débuts avec Thomas Edison et Thaddeus Cahill au tournant du XXe siècle aux États-Unis, faire de la musique avec l’électricité et de l’électronique analogique a été une grande aventure, merveilleusement racontée par Laurent de Wilde dans Les fous du son (Grasset, 2016). On y a beaucoup expérimenté, d’abord avec des méthodes physiques classiques. Puis le paysage a totalement changé avec les travaux d’un Roger Shepard aux Bell Labs dans les années 1960, qui a mis en place la représentation informatique du son par des suites de nombres, ce qui donne tout pouvoir sur sa création.

La musique numérique était née.

L’IA a énormément progressé ces dernières années dans le domaine de l’image et de la vision, avec les travaux de Yann Le Cun et d’autres sur les algorithmes d’apprentissage profond. Aura-t-on la même chose pour le son et la musique ?

Schématiquement, pour faire de la musique (électrique, électronique ou informatique…), il faut travailler en mode temporel : c’est une grande différence entre le son et l’image. Pour la vision, l’œil est un capteur fin mais partiel : nous ne voyons avec une bonne résolution que dans un cône de 6 degrés d’ouverture et nous ne voyons les couleurs que dans un angle de 60°. Ce sont les incessants mouvements de l’œil, associés aux algorithmes de traitement de l’information dans le cerveau, qui nous font croire que notre image est large, toute en couleurs et stable (voir là-dessus l’excellent séminaire donné par Botond Roska au Collège de France). En bref, on se fait beaucoup d’illusions sur ce que veut dire réellement « voir ». C’est quelque chose que connaissent bien les magiciens, passés maîtres dans l’art de tromper notre perception visuelle.

« Il y a eu beaucoup de machines et d’algorithmes dans la musique bien avant l’arrivée de l’informatique, puis de l’intelligence artificielle. »

Et, donc, que se passe-t-il pour le son ?

Pour le son, c’est tout différent : l’oreille est un instrument d’une précision et d’une finesse hallucinantes. Mais, autant on comprend les processus mécaniques de captation du son par l’oreille interne, autant on ignore largement ce qui se passe dans le cerveau pour la formation de la perception sonore. Au passage, noter qu’on est en présence d’un bel exemple de relation d’incertitude de Heisenberg entre temps et fréquence, qu’on ne peut pas maîtriser en même temps ! (voir à ce sujet) La musique se déroule dans le temps, ce qui est très différent de la vision, qui se déroule dans l’espace : quand on regarde un tableau, votre œil ne cesse de le parcourir en tous sens pour que votre cerveau en reconstitue une image globale fixe. L’oreille ne peut évidemment pas faire la même chose pour un morceau de musique, qui se déroule sans possibilité pour elle de s’arrêter ni de le parcourir. Il y a aussi une forte influence de la culture dans notre perception du son. Il suffit de voir combien sont différentes la musique occidentale et la musique indienne, par exemple, qui est monophonique mais qui fait des rythmes et des hauteurs de son un usage très différent et extrêmement raffiné.

Que font aujourd’hui les algorithmes en musique ?

Les algorithmes sont arrivés en fait avec les travaux de Fourier. Comme je le disais au début de notre entretien, on a d’abord utilisé des algorithmes analogiques, électriques ou électroniques. La restriction systématique à des nombres par Shepard a été une nouveauté fondamentale. Avec le numérique, on pouvait ne plus se contenter d’oscillateurs analogiques simples : on pouvait enfin vraiment créer des sons arbitraires. Ce fut l’intuition de départ de Pierre Boulez avec son GRM. Les débuts furent difficiles : il n’y avait pas vraiment d’ordinateurs pour travailler, d’où le développement de la machine 4X pour le traitement numérique du signal, et la composition d’Anthèmes 2 par exemple. Mais le grand regret de Boulez était que le temps de la machine s’imposait à celui des instrumentistes. J’ai intégré le conseil scientifique de l’Ircam dans les années 2010, au moment où Arshia Cont concevait le logiciel d’accompagnement automatique Antescofo, bâti sur l’idée inverse que l’électronique doit être finement dirigée en temps réel par les hommes. Là, à l’inverse, l’ordinateur les suivait en détectant leur tempo en temps réel et se synchronisait avec eux : la musique synthétique leur obéissait enfin. Un bel exemple fut Tensio de Philippe Manoury créé à l’Ircam en 2010. Antescofo a été vite adopté par les compositeurs et est maintenant aussi disponible pour le grand public sous le nom de Metronaut.

“On surestime ce que l’IA peut faire en musique.”

Les algorithmes auraient-ils enfin tout résolu ?

Non, il s’en faut. Par exemple se pose dans tout cela le problème des RIM, les « réalisateurs en informatique musicale », qui sont le pendant des interprètes « classiques », mais du côté du système informatique : comment écrit-on pour eux la partie algorithmique d’une œuvre, alors qu’on peut tout y faire ? Il n’y a pas de notation pour tout ! Le langage habituel de la musique classique, la partition n’est en fait qu’une tablature d’instruments, avec quelques indications ajoutées à l’usage de l’interprète. On est loin d’avoir l’équivalent pour la partie informatique, même si les techniques que moi-même et d’autres ont développées pour l’informatique temps réel dans l’industrie s’y révèlent utiles. On est devant un nouveau problème, qui est l’exact opposé de celui de l’apprentissage en IA, qui consiste d’abord à comprendre comme on fait déjà : comment faire quand on peut tout faire en théorie et en pratique ? Comment écrire ? Chacun a inventé des syntaxes. Ainsi, Stockhausen avait ses cahiers de notation et Manoury fait des choses très intéressantes en utilisant des chaînes de Markov, automates finis probabilistes qui permettent un beau mélange entre régularité et surprise. Voir aussi par exemple les travaux récents du compositeur Sasha J. Blondeau, qui a bien utilisé des concepts mathématiques fins empruntés à la topologie, comme les complexes simpliciaux. Écrire est une chose, mais il faut aussi pouvoir lire, surtout pour les interprètes ! Comment conserver la part de l’intuitif, essentiel au mathématicien comme au musicien ?

Quel intérêt vois-tu à l’IA en musique ?

L’IA sait bien reproduire « à la façon de », mais il me semble qu’on surestime beaucoup ce qu’elle peut actuellement faire en musique exigeante. Les chercheurs en IA sont forts, mais beaucoup d’autres gens font des annonces fracassantes alors qu’ils n’en sont qu’au stade de la première exploration. Entre réplication et invention, le domaine de l’IA en musique est encore tout neuf. Laissons-le vivre et créer, sans le sous-estimer ni le surestimer !

Ressources

Séminaire « Optogenetics », Botond Roska, Collège de France, 30 mars 2016.

Séminaire « Une fréquence peut-elle être instantanée ? », Patrick Flandrin, Collège de France, 22 janvier 2014.

Séminaire « Problématiques liées au temps réel dans la musique », Gérard Berry et Arshia Cont, Collège de France, diffusé

le 4 janvier 2019 sur France Culture.

Tensio, Philippe Manoury

Commentaire

Ajouter un commentaire

Bonjour, deux compléments à cet article très intéressant

1.je voudrais rappeler le rôle éminent de Iannis Xénakis qui a été le pionnier de la composition assistée par ordinateur dès la fin des années 50. Il travaillait avec le CEMAMU de la Sorbonne qui lui produisait les modèles mathématiques. Il a utilisé des algorithmes de production des sons dans ses premières compositions, comme la musique du pavillon Philips de Bruxelles en 58, qui généraient des glissandos figurant les droites du paraboloide hyperbolique qui constituait l’architecture d pavillon . J’ai eu la possibilité en tant que pianiste d’analyser Eonta que j’ai joué en sa présence en 1978. J’avais reconnu dans la partition des transformations de cellules du 2° concerto de Brahms et Iannis s’en été amusé !

2. En ce qui concerne la 4X, Pierre Boulez m’avait demandé en 1981 de faire, avec les équipes de l’ENST, un audit afin d’en envisager des applications industrielles. Le résultat a été décevant en ce sens que la très grande complexité de la machine ne se prêtait pas à la miniaturisation nécessaire, en l’état de l’électronique de l’époque.

Bien amicalement.