L’hyperpuissance de l’informatique

Passionné par la programmation et célèbre pour la publication du langage ESTEREL, Gérard BERRY nous livre son jugement sur l’appréciation que les français ont de l’informatique. Par exemple les ingénieurs restent trop marqués par leur formation initiale mécanicienne, les innovateurs sont très start mais pas assez up.

Pourquoi es-tu venu à l’informatique ?

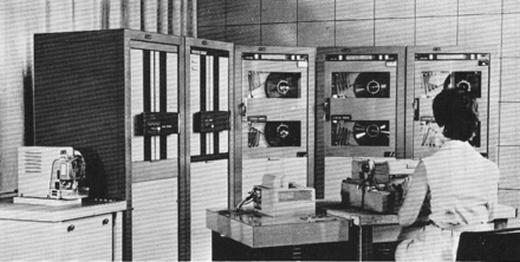

J’ai découvert l’informatique à l’X dans les années 67–68 en dilettante. J’ai tout de suite compris que la programmation, c’était « mon truc » ! Mais je travaillais sur un étrange ordinateur SETI PB250 : c’était juste impossible de travailler sérieusement avec ce genre de machine…

Quand je suis entré aux Mines en 1970, Pierre Laffitte a été tout de suite d’accord pour que je fasse de l’informatique. J’ai rencontré Maurice Nivat à l’Iria (aujourd’hui Inria) qui venait de se créer : de toute évidence, c’est là que ça allait se passer, en particulier dans le fameux bâtiment 8 de Voluceau, situé dans l’ancien Grand quartier général de l’Otan en Europe.

“ En informatique, il ne suffit pas d’essayer pour réussir ! ”

Mes collègues y étaient Philippe Flajolet (68), Gérard Huet, Gilles Kahn, Jean Vuillemin (66), etc., qui allaient devenir de grands chercheurs et parmi lesquels il y avait d’ailleurs beaucoup d’X. Mais nous n’avions toujours pas d’ordinateurs adéquats pour travailler : c’était la grande époque du plan Calcul, qui n’était pas pour nous…

Mais soyons justes : cela nous a obligés à faire de grands progrès en informatique théorique ! Pierre Boulez, à l’Ircam, avait quand même réussi à obtenir un PDP-10, la machine voulue sur laquelle a démarré une bonne partie de l’informatique française.

C’est encore Pierre Laffitte, toujours visionnaire, qui a créé le Centre de mathématiques appliquées (CMA) de l’École des mines à Sophia-Antipolis, en rassemblant automaticiens et informaticiens : c’était extraordinaire, on y trouvait un environnement de travail exceptionnel, et le lieu créait une forte attractivité internationale. Enfin, les premières machines convenables sont arrivées en 1983.

Je travaillais sur un étrange ordinateur SETI PB250 :

c’était juste impossible de travailler sérieusement avec ce genre de machine…

Mais tu ne t’intéresses pas seulement à la programmation ?

Je me suis rendu compte que ce qui m’intéressait vraiment, c’était de travailler avec les objets, et pas seulement avec les algorithmes abstraits : on travaillait par exemple sur la conduite de minivoitures-robots. C’est en travaillant sur ce genre de sujet que j’ai mûri mon langage Esterel.

Une grande innovation est arrivée à la fin des années 1980 avec les circuits reprogrammables (FPGA = Field- Programmable Gate Array), utilisés par Jean Vuillemin chez Digital Equipement pour accélérer les calculs. On pouvait enfin mêler finement logiciel et matériel.

J’ai adapté Esterel à la conception et à la synthèse de circuits efficaces. J’ai obtenu des financements de type grants industriels de plusieurs sociétés industrielles, comme Synopsys et Cadence en CAO de circuits et Intel en conception de microarchitectures, au total 150 000 dollars par an sans même de dossiers à remplir.

Pour mieux développer Esterel dans les circuits et les logiciels critiques, avec Éric Bantégnie (X 82 – Télécoms – Mines), qui avait repris Simulog, nous avons créé Esterel Technologies. En circuits, la partie dont je m’occupais principalement, nous avons travaillé avec Texas Instruments, ST Microelectronics, Philips et Intel. J’y ai été directeur scientifique et ai passé beaucoup de temps en visites de clients.

En 2008, c’est la crise après le crash de Lehman Brothers. Le monde change alors profondément dans le domaine des circuits. Texas Instruments disparaît progressivement, Nokia est marginalisé, Philips aussi et la coopération industrielle avec Intel se révèle difficile. Nous devons fermer l’activité circuits.

Mais c’est aussi l’arrivée en force du SmartPhone (sait-on que l’iPhone a été créé à Paris par Jean-Marie Hullot, avec qui j’avais eu la joie de travailler à l’Inria à la fin des années 1970 ?). Je décide alors d’entrer à l’Inria en mars 2009 pour revenir à la recherche et présider la Commission d’évaluation de l’institut, qui y joue un rôle central et apprécié.

Comment es-tu venu au Collège de France ?

J’y avais été d’abord invité en 2007–2008, dans le cadre de la chaire annuelle d’innovation technologique Liliane-Bettencourt. J’avais entrepris d’y enseigner « Pourquoi et comment le monde devient numérique ».

À la suite du succès de ce cours, le Collège de France et l’Inria décident de créer une nouvelle chaire « Informatique et sciences numériques », dont j’ai tenu la première édition en 2009–2010 avec un cours « Penser, modéliser et maîtriser le calcul informatique ». Cette chaire a eu depuis huit autres titulaires et est en pleine forme.

En 2012, le Collège m’a confié une chaire permanente, sous l’intitulé : « Algorithmes, Machines et Langages ». Le domaine informatique y est en plein essor, avec notamment la nouvelle chaire « Science des données », confiée à Stéphane Mallat (81). Il s’y intéresse à l’apprentissage automatique et cherche pourquoi l’apprentissage profond marche aussi bien, ce qu’on est encore loin de comprendre.

Et une nouvelle chaire « Science du logiciel » va ouvrir à la rentrée 2018. Tout cela est pour moi une expérience fantastique !

Parle-nous de l’informatique dans l’enseignement

J’ai présidé pendant quelques années le conseil d’enseignement et de recherche de l’X.

J’y ai travaillé une question fondamentale pour l’École : comment mieux organiser la recherche à l’X ? J’ai aussi travaillé à la mise en place du nouveau bachelor.

“On est loin de comprendre pourquoi l’apprentissage profond marche aussi bien !”

À l’X, comme dans les grandes écoles en général, la prise en compte de l’informatique a été lente : les mentalités restaient très prisonnières de l’approche « ingénieur » centrée sur la matière et l’énergie.

Les (très bons) dossiers récemment consacrés au numérique par La Jaune et la Rouge sont très illustratifs : par exemple, celui sur la simulation (JR n° 732) reste globalement très marqué par une vision d’ingénieurs classiques, d’abord mécaniciens, électriciens, etc.

L’informatique n’y est certainement pas au cœur du sujet. Mais, dans ce dossier, l’article sur la mobilité durable écrit par quelqu’un de chez Renault montre bien qu’on passe d’une vision de l’automobile mécanicienne à une vision centrée sur l’information. C’est ce qu’ont bien compris des gens comme Google ou Uber : l’important n’est pas de savoir construire un véhicule qui roule (tout le monde sait faire ça aujourd’hui, et avec pratiquement les mêmes solutions techniques), mais de savoir qui veut aller où et quand.

C’est là que réside désormais la valeur. Du coup, on peut être certain que les flottes de taxis robotisés vont faire baisser le nombre de voitures particulières : c’est un vrai défi pour les constructeurs traditionnels.

Alors, l’informatique reste une grande méconnue ?

On observe une mécompréhension très répandue du sujet, d’abord par manque de connaissances. Ainsi, encore en 1985, on débattait très sérieusement de « Faut-il enseigner l’informatique à l’X ? » Il faut reconnaître que les universités ont été les premières à s’y atteler.

Pour Yan LeCun : « La vraie intelligence est loin d’être à portée. »

Les grandes écoles, y compris l’X et les Mines, ont été beaucoup plus timides, mais sont bien présentes maintenant. Je m’occupe aussi beaucoup de l’enseignement de l’informatique du primaire au bac.

Il y a une méconnaissance générale de ce que recouvre le « numérique », et une défiance du mot « informatique ». Je suis frappé de voir que, quand je suis invité à une radio ou à donner une conférence, on me demande toujours de commencer par définir le terme algorithme, alors qu’il ne vient à l’idée de personne de demander à un biologiste, par exemple, de définir ce qu’est une cellule. Et on l’écrit encore souvent algorythme (dans la peau) !

J’ai trouvé l’article de François Bourdoncle (84) dans la JR sur l’Intelligence artificielle (n° 733) très intéressant. Il montre bien combien les questions d’investissements dans la recherche en IA sont importantes : il y a une vraie différence d’approche entre les logiques d’investissement aux États-Unis et en France.

Malgré des progrès réels, nous avons toujours un vrai problème de financement de la recherche. Nous sommes trop dans l’incantation, en particulier sur l’innovation de rupture, alors que celle-ci ne se décrète pas : elle se construit dans un processus long et profond. Je me souviens que mes partenaires américains me disaient : « Les Français ? Ils sont excellents, en maths et en programmation, mais ils ne sont pas des concurrents ! »

Nous avons encore du mal avec les « start-up » : beaucoup de « starts », et de très bonne qualité, mais moins de « up » car là, il faut savoir trouver de gros financements, manager, passer au développement industriel, trouver des marchés…

Mais est-ce que les choses changent ?

Il y a aujourd’hui un vrai désir de pousser l’attractivité française en informatique. Mais, où va-t-on trouver des profs du bon niveau ? Aujourd’hui, ce sont le plus souvent les labos d’entreprises étrangères comme Google qui tirent la recherche et embauchent.

Il est quand même frappant qu’il n’y ait qu’une seule entreprise française dans le top 100 des boîtes d’informatique ! Les Allemands ont mieux réussi, par exemple avec le Max-Planck Institute à Sarrebruck, qui offre des conditions de travail réellement de bon niveau international.

Sur l’intelligence artificielle, dont on parle aujourd’hui beaucoup à tort et à raison (mais pas La Jaune et la Rouge dans son n° 733!) il faut écouter Yan LeCun.

Son message est clair : il faut avoir d’excellentes données, la quantité ne suffit pas, et la vraie intelligence est loin d’être à portée ; il rêve plutôt d’atteindre un jour « le bon sens du chat ».

Ceux qui glosent sur le sujet, en majorité, ne savent pas du tout de quoi il s’agit, alors que les gens qui travaillent réellement sur ce domaine le font avec modestie et sérieux. Le succès n’est jamais immédiat : en informatique, il ne suffit pas d’essayer pour réussir !