Numérique et santé, l’exemple du cerveau

Deux types d’action sont envisagées, l’un à l’échelon individuel où les objets connectés que l’on porte peuvent analyser notre comportement quotidien et détecter les premiers stades d’une pathologie avant ses symptômes explicites, l’autre à l’échelon de cohortes pour avoir des banques de données ou analyser l’effet des thérapies.

Nos téléphones abritent des applications de santé ou de fitness qui utilisent des capteurs embarqués (accéléromètre, gyroscope…) pour quantifier des caractéristiques de notre déplacement voire de nos tremblements.

“ Détecter les premiers stades d’une pathologie avant ses symptômes explicites ”

De vastes projets d’épidémiologie conduisent aujourd’hui à insérer dans nos téléphones des « mouchards bienveillants » décryptant la manière dont nous utilisons nos applications favorites, de manière à déceler les premiers signes de difficultés cognitives, qui peuvent être les prémisses de démences neurologiques ou de difficultés d’ordre psychiatrique.

Nos téléphones seront bientôt secondés par une armée d’objets connectés qui enregistreront nos interactions avec notre environnement quotidien.

REPÈRES

Les succès récents de l’intelligence artificielle ont fait miroiter une myriade de révolutions à venir dans le domaine de la santé. Les retombées économiques escomptées sont d’une telle ampleur que les GAFA en ont fait une priorité stratégique conduisant par exemple Google à créer une filiale dédiée (Verily).

Ce qui se trame aujourd’hui impactera lourdement le futur économique des systèmes de santé européens. Mais les données qui vont ensemencer ces bouleversements ne sont pas uniquement celles classiquement utilisées par le milieu hospitalier.

PRÉDICTION ET PRÉVENTION

La collecte et l’exploitation de ces océans de données nécessiteront une logistique et des puissances de calcul époustouflantes, mais les enjeux sont tels qu’il ne fait guère de doute que les investissements suivront.

De vastes projets d’épidémiologie conduisent aujourd’hui à insérer dans nos téléphones des “ mouchards bienveillants ” © ALEXEY_BOLDIN

Ces informations multifacettes mettront en évidence des prédispositions, et permettront de détecter les premiers stades d’une pathologie avant ses symptômes explicites ou encore de réaliser un ajustement sur mesure des traitements.

La médecine du futur qui en découlera, fondée sur la prédiction et la prévention, semble inéluctable. Mais l’idée qu’elle justifie un « monitoring » incessant de toutes nos activités est assez déstabilisante et nécessitera des garde-fous.

Le plan médecine génomique français initié en 2016, qui vise à séquencer le génome de millions de patients, soulève les mêmes interrogations. Le séquençage de l’ensemble de la population semble en effet être à notre portée.

Le premier étage de la médecine du futur évoqué jusqu’ici conduira à déclencher des alertes nous conduisant à prendre contact de manière préventive avec un système de santé lui aussi fortement impacté par le numérique.

UNE INFLATION DE DONNÉES

La « neuroimagerie », qui regroupe les technologies permettant d’explorer la structure ou le fonctionnement cérébral, génère des données de plus en plus massives. Cette inflation nécessite aujourd’hui des moyens informatiques de plus en plus conséquents, qui conduit à des rapprochements avec les grands centres de calcul traditionnellement dédiés à la physique.

Dans le domaine de la recherche fondamentale, on crée aujourd’hui des images microscopiques du cerveau post-mortem avec une résolution de l’ordre du micron. En empilant quelques milliers de coupes de quelques dizaines de gigaoctets chacune, pour obtenir une image tridimensionnelle, on se retrouve avec plusieurs centaines de teraoctets qui nécessitent souvent un calculateur haute performance pour être manipulées.

La visualisation de telles données requiert d’ailleurs des approches de type Google Earth.

Arrivée de l’aimant Iseult à NeuroSpin après un voyage de plusieurs centaines de kilomètres depuis Belfort.

© CEA-PATRICK DUMAS

ISEULT, UN GRAND INSTRUMENT DÉDIÉ À L’EXPLORATION DU CERVEAU HUMAIN

L’aimant Iseult de 11,75 T corps entier en phase d’installation à NeuroSpin en 2017 est la pièce maîtresse d’un système d’imagerie par résonance magnétique (IRM) qui repoussera les limites de l’imagerie cérébrale.

L’aimant va prendre place dans une arche spécialement édifiée pour l’abriter mais il faudra sans doute encore deux ans pour installer l’ensemble de l’imageur IRM et obtenir les premières images de très haute qualité espérées.

La réalisation de cet aimant de cinq mètres de long, sur cinq mètres de diamètre et pesant plus de 130 tonnes est une prouesse technologique. Les ingénieurs chercheurs du CEA ont conçu une bobine dans laquelle circule un courant d’une très grande intensité, de l’ordre de 1 500 ampères.

L’utilisation de la supraconduction, indispensable pour atteindre des intensités aussi élevées, implique de maintenir l’aimant à 1,8 K (soit – 271,35 °C) grâce à un bain d’hélium liquide, dit superfluide.

IMAGERIE IN VIVO

Sans atteindre de tels extrêmes, l’imagerie in vivo n’est pas à la traîne. Un examen IRM conventionnel destiné à une lecture radiologique n’est guère plus volumineux qu’une photographie numérique moderne, bien qu’il soit tridimensionnel.

Mais les nouvelles modalités qui se sont généralisées dans le monde de la recherche génèrent beaucoup plus de données. L’IRM fonctionnelle, qui permet de mettre en évidence les réseaux fonctionnels que recèle notre cerveau, en imageant les variations de consommation d’oxygène au cours du temps, produit des centaines voire des milliers d’images tridimensionnelles.

La magnétoencéphalographie (MEG), qui propose quelques centaines de capteurs enregistrant les décharges de populations de neurones avec une résolution temporelle de l’ordre de la milliseconde, est encore plus vorace en espace disque.

L’IRM de diffusion, qui permet de cartographier la connectivité de notre cerveau, en imageant l’anisotropie des mouvements aléatoires de l’eau au sein des faisceaux de fibres, produit des images tridimensionnelles gigognes : chaque voxel, l’équivalent tridimensionnel d’un pixel, contient lui-même une image tridimensionnelle de la mobilité de l’eau dans le cube de cerveau correspondant.

Et la croissance n’est pas en passe de ralentir. Pour accélérer et améliorer le processus de construction des images IRM, on utilise des antennes parallèles qui peuvent générer jusqu’à une centaine d’images simultanément. Cette technologie sera impérative pour profiter à plein de l’aimant à 11,7 teslas qui a été installé à NeuroSpin en 2017 (cf. encadré) et dont un des principaux objectifs est de zoomer, donc d’augmenter la résolution spatiale des images…

DES MYRIADES DE SUJETS ÉTUDIÉS

À la taille des examens, il faut ajouter le nombre de sujets impliqués dans les études actuelles.

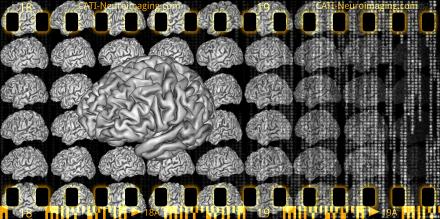

L’IRM produit des centaines ou des milliers d’images tridimensionnelles

© ROMASET

Il est désormais fréquent de lancer une campagne d’acquisition sur plusieurs milliers de sujets. Cette inflation est d’ailleurs en partie induite par une nouvelle stratégie de recherche qui consiste à acquérir de front des images cérébrales et une cartographie massive du génome.

Quand on réalise que le nombre de sujets usuellement nécessaire dans les études génétiques est de l’ordre de plusieurs dizaines de milliers, pour des raisons de sensibilité, on imagine aisément la suite. Dans le cadre d’une étude épidémiologique du vieillissement, la Grande-Bretagne vient par exemple d’initier une cohorte nationale d’imagerie sur 100 000 sujets appelée UK Biobank.

Le Human Brain Project, un projet phare de la Communauté européenne, cherche à agréger les images acquises par une centaine d’hôpitaux et vise des millions de patients. Pour pouvoir préserver le secret médical, ce projet développe des technologies innovantes permettant d’analyser l’ensemble de ces images de concert sans qu’elles quittent leur hôpital d’origine.

UN ACCÈS PARTAGÉ AUX DONNÉES

Le coût exorbitant des projets d’acquisition portant sur des milliers d’individus induit par ailleurs une évolution primordiale : les agences qui financent ces projets imposent de plus en plus souvent un libre accès aux données pour l’ensemble de la communauté internationale.

La stratégie du libre accès démultiplie l’impact de la base de données ce qui justifie son coût. En outre, plusieurs initiatives visent à harmoniser les procédures d’acquisition et d’analyse afin de pouvoir combiner les données issues de plusieurs projets (cf. encadré en fin d’article).

Mais le partage ne peut pas se limiter aux données, car les besoins en calcul et en stockage nécessaires à leur analyse dépassent les capacités usuelles des laboratoires. La communauté est aujourd’hui à la recherche de solutions de type cloud pour mutualiser ses investissements et ses efforts.

BIG DATA ET BIOMARQUEURS

Dans un monde où les maladies cérébrales, qu’elles soient neurodégénératives ou psychiatriques, impactent lourdement nos sociétés, le big data est une nouvelle tentative crédible de faire émerger des biomarqueurs permettant d’accompagner les essais thérapeutiques.

« La frontière entre thérapie et “augmentation” de la nature humaine est de plus en plus ténue »

Au cours des dernières années, de nombreuses publications ont montré que des techniques d’apprentissage par ordinateur permettent de découvrir au sein de ces données des motifs cachés inédits, hors de portée pour l’œil du radiologue, véritables signatures des pathologies. Ces motifs sont susceptibles de permettre un diagnostic précoce survenant avant les signes cliniques et augmentant les chances de succès pour les thérapies.

C’est par exemple le rôle de l’imagerie dans le domaine de la maladie d’Alzheimer, où après des échecs répétés des essais thérapeutiques sur les patients avancés dans la maladie, les tentatives actuelles visent des sujets ne présentant pas encore de symptômes très clairs mais dont les images cérébrales vont dans le sens d’une maladie d’Alzheimer.

NOUVELLES THÉRAPIES

L’impact du numérique dans le monde clinique n’est pas cantonné au diagnostic mais touche également les thérapies, du fait de la multiplication des interfaces cerveau-machine, qui permettent à un individu de contrôler par la pensée un ordinateur, une prothèse ou tout autre système automatisé, sans solliciter ses bras, mains ou jambes.

Ces interfaces, qui reposent sur des capteurs enregistrant l’activité cérébrale, font une utilisation massive de l’apprentissage par ordinateur pour convertir les signaux en action. Les plus ambitieuses, qui reposent sur des électrodes implantées, visent le contrôle d’un exosquelette redonnant la mobilité à un tétraplégique.

La frontière entre thérapie et « augmentation » de la nature humaine est d’ailleurs de plus en plus ténue. Ray Kurzweil, ingénieur en chef de Google, évoque l’hybridation imminente de nos cerveaux avec des nanocomposants électroniques nous connectant en permanence à un cloud computationnel.

Nos pensées ne seraient alors plus exclusivement d’origine biologique…

CATI, UNE PLATEFORME DE SERVICES POUR L’IMAGERIE DES COHORTES

Des techniques d’apprentissage par ordinateur découvrent dans les grandes bases d’images du cerveau des signatures hors de portée pour l’œil du radiologue. © JF MANGIN, C. FISCHER, D. RIVIÈRE